A equipe DeepMind do Google lançou recentemente o conjunto de dados WebBli-100B, que contém 100 bilhões de pares de textos de imagem, marcando um grande avanço no campo dos modelos de linguagem visual de inteligência artificial. O objetivo principal desse conjunto de dados é melhorar significativamente o desempenho dos modelos de IA ao lidar com diferentes tarefas culturais e multilíngues por meio de recursos de dados ricos, promovendo assim a inclusão e a diversidade de tecnologias de inteligência artificial.

Os modelos de linguagem visual (VLMs) são pontes que conectam imagens e textos e são amplamente utilizados em tarefas como geração de legenda de imagem, perguntas e respostas visuais. O desempenho desses modelos depende em grande parte da qualidade e quantidade de dados de treinamento. No passado, os pesquisadores se basearam principalmente em grandes conjuntos de dados, como legendas conceituais e Laion. demanda.

O lançamento do conjunto de dados WebBli-100B é precisamente resolver esse problema de gargalo. Diferentemente dos conjuntos de dados anteriores, o WEBLI-100B não adota mais um mecanismo rigoroso de filtragem, que geralmente elimina detalhes culturais importantes. Em vez disso, ele se concentra mais na expansão da cobertura de dados, especialmente em áreas como linguagem de baixo resistência e diversas expressões culturais. A equipe de pesquisa conduziu o modelo pré-treinamento em diferentes subconjuntos de WebBLI-100B para analisar profundamente o impacto da escala de dados no desempenho do modelo.

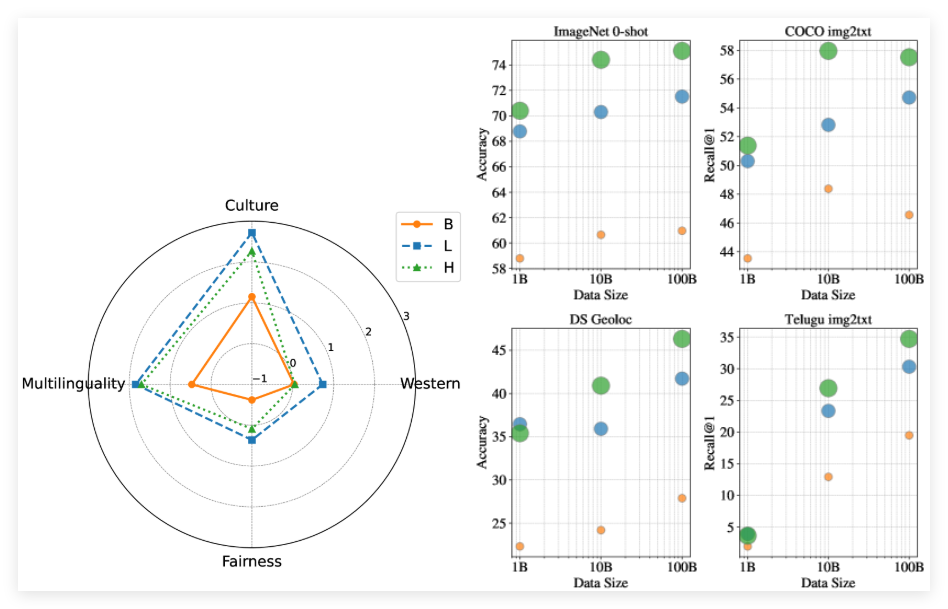

Os resultados experimentais mostram que os modelos treinados com o conjunto de dados WebBli-100B completo tiveram um desempenho significativamente melhor nas tarefas culturais e multilíngues do que aquelas treinadas em conjuntos de dados menores, mesmo com os mesmos recursos de computação. Além disso, o estudo constatou que a expansão do conjunto de dados de 10b para 100b teve menos impacto nos benchmarks centrados no oeste, mas trouxe melhorias significativas nas tarefas de diversidade cultural e recuperação de idiomas com baixo resistência.

Papel: https://arxiv.org/abs/2502.07617

Pontos -chave:

** Novo conjunto de dados **: WebLI-100B é um enorme conjunto de dados contendo 100 bilhões de pares de texto-texto, projetados para aprimorar a diversidade cultural e a multilíngues dos modelos de IA.

** Modelo de melhoria de desempenho **: Modelos treinados com o conjunto de dados WebLI-100B têm um desempenho melhor do que os conjuntos de dados anteriores em tarefas multiculturais e multilíngues.

** Reduza o viés **: O conjunto de dados do WebLI-100B evita filtragem rigorosa, mantém mais detalhes culturais e melhora a inclusão e a precisão do modelo.