Google의 Deepmind 팀은 최근 1,000 억 개의 이미지 텍스트 쌍이 포함 된 Webli-100B 데이터 세트를 출시하여 인공 지능 시각 언어 모델 분야에서 주요 획기적인 획기적인 획기적인 것으로 나타났습니다. 이 데이터 세트의 핵심 목표는 풍부한 데이터 리소스를 통해 다양한 문화 및 다국어 작업을 처리 할 때 AI 모델의 성능을 크게 향상시켜 인공 지능 기술의 포괄 성과 다양성을 촉진하는 것입니다.

시각적 언어 모델 (VLM)은 이미지와 텍스트를 연결하는 브릿지이며 이미지 자막 생성, 시각적 질문 및 답변과 같은 작업에 널리 사용됩니다. 이러한 모델의 성능은 교육 데이터의 품질과 양에 크게 달라집니다. 과거에는 개념적 캡션 및 Laion과 같은 대규모 데이터 세트에 주로 의존했습니다.이 데이터 세트에는 수백만 개의 이미지 텍스트 쌍이 포함되어 있지만 규모는 점차 한계에 접근했으며 모델 정확도와 포함의 추가 개선을 충족시킬 수 없습니다. 수요.

WebLi-100B 데이터 세트의 출시는이 병목 현상 문제를 해결하기위한 것입니다. 이전 데이터 세트와 달리 WebLi-100B는 더 이상 엄격한 필터링 메커니즘을 채택하지 않으므로 종종 중요한 문화적 세부 사항을 제거합니다. 대신, 특히 자원이 적은 언어 및 다양한 문화적 표현과 같은 영역에서 데이터 범위를 확장하는 데 더 중점을 둡니다. 연구팀은 모델 성능에 대한 데이터 스케일의 영향을 깊이 분석하기 위해 WEBBLI-100B의 다양한 하위 집합에 대한 모델 사전 훈련을 수행했습니다.

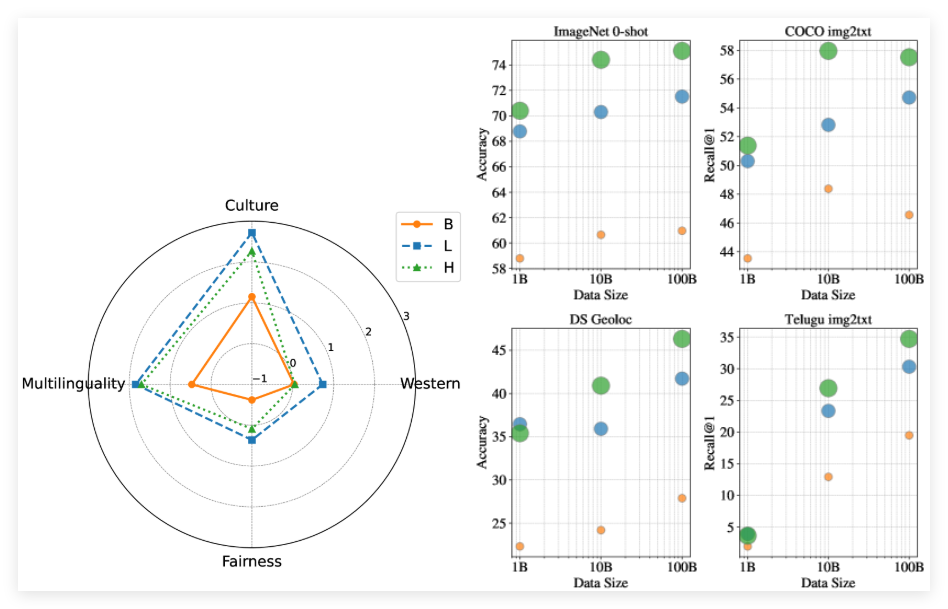

실험 결과에 따르면 전체 Webli-100B 데이터 세트로 훈련 된 모델은 동일한 컴퓨팅 리소스에서도 소규모 데이터 세트에서 훈련 된 것보다 문화 및 다국어 작업에서 훨씬 더 잘 수행되었음을 보여줍니다. 또한,이 연구는 데이터 세트를 10b에서 100b로 확장하는 것이 서부 중심의 벤치 마크에 미치는 영향이 적지 만 문화적 다양성 작업과 저주적 언어 검색에서 크게 개선 된 것으로 나타났습니다.

종이 : https://arxiv.org/abs/2502.07617

핵심 사항 :

** 새로운 데이터 세트 ** : WebLi-100B는 AI 모델의 문화적 다양성과 다국어를 향상 시키도록 설계된 1,000 억 이미지 텍스트 쌍을 포함하는 거대한 데이터 세트입니다.

** 모델 성능 개선 ** : WebLi-100B 데이터 세트로 교육을받은 모델은 다문화 및 다국어 작업에서 이전 데이터 세트보다 더 잘 수행됩니다.

** 편견 감소 ** : WebLi-100B의 데이터 세트는 엄격한 필터링을 피하고 더 많은 문화적 세부 사항을 유지하며 모델의 포괄 성과 정확성을 향상시킵니다.