GoogleのDeepmindチームは最近、1,000億の画像テキストペアを含むWebli-100Bデータセットをリリースし、人工知能の視覚言語モデルの分野で大きなブレークスルーをマークしました。このデータセットの中心的な目標は、豊富なデータリソースを通じてさまざまな文化的および多言語タスクを扱う際にAIモデルのパフォーマンスを大幅に改善し、それによって人工知能技術の包括性と多様性を促進することです。

Visual Language Models(VLMS)は、画像とテキストを接続するブリッジであり、画像サブタイトルの生成、視覚的な質問、回答などのタスクで広く使用されています。これらのモデルのパフォーマンスは、トレーニングデータの品質と量に大きく依存します。過去には、研究者は主に概念キャプションやLaionなどの大規模なデータセットに依存していましたが、これらのデータセットには数億の画像テキストペアが含まれていましたが、そのスケールは徐々に制限に近づき、モデルの精度と包摂のさらなる改善を満たすことができません。要求。

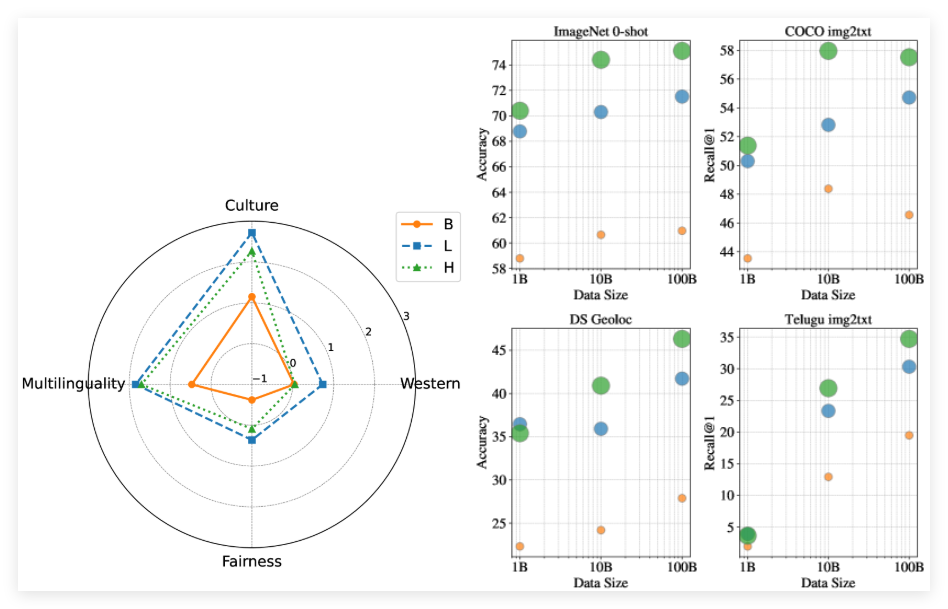

Webli-100Bデータセットの発売は、このボトルネックの問題を正確に解決するためのものです。以前のデータセットとは異なり、Webli-100Bは、重要な文化的詳細を排除することが多い厳格なフィルタリングメカニズムを採用しなくなりました。代わりに、特に低リソース言語や多様な文化的表現などの分野で、データのカバレッジの拡大に重点を置いています。研究チームは、Webli-100Bのさまざまなサブセットでモデル前トレーニングを実施し、モデルのパフォーマンスに対するデータスケールの影響を深く分析しました。

実験結果は、同じコンピューティングリソースであっても、小さなデータセットでトレーニングされたタスクよりも、Webli-100Bの完全なデータセットでトレーニングされたモデルが、文化的および多言語タスクよりも大幅に優れていることを示しています。さらに、この調査では、データセットを10Bから100Bに拡張すると、西部中心のベンチマークへの影響が少ないが、文化的多様性タスクと低リソースの言語検索の大幅な改善がもたらされることがわかりました。

論文:https://arxiv.org/abs/2502.07617

キーポイント:

**真新しいデータセット**:Webli-100Bは、AIモデルの文化的多様性と多言語性を高めるために設計された1,000億の画像テキストペアを含む巨大なデータセットです。

**モデルのパフォーマンス改善**:Webli-100Bデータセットでトレーニングされたモデルは、多文化および多言語のタスクで以前のデータセットよりも優れたパフォーマンスを発揮します。

**バイアスの削減**:Webli-100Bのデータセットは、厳格なフィルタリングを回避し、より多くの文化的詳細を保持し、モデルの包括性と精度を向上させます。