Das DeepMind-Team von Google hat kürzlich den Webli-100B-Datensatz veröffentlicht, der 100 Milliarden Image-Text-Paare enthält und einen großen Durchbruch im Bereich der visuellen Sprachmodelle für künstliche Intelligenz markiert. Das Kernziel dieses Datensatzes ist es, die Leistung von KI -Modellen im Umgang mit unterschiedlichen kulturellen und mehrsprachigen Aufgaben durch reiche Datenressourcen erheblich zu verbessern und damit die Inklusivität und Vielfalt künstlicher Intelligenztechnologien zu fördern.

Visuelle Sprachmodelle (VLMs) sind Brücken, die Bilder und Texte verbinden und in Aufgaben wie Bilduntertitelerzeugung, visueller Frage und Antworten häufig verwendet werden. Die Leistung dieser Modelle hängt in hohem Maße von der Qualität und Menge der Trainingsdaten ab. In der Vergangenheit haben sich Forscher hauptsächlich auf große Datensätze wie konzeptionelle Untertitel und Laion verlassen. Nachfrage.

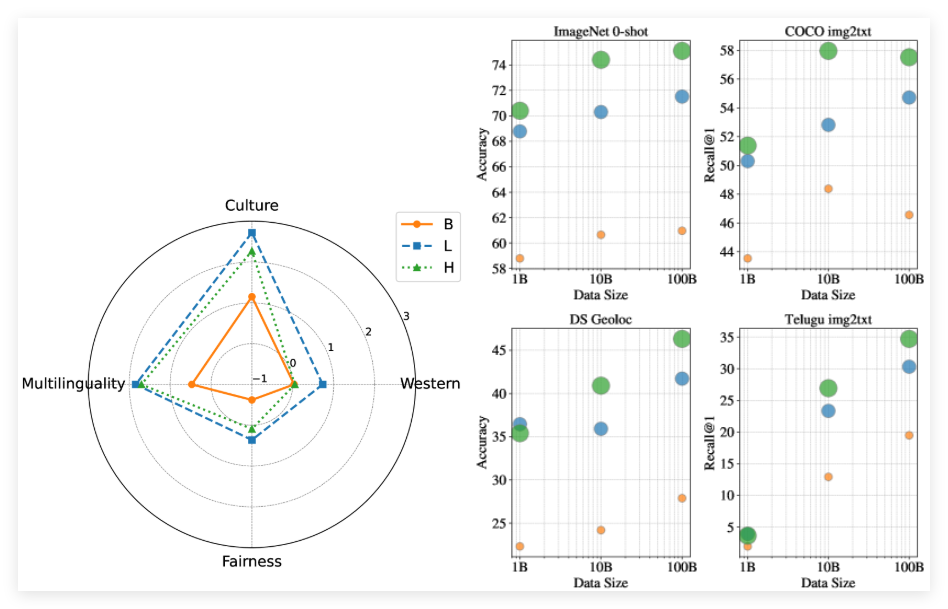

Der Start des Webli-100B-Datensatzes dient genau darin, dieses Engpassproblem zu lösen. Im Gegensatz zu früheren Datensätzen übernimmt WebBli-100B keinen strengen Filtermechanismus mehr, der häufig wichtige kulturelle Details beseitigt. Stattdessen konzentriert es sich mehr auf die Erweiterung der Berichterstattung über Daten, insbesondere in Bereichen wie Sprache mit niedriger Ressourcen und vielfältigen kulturellen Ausdrücken. Das Forschungsteam führte das Modell vor dem Training auf verschiedenen Teilmengen von Webli-100B durch, um die Auswirkungen der Datenskala auf die Modellleistung tief zu analysieren.

Experimentelle Ergebnisse zeigen, dass Modelle, die mit dem vollständigen Webli-100B-Datensatz trainiert wurden, bei kulturellen und mehrsprachigen Aufgaben erheblich besser abschnitten Darüber hinaus ergab die Studie, dass die Erweiterung des Datensatzes von 10B auf 100B weniger Einfluss auf westzentrierte Benchmarks hatte, jedoch erhebliche Verbesserungen der Aufgaben der kulturellen Vielfalt und der Wiedergutmachung mit niedrigem Ressourcen erzielte.

Papier: https://arxiv.org/abs/2502.07617

Schlüsselpunkte:

** Brandneuer Datensatz **: Webli-100b ist ein riesiger Datensatz mit 100 Milliarden Image-Text-Paaren, die die kulturelle Vielfalt und Mehrsprachigkeit von AI-Modellen verbessern sollen.

** Modellleistung Verbesserung **: Modelle, die mit Webli-100B-Datensatz trainiert wurden, werden besser abschneiden als frühere Datensätze in multikulturellen und mehrsprachigen Aufgaben.

** Reduzieren Sie Vorspannung **: Das Datensatz von Webli-100B vermeidet strikte Filterung, behält mehr kulturelle Details und verbessert die Inklusivität und Genauigkeit des Modells.