L'équipe DeepMind de Google a récemment publié l'ensemble de données Web-100B, qui contient 100 milliards de paires de texte d'image, marquant une percée majeure dans le domaine des modèles de langage visuel de l'intelligence artificielle. L'objectif central de cet ensemble de données est d'améliorer considérablement les performances des modèles d'IA dans le traitement des différentes tâches culturelles et multilingues grâce à de riches ressources de données, favorisant ainsi l'inclusivité et la diversité des technologies de l'intelligence artificielle.

Les modèles de langage visuel (VLMS) sont des ponts connectant des images et des textes, et sont largement utilisés dans des tâches telles que la génération de sous-titres d'image, la question visuelle et les réponses. Les performances de ces modèles dépendent dans une large mesure de la qualité et de la quantité de données de formation. Dans le passé, les chercheurs se sont appuyés principalement sur de grands ensembles de données tels que les légendes conceptuelles et le laion. demande.

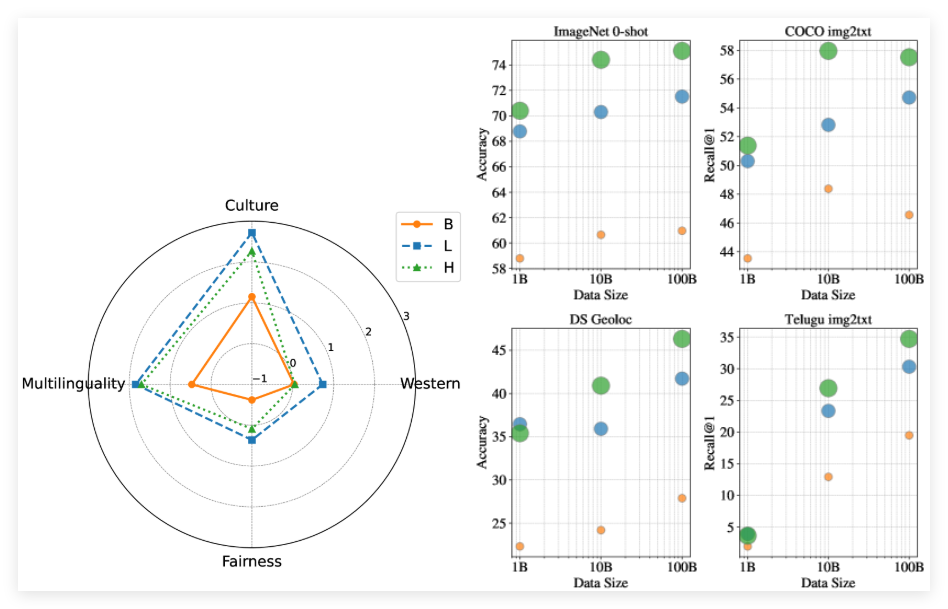

Le lancement de l'ensemble de données Web-100B est précisément pour résoudre ce problème d'étranglement. Contrairement aux ensembles de données précédents, Webbli-100B n'adopte plus un mécanisme de filtrage strict, ce qui élimine souvent les détails culturels importants. Au lieu de cela, il se concentre davantage sur l'élargissement de la couverture des données, en particulier dans des domaines tels que la langue à faible ressource et diverses expressions culturelles. L'équipe de recherche a effectué un modèle de pré-formation sur différents sous-ensembles de Webbli-100B pour analyser en profondeur l'impact de l'échelle de données sur les performances du modèle.

Les résultats expérimentaux montrent que les modèles formés avec l'ensemble de données Web-100B complet ont fonctionné beaucoup mieux sur les tâches culturelles et multilingues que celles formées sur des ensembles de données plus petits, même avec les mêmes ressources informatiques. De plus, l'étude a révélé que l'expansion de l'ensemble de données de 10b à 100b a eu moins d'impact sur les références centrées sur l'Ouest, mais a apporté des améliorations significatives dans les tâches de diversité culturelle et la récupération des langues à faible ressource.

Papier: https://arxiv.org/abs/2502.07617

Points clés:

** NOUVEAU ÉTAT DE DATAASE **: Webbli-100B est un énorme ensemble de données contenant 100 milliards de paires de texte d'image, conçues pour améliorer la diversité culturelle et la multilinguisation des modèles d'IA.

** Modèle Amélioration des performances **: Les modèles formés avec l'ensemble de données Web-100B fonctionnent mieux que les ensembles de données précédents dans des tâches multiculturelles et multilingues.

** Réduire le biais **: L'ensemble de données de Webbli-100B évite le filtrage strict, conserve plus de détails culturels et améliore l'inclusivité et la précision du modèle.