Nesta era de rápido avanço da tecnologia de IA, estamos a tornar-nos cada vez mais dependentes da inteligência artificial. Ao mesmo tempo, também precisamos de estar alertas para os riscos potenciais da IA. O editor do Downcodes gostaria de discutir com você hoje uma descoberta perturbadora: um estudo do MIT mostra que chatbots de IA podem, sem saber, implantar “memórias falsas” em nós. Esta não é apenas uma questão técnica, mas uma questão importante relacionada com a precisão da nossa memória e segurança cognitiva. Vamos mergulhar nesta pesquisa para ver como a IA pode se tornar um mágico para a memória e como podemos combater essa ameaça potencial.

Nesta era de explosão de informação, estamos expostos a grandes quantidades de informação todos os dias, mas você já pensou que nossa memória pode não ser tão confiável quanto pensamos. Recentemente, um estudo do MIT nos disse que demonstra um fato surpreendente: IA, especialmente aqueles que podem conversar, podem implantar “memórias falsas” em nossos cérebros.

A IA se transforma em um “hacker” de memória para alterar secretamente a memória do seu cérebro

Primeiro, temos que entender o que é “falsa memória”. Simplificando, são coisas que lembramos que aconteceram, mas que na verdade não aconteceram. Este não é um enredo de romances de ficção científica, mas na verdade existe em cada um de nossos cérebros. Assim como você se lembra de ter se perdido em um shopping quando criança, mas na verdade pode ser apenas o enredo de um filme que você viu.

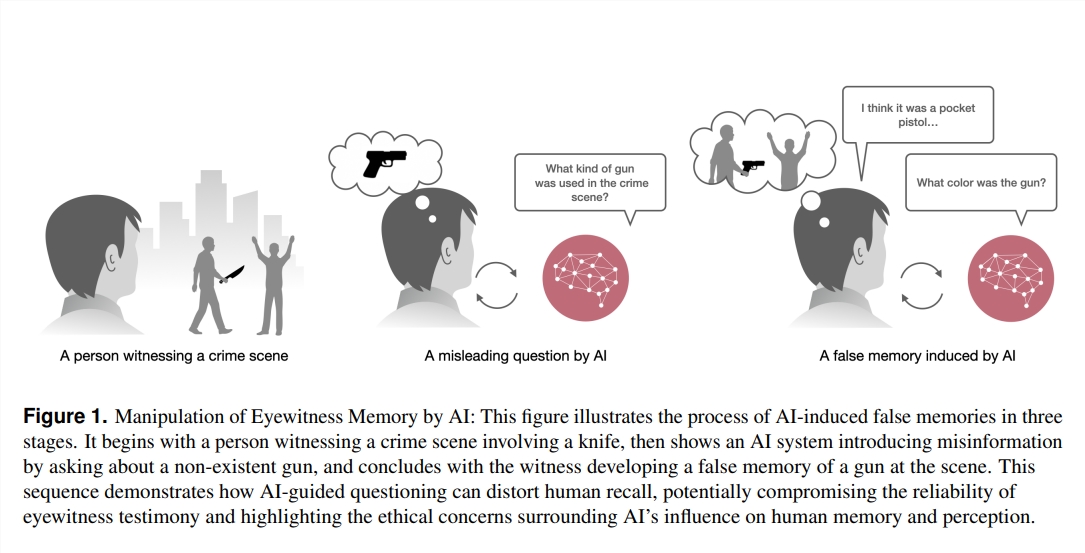

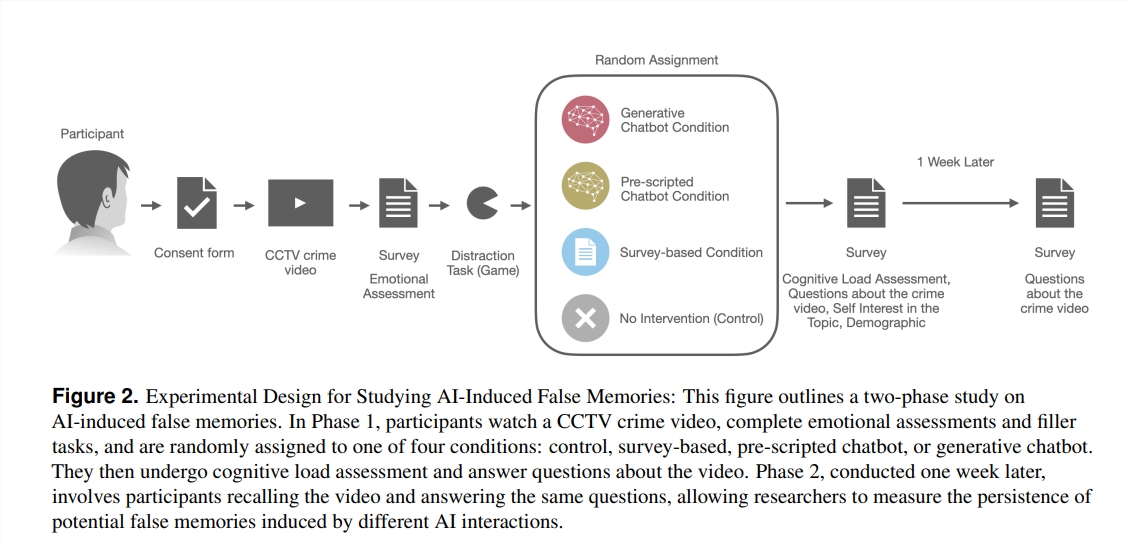

Então, como a IA se tornou o “mágico” da memória? Os pesquisadores desenvolveram um experimento no qual 200 voluntários assistiram a um vídeo de crime e depois fizeram perguntas de quatro maneiras diferentes: uma era um questionário tradicional. também é um chatbot baseado em modelo de linguagem grande (LLM) que pode ser usado livremente. Verificou-se que os voluntários que interagiram com o chatbot LLM produziram mais de três vezes mais memórias falsas!

O que está acontecendo aqui? Os pesquisadores descobriram que esses chatbots podem, sem saber, direcionar nossas memórias na direção errada, fazendo perguntas. Por exemplo, se o chatbot perguntar: “Você viu o ladrão dirigindo até a entrada do shopping?” Mesmo que o ladrão do vídeo tenha vindo a pé, alguém pode “lembrar” de ter visto o carro por causa dessa pergunta.

O que é ainda mais surpreendente é que estas falsas memórias implantadas pela IA não são apenas numerosas em número, mas também têm uma “vida útil” particularmente longa. Mesmo depois de uma semana, estas falsas memórias persistiram nas mentes dos voluntários, e a sua confiança nestas falsas memórias era particularmente elevada.

Quem tem maior probabilidade de ser “gotejado”?

Então, quem tem maior probabilidade de receber falsas memórias pela IA? A pesquisa descobriu que aqueles que não estão familiarizados com chatbots, mas estão mais interessados na tecnologia de IA, têm maior probabilidade de “sucumbir”. Isto pode dever-se ao facto de terem um sentimento preconcebido de confiança na IA, reduzindo assim a sua vigilância sobre a autenticidade da informação.

Este estudo soou o alarme para nós: em áreas como direito, medicina e educação que exigem precisão de memória extremamente alta, a aplicação da IA precisa ser mais cautelosa. Ao mesmo tempo, isto também coloca novos desafios para o desenvolvimento futuro da IA: Como podemos garantir que a IA não se torne um “hacker” que implanta memórias falsas, mas se torne um “guardião” que nos ajuda a proteger e melhorar as memórias?

Nesta era de rápido desenvolvimento da tecnologia de IA, as nossas memórias podem ser mais frágeis do que pensamos. Compreender como a IA afeta a nossa memória não é apenas uma tarefa para os cientistas, mas também uma questão à qual cada um de nós precisa prestar atenção. Afinal, a memória é a pedra angular da nossa compreensão do mundo e de nós mesmos. Proteger a nossa memória é proteger o nosso próprio futuro.

Referências:

https://www.media.mit.edu/projects/ai-false-memories/overview/

https://arxiv.org/pdf/2408.04681

Em suma, este estudo do MIT revela os riscos potenciais da IA e lembra-nos que precisamos de tratar a tecnologia de IA com cautela, especialmente em áreas onde a autenticidade da informação é crucial. No futuro, precisamos de prestar mais atenção à ética e à segurança da IA para garantir que a tecnologia da IA possa servir melhor os seres humanos, em vez de se tornar uma ferramenta para manipular a memória. Trabalhemos juntos para tornar a IA um impulso ao progresso humano, em vez de uma ameaça potencial.