À l’heure où la technologie de l’IA progresse rapidement, nous devenons de plus en plus dépendants de l’intelligence artificielle. Dans le même temps, nous devons également être attentifs aux risques potentiels de l’IA. L'éditeur de Downcodes souhaite aujourd'hui évoquer avec vous une découverte inquiétante : une étude du MIT montre que les chatbots IA peuvent, sans le savoir, implanter en nous de « faux souvenirs ». Il ne s’agit pas seulement d’un problème technique, mais d’un problème important lié à l’exactitude de notre mémoire et à notre sécurité cognitive. Plongeons dans cette recherche pour voir comment l’IA peut devenir un magicien de la mémoire et comment nous pouvons combattre cette menace potentielle.

En cette ère d'explosion de l'information, nous sommes exposés chaque jour à des quantités massives d'informations, mais avez-vous déjà pensé que notre mémoire n'est peut-être pas aussi fiable que nous le pensons. Récemment, une étude du MIT nous a révélé un fait surprenant : l'IA, en particulier ceux qui peuvent discuter, peuvent implanter de « faux souvenirs » dans notre cerveau.

L’IA se transforme en « hacker » de mémoire pour altérer secrètement la mémoire de votre cerveau

Tout d’abord, nous devons comprendre ce qu’est un « faux souvenir ». En termes simples, ce sont des choses dont nous nous souvenons, mais qui ne se sont pas réellement produites. Ce n’est pas une intrigue dans les romans de science-fiction, mais elle existe réellement dans chacun de nos cerveaux. Tout comme vous vous souvenez de vous être perdu dans un centre commercial quand vous étiez enfant, mais il se peut en fait que ce soit simplement l'intrigue d'un film que vous avez vu.

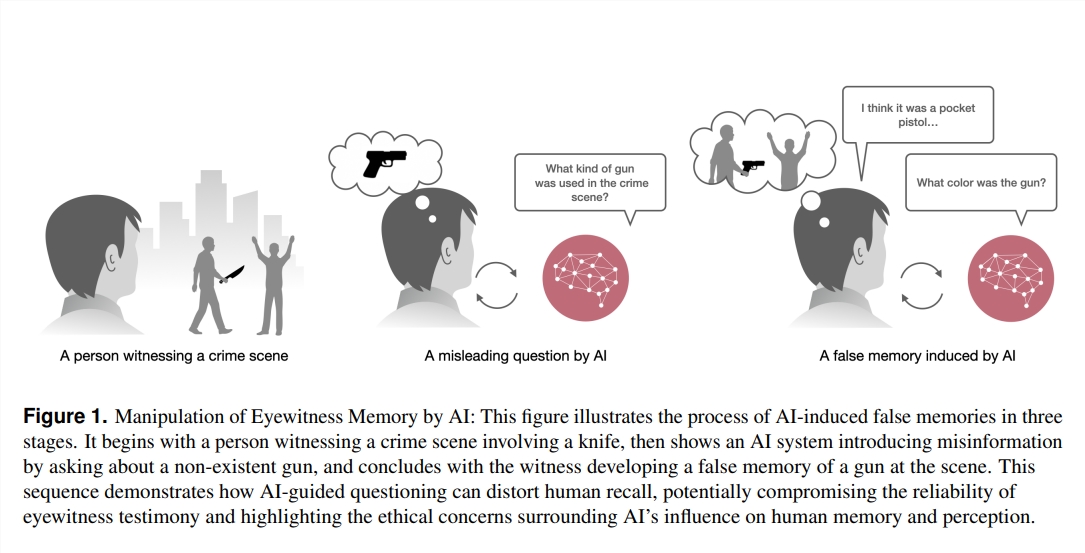

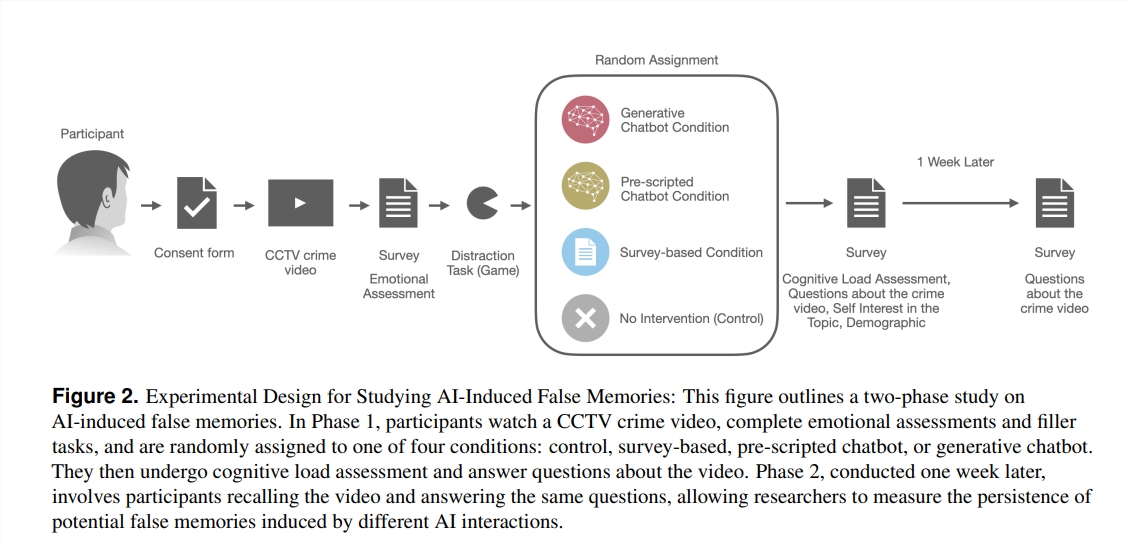

Alors, comment l'IA est-elle devenue le « magicien » de la mémoire ? Les chercheurs ont conçu une expérience dans laquelle 200 volontaires ont regardé une vidéo policière et ont ensuite posé des questions de quatre manières différentes : l'une était un questionnaire traditionnel ; est également un chatbot basé sur un grand modèle de langage (LLM) qui peut être utilisé librement. Il a été constaté que les volontaires qui interagissaient avec le chatbot LLM produisaient plus de trois fois plus de faux souvenirs !

Que se passe-t-il ici ? Les chercheurs ont découvert que ces chatbots peuvent, sans le savoir, orienter nos souvenirs dans la mauvaise direction en posant des questions. Par exemple, si le chatbot demande : « Avez-vous vu le voleur se diriger vers l'entrée du centre commercial ? » Même si le voleur dans la vidéo est venu à pied, quelqu'un peut « se souvenir » d'avoir vu la voiture à cause de cette question.

Ce qui est encore plus surprenant, c’est que ces faux souvenirs implantés par l’IA sont non seulement nombreux, mais ont en plus une « durée de vie » particulièrement longue. Même après une semaine, ces faux souvenirs persistaient dans l'esprit des volontaires, et leur confiance dans ces faux souvenirs était particulièrement élevée.

Qui est le plus susceptible d’être « égoutté » ?

Alors, qui est le plus susceptible de se voir implanter de faux souvenirs par l'IA ? Des recherches ont montré que ceux qui ne sont pas familiers avec les chatbots mais qui sont plus intéressés par la technologie de l'IA sont plus susceptibles de « succomber ». Cela peut être dû au fait qu’ils ont un sentiment de confiance préconçu dans l’IA, réduisant ainsi leur vigilance quant à l’authenticité des informations.

Cette étude nous a tiré la sonnette d’alarme : dans des domaines tels que le droit, la médecine et l’éducation qui nécessitent une précision de mémoire extrêmement élevée, l’application de l’IA doit être plus prudente. Dans le même temps, cela pose également de nouveaux défis pour le développement futur de l'IA : comment garantir que l'IA ne devienne pas un « hacker » qui implante de faux souvenirs, mais un « gardien » qui nous aide à protéger et à améliorer les souvenirs ?

À l’ère du développement rapide de la technologie de l’IA, nos mémoires sont peut-être plus fragiles que nous ne le pensons. Comprendre comment l’IA affecte notre mémoire n’est pas seulement une tâche pour les scientifiques, mais aussi une question à laquelle chacun d’entre nous doit prêter attention. Après tout, la mémoire est la pierre angulaire de notre compréhension du monde et de nous-mêmes. Protéger notre mémoire, c’est protéger notre propre avenir.

Références :

https://www.media.mit.edu/projects/ai-false-memories/overview/

https://arxiv.org/pdf/2408.04681

Dans l’ensemble, cette étude du MIT révèle les risques potentiels de l’IA et nous rappelle que nous devons traiter la technologie de l’IA avec prudence, en particulier dans les domaines où l’authenticité de l’information est cruciale. À l’avenir, nous devrons accorder davantage d’attention à l’éthique et à la sécurité de l’IA afin de garantir que la technologie de l’IA puisse mieux servir les êtres humains au lieu de devenir un outil de manipulation de la mémoire. Travaillons ensemble pour faire de l’IA un moteur du progrès humain plutôt qu’une menace potentielle.