En esta era de rápidos avances en la tecnología de la IA, nos volvemos cada vez más dependientes de la inteligencia artificial. Al mismo tiempo, también debemos estar alerta a los riesgos potenciales de la IA. El editor de Downcodes quiere hablar hoy con usted sobre un descubrimiento inquietante: un estudio del MIT muestra que los chatbots con IA pueden, sin saberlo, implantarnos "recuerdos falsos". Esto no es sólo una cuestión técnica, sino una cuestión importante relacionada con la precisión de nuestra memoria y la seguridad cognitiva. Profundicemos en esta investigación para ver cómo la IA puede convertirse en un mago de la memoria y cómo podemos combatir esta amenaza potencial.

En esta era de explosión de información, estamos expuestos a cantidades masivas de información todos los días, pero ¿alguna vez pensaste que nuestra memoria puede no ser tan confiable como pensamos? Recientemente, un estudio del MIT nos demuestra un hecho sorprendente: la IA. especialmente aquellos que pueden chatear, pueden implantar "recuerdos falsos" en nuestro cerebro.

La IA se convierte en un "hacker" de la memoria para alterar secretamente la memoria de tu cerebro

Primero, tenemos que entender qué es la “falsa memoria”. En pocas palabras, son cosas que recordamos que sucedieron, pero que en realidad no sucedieron. Esta no es una trama de novelas de ciencia ficción, pero en realidad existe en cada uno de nuestros cerebros. Así como recuerdas haberte perdido en un centro comercial cuando eras niño, pero en realidad podría ser solo la trama de una película que viste.

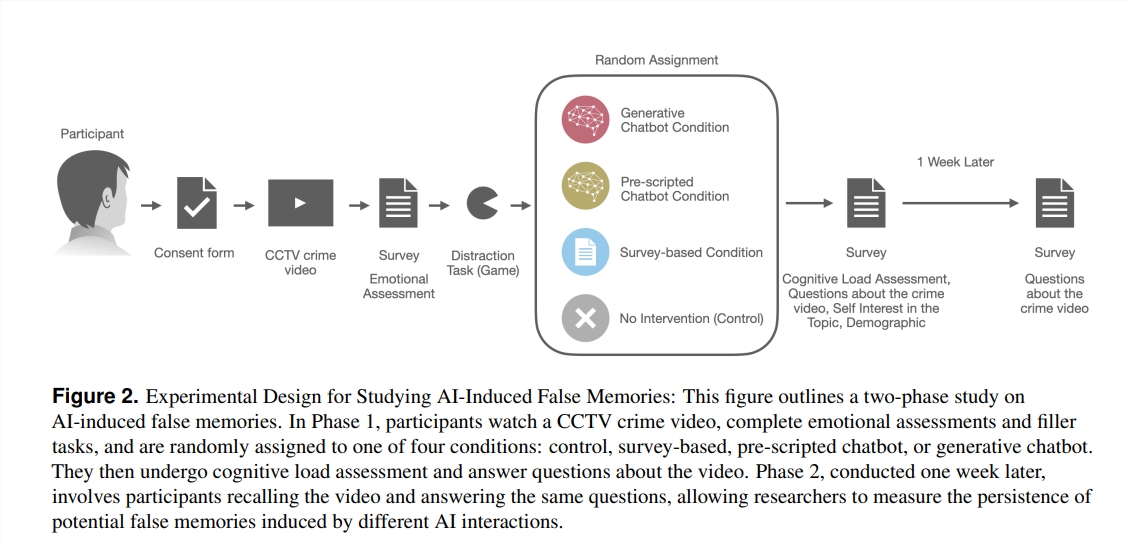

Entonces, ¿cómo llegó a convertirse la IA en el "mago" de la memoria? Los investigadores diseñaron un experimento en el que 200 voluntarios vieron un vídeo de un crimen y luego hicieron preguntas de cuatro formas diferentes: una era un cuestionario tradicional. Hay chatbots con guiones preestablecidos, y allí; También es un chatbot basado en un modelo de lenguaje grande (LLM) que se puede utilizar libremente. ¡Se descubrió que los voluntarios que interactuaron con el chatbot de LLM produjeron más del triple de recuerdos falsos!

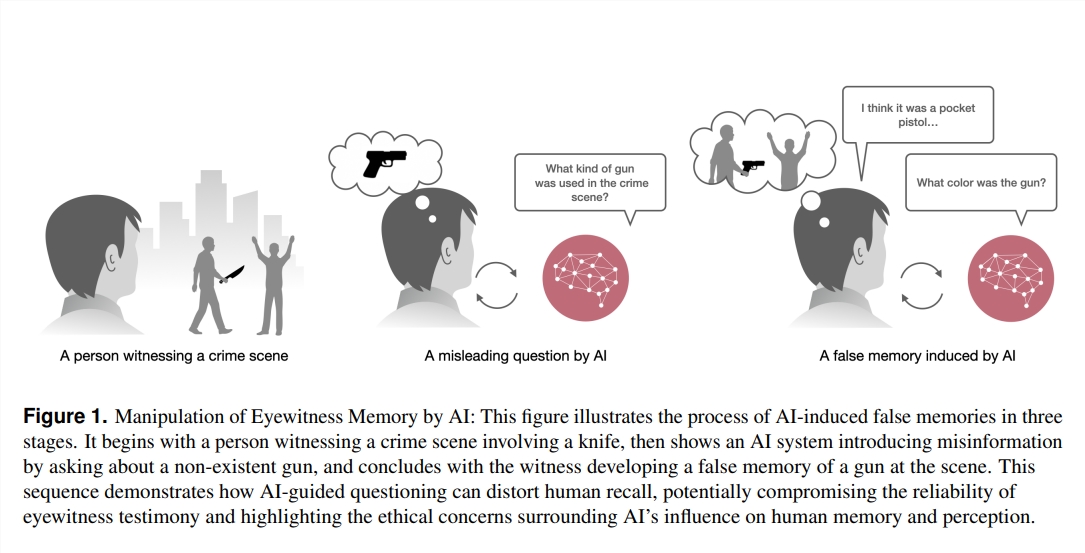

¿Qué está pasando aquí? Los investigadores han descubierto que estos chatbots pueden, sin saberlo, dirigir nuestros recuerdos en la dirección equivocada al hacer preguntas. Por ejemplo, si el chatbot pregunta: "¿Viste al ladrón conduciendo hacia la entrada del centro comercial?" Incluso si el ladrón en el video llegó a pie, alguien puede "recordar" haber visto el auto debido a esta pregunta.

Lo que es aún más sorprendente es que estos recuerdos falsos implantados por la IA no sólo son numerosos, sino que también tienen una "vida útil" particularmente larga. Incluso después de una semana, estos recuerdos falsos persistieron en la mente de los voluntarios, y su confianza en ellos fue particularmente alta.

¿Quién tiene más probabilidades de ser “goteado”?

Entonces, ¿a quién es más probable que la IA le implante recuerdos falsos? Las investigaciones han descubierto que aquellos que no están familiarizados con los chatbots pero están más interesados en la tecnología de IA tienen más probabilidades de "sucumbir". Esto puede deberse a que tienen un sentido preconcebido de confianza en la IA, lo que reduce su vigilancia sobre la autenticidad de la información.

Este estudio nos ha hecho sonar la alarma: en campos como el derecho, la medicina y la educación que requieren una precisión de memoria extremadamente alta, la aplicación de la IA debe ser más cautelosa. Al mismo tiempo, esto también plantea nuevos desafíos para el desarrollo futuro de la IA: ¿Cómo podemos garantizar que la IA no se convierta en un "hacker" que implanta recuerdos falsos, sino en un "guardián" que nos ayude a proteger y mejorar los recuerdos?

En esta era de rápido desarrollo de la tecnología de inteligencia artificial, nuestros recuerdos pueden ser más frágiles de lo que pensamos. Comprender cómo la IA afecta nuestra memoria no es sólo una tarea de los científicos, sino también una cuestión a la que todos debemos prestar atención. Después de todo, la memoria es la piedra angular de nuestra comprensión del mundo y de nosotros mismos. Proteger nuestra memoria es proteger nuestro propio futuro.

Referencias:

https://www.media.mit.edu/projects/ai-false-memories/overview/

https://arxiv.org/pdf/2408.04681

En definitiva, este estudio del MIT revela los riesgos potenciales de la IA y nos recuerda que debemos tratar la tecnología de IA con precaución, especialmente en áreas donde la autenticidad de la información es crucial. En el futuro, debemos prestar más atención a la ética y la seguridad de la IA para garantizar que la tecnología de IA pueda servir mejor a los seres humanos en lugar de convertirse en una herramienta para manipular la memoria. Trabajemos juntos para hacer de la IA un impulso al progreso humano en lugar de una amenaza potencial.