A equipe de pesquisa da Universidade de Tsinghua lançou a plataforma de simulação de fonte sonora móvel SonicSim e o conjunto de dados SonicSet, com o objetivo de resolver o problema de dados insuficientes em cenários de fonte sonora móvel na área de processamento de fala. O editor de Downcodes levará você a entender os resultados desta pesquisa inovadora, como ela simula o ambiente acústico real e como fornece suporte de dados de alta qualidade para o treinamento de modelos de separação e aprimoramento de fala.

Uma equipe de pesquisa da Universidade de Tsinghua lançou recentemente uma plataforma de simulação de fonte sonora móvel chamada SonicSim, que visa resolver o problema atual de falta de dados na área de processamento de fala em cenários de fonte sonora móvel.

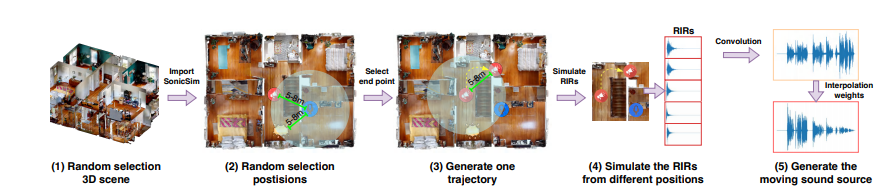

Esta plataforma é construída na plataforma de simulação Habitat-sim, que pode simular o ambiente acústico do mundo real com alta fidelidade e fornecer melhor suporte de dados para o treinamento e avaliação de modelos de separação e aprimoramento de fala.

A maioria dos conjuntos de dados de separação e aprimoramento de fala existentes são baseados em fontes de som estáticas, que são difíceis de atender às necessidades de cenários de fontes de som móveis.

Embora alguns conjuntos de dados registados também existam no mundo real, a sua escala é limitada e os seus custos de recolha são elevados. Em contraste, embora os conjuntos de dados sintéticos sejam de maior escala, as suas simulações acústicas muitas vezes não são suficientemente realistas para refletir com precisão as características acústicas em ambientes reais.

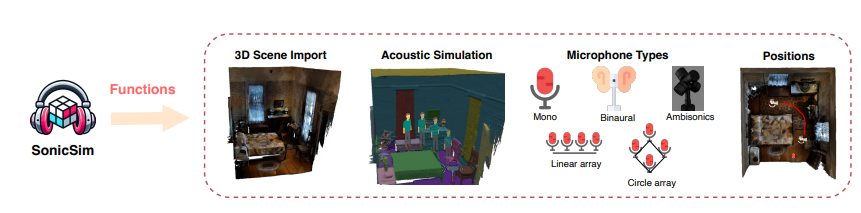

O surgimento da plataforma SonicSim resolve efetivamente os problemas acima. A plataforma pode simular uma variedade de ambientes acústicos complexos, incluindo obstruções, geometria da sala e características de absorção, reflexão e dispersão de som de diferentes materiais, e suporta layout de cena definido pelo usuário, fonte de som e posições de microfone, tipos de microfone, etc. .

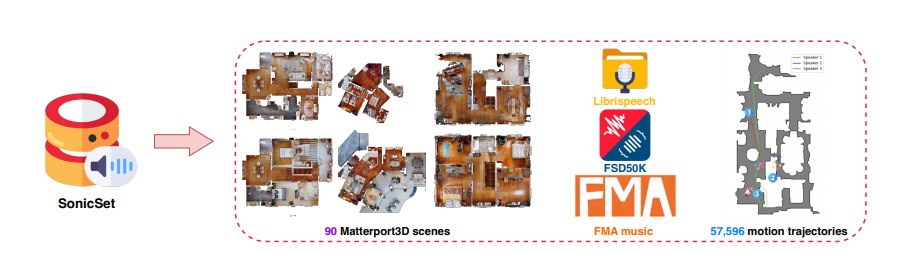

Com base na plataforma SonicSim, a equipe de pesquisa também construiu um conjunto de dados de fontes sonoras móveis multicenas em grande escala chamado SonicSet.

Este conjunto de dados usa dados de fala e ruído do LibriSpeech, Freesound Dataset50k e Free Music Archive, bem como 90 cenas reais do conjunto de dados Matterport3D, que contém dados ricos de fala, ruído ambiental e ruído musical.

O processo de construção do conjunto de dados SonicSet é altamente automatizado e pode gerar aleatoriamente as posições das fontes sonoras e microfones, bem como as trajetórias de movimento das fontes sonoras, garantindo a autenticidade e diversidade dos dados.

Para verificar a eficácia da plataforma SonicSim e do conjunto de dados SonicSet, a equipe de pesquisa conduziu um grande número de experimentos em tarefas de separação e aprimoramento de fala.

Os resultados mostram que o modelo treinado no conjunto de dados SonicSet obteve melhor desempenho no conjunto de dados gravados do mundo real, provando que a plataforma SonicSim pode simular efetivamente o ambiente acústico do mundo real e fornecer uma base poderosa para pesquisas na área de fala. suporte de processamento.

O lançamento da plataforma SonicSim e do conjunto de dados SonicSet trouxe novos avanços para a pesquisa na área de processamento de fala. Com a melhoria contínua das ferramentas de simulação e otimização dos algoritmos do modelo, a aplicação da tecnologia de processamento de voz em ambientes complexos será promovida ainda mais no futuro.

No entanto, o realismo da plataforma SonicSim ainda é limitado pelos detalhes da modelagem de cenas 3D. Quando a cena 3D importada apresenta estruturas ausentes ou incompletas, a plataforma não consegue simular com precisão o efeito de reverberação no ambiente atual.

Endereço do artigo: https://arxiv.org/pdf/2410.01481

O surgimento do SonicSim e do SonicSet trouxe uma nova esperança para o desenvolvimento da tecnologia de processamento de voz, mas ainda precisa ser continuamente melhorada. Espere ver aplicações desta tecnologia em ambientes acústicos mais complexos no futuro. O editor do Downcodes continuará atento ao progresso da pesquisa nesta área.