Das Forschungsteam der Tsinghua-Universität startete die Simulationsplattform für mobile Schallquellen SonicSim und den SonicSet-Datensatz mit dem Ziel, das Problem unzureichender Daten in Szenarios mit mobilen Schallquellen im Bereich der Sprachverarbeitung zu lösen. Der Herausgeber von Downcodes wird Ihnen die Ergebnisse dieser bahnbrechenden Forschung näher bringen, wie sie die reale akustische Umgebung simuliert und wie sie hochwertige Datenunterstützung für das Training von Sprachtrennungs- und -verbesserungsmodellen bietet.

Ein Forschungsteam der Tsinghua-Universität hat kürzlich eine Simulationsplattform für mobile Schallquellen namens SonicSim veröffentlicht, die darauf abzielt, das aktuelle Problem des Datenmangels im Bereich der Sprachverarbeitung in Szenarien mit mobilen Schallquellen zu lösen.

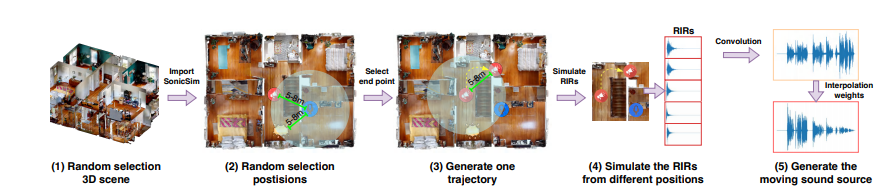

Diese Plattform basiert auf der Simulationsplattform Habitat-sim, die die reale akustische Umgebung mit hoher Wiedergabetreue simulieren und eine bessere Datenunterstützung für das Training und die Bewertung von Sprachtrennungs- und -verbesserungsmodellen bieten kann.

Die meisten vorhandenen Datensätze zur Sprachtrennung und -verbesserung basieren auf statischen Schallquellen, die den Anforderungen von Szenarien mit sich bewegenden Schallquellen nur schwer gerecht werden können.

Obwohl einige real aufgezeichnete Datensätze auch in der realen Welt existieren, ist ihr Umfang begrenzt und ihre Erhebungskosten sind hoch. Im Gegensatz dazu sind synthetische Datensätze zwar größer, ihre akustischen Simulationen sind jedoch häufig nicht realistisch genug, um die akustischen Eigenschaften in realen Umgebungen genau wiederzugeben.

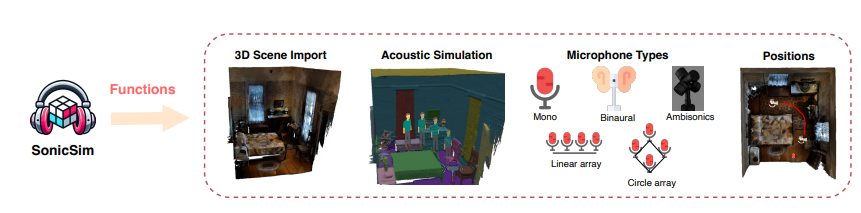

Das Aufkommen der SonicSim-Plattform löst die oben genannten Probleme effektiv. Die Plattform kann eine Vielzahl komplexer akustischer Umgebungen simulieren, darunter Hindernisse, Raumgeometrie sowie Schallabsorptions-, Reflexions- und Streueigenschaften verschiedener Materialien, und unterstützt benutzerdefinierte Szenenlayouts, Schallquellen- und Mikrofonpositionen, Mikrofontypen usw. Parameter .

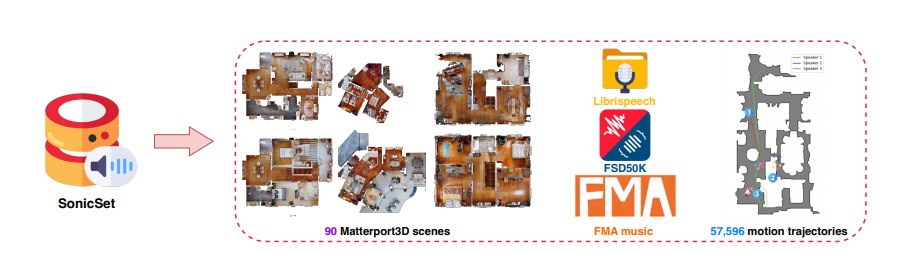

Basierend auf der SonicSim-Plattform erstellte das Forschungsteam außerdem einen groß angelegten Datensatz mit mobilen Klangquellen für mehrere Szenen namens SonicSet.

Dieser Datensatz verwendet Sprach- und Geräuschdaten von LibriSpeech, Freesound Dataset50k und Free Music Archive sowie 90 reale Szenen aus dem Matterport3D-Datensatz, der umfangreiche Sprach-, Umgebungsgeräusch- und Musikgeräuschdaten enthält.

Der Konstruktionsprozess des SonicSet-Datensatzes ist hochgradig automatisiert und kann die Positionen von Schallquellen und Mikrofonen sowie die Bewegungsbahnen der Schallquellen zufällig generieren und so die Authentizität und Vielfalt der Daten gewährleisten.

Um die Wirksamkeit der SonicSim-Plattform und des SonicSet-Datensatzes zu überprüfen, führte das Forschungsteam zahlreiche Experimente zu Sprachtrennungs- und Sprachverbesserungsaufgaben durch.

Die Ergebnisse zeigen, dass das auf dem SonicSet-Datensatz trainierte Modell eine bessere Leistung auf dem realen aufgezeichneten Datensatz erzielte, was beweist, dass die SonicSim-Plattform die reale akustische Umgebung effektiv simulieren und eine leistungsstarke Grundlage für die Forschung im Bereich Sprache bieten kann Verarbeitung.

Die Veröffentlichung der SonicSim-Plattform und des SonicSet-Datensatzes hat der Forschung auf dem Gebiet der Sprachverarbeitung neue Durchbrüche beschert. Mit der kontinuierlichen Verbesserung von Simulationswerkzeugen und der Optimierung von Modellalgorithmen wird der Einsatz von Sprachverarbeitungstechnologie in komplexen Umgebungen künftig weiter vorangetrieben.

Der Realismus der SonicSim-Plattform wird jedoch immer noch durch die Details der 3D-Szenenmodellierung eingeschränkt. Wenn in der importierten 3D-Szene Strukturen fehlen oder unvollständig sind, kann die Plattform den Nachhalleffekt in der aktuellen Umgebung nicht genau simulieren.

Papieradresse: https://arxiv.org/pdf/2410.01481

Das Aufkommen von SonicSim und SonicSet hat der Entwicklung der Sprachverarbeitungstechnologie neue Hoffnung gegeben, sie muss jedoch weiterhin kontinuierlich verbessert werden. Erwarten Sie, dass diese Technologie in Zukunft auch in komplexeren akustischen Umgebungen Anwendung finden wird. Der Herausgeber von Downcodes wird den Forschungsfortschritt auf diesem Gebiet weiterhin aufmerksam verfolgen.