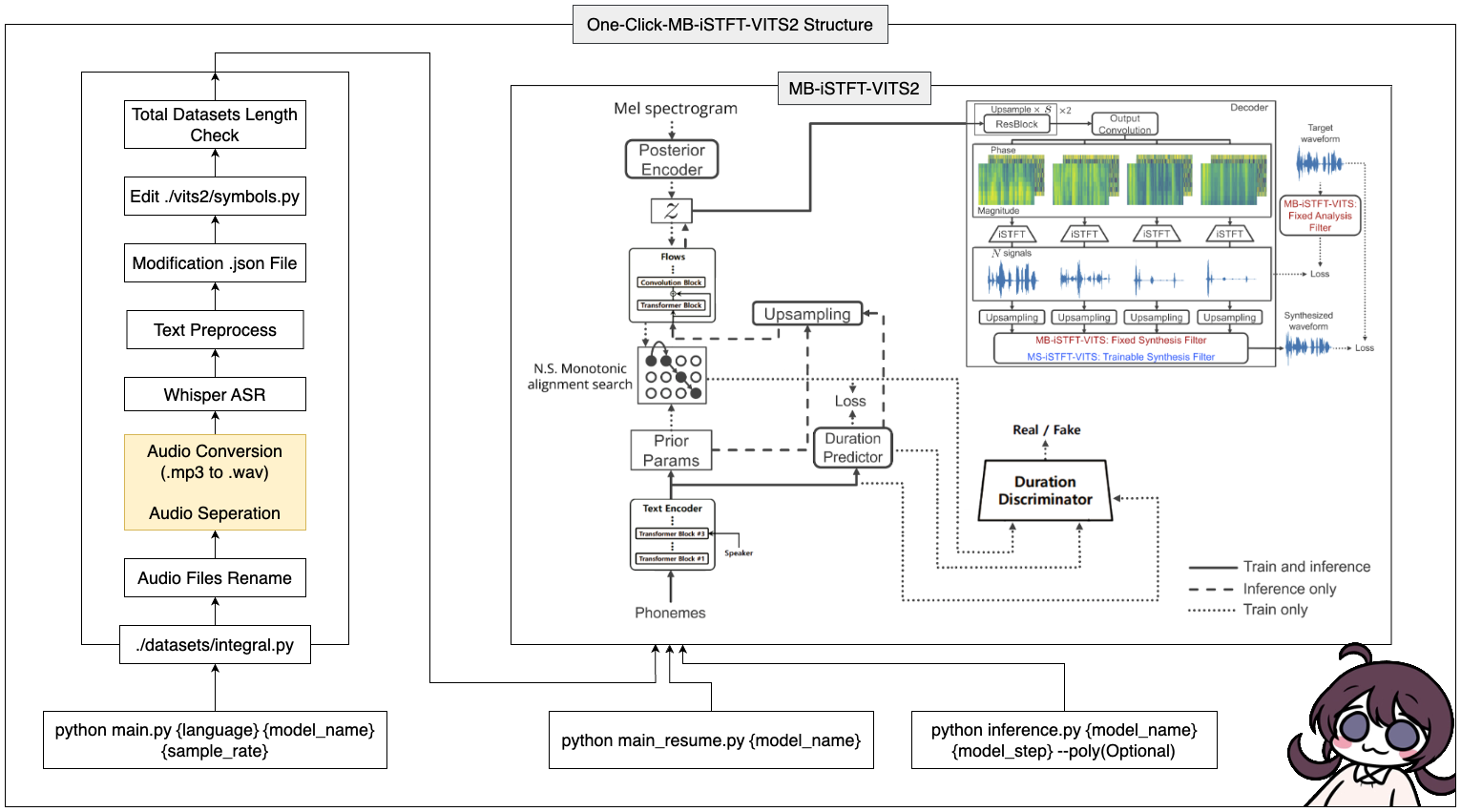

Esta ferramenta permite que você conclua todo o processo de MB-ISTFT-VITS2 (Pré-processamento de dados + Whisper ASR + Texto Pré-Processamento + Modificação Config.json + Treinamento, Inferência) Com um clique!

16GB .12GB de VRAM.Comando de instalação pytorch:

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu117 CUDA 11.7 Instale: https://developer.nvidia.com/cuda-11-7-0-download-archive

ZLIB DLL Instalação: https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html#install-zlib-windows

Instale o pyopenjtalk manualmente: pip install -U pyopenjtalk --no-build-isolation

conda create -n vits2 python=3.8conda activate vits2git clone https://github.com/ORI-Muchim/One-Click-MB-iSTFT-VITS2.git cd One-Click-MB-iSTFT-VITS2pip install -r requirements.txtColoque os arquivos de áudio da seguinte forma.

Os arquivos .mp3 ou .wav estão bem.

One-Click-MB-iSTFT-VITS2

├────datasets

│ ├───speaker0

│ │ ├────1.mp3

│ │ └────1.wav

│ └───speaker1

│ │ ├───1.mp3

│ │ └───1.wav

│ ├integral.py

│ └integral_low.py

│

├────vits2

├────inference.py

├────main_low.py

├────main_resume.py

├────main.py

├────Readme.md

└────requirements.txt

Este é apenas um exemplo, e não há problema em adicionar mais alto -falantes.

Para iniciar esta ferramenta, use o seguinte comando, substituindo {idioma}, {model_name} e {sample_rate} com seus respectivos valores ({idioma: ko, ja, en, zh} / {sample_rate: 22050 /44100}):

python main.py {language} {model_name} {sample_rate}Para aqueles com baixas especificações (vram <= 16 GB), use este código:

python main_low.py {language} {model_name} {sample_rate}Se a configuração de dados estiver concluída e você quiser retomar o treinamento, insira este código:

python main_resume.py {model_name}Depois que o modelo foi treinado, você pode gerar previsões usando o seguinte comando, substituindo {Model_name} e {Model_Step} pelos seus respectivos valores:

python inference.py {model_name} {model_step} --poly(Optional) Se você selecionou CJKE_CLEANERS2 (EN, ZH), coloque --poly Opção na parte traseira.

Se você deseja alterar o exemplo de texto usado na referência, modifique ./vits/inference.py Parte input .

No repositório de Cjangcjengh/Vits, fiz algumas modificações no método de limpeza de texto coreano. O outro processo de limpeza é o mesmo, publicando -o no repositório Cjangcjengh, mas o arquivo mais limpo foi modificado usando a biblioteca Tenebo/G2PK2 como o coreano pronunciado.

Para mais informações, consulte os seguintes repositórios: