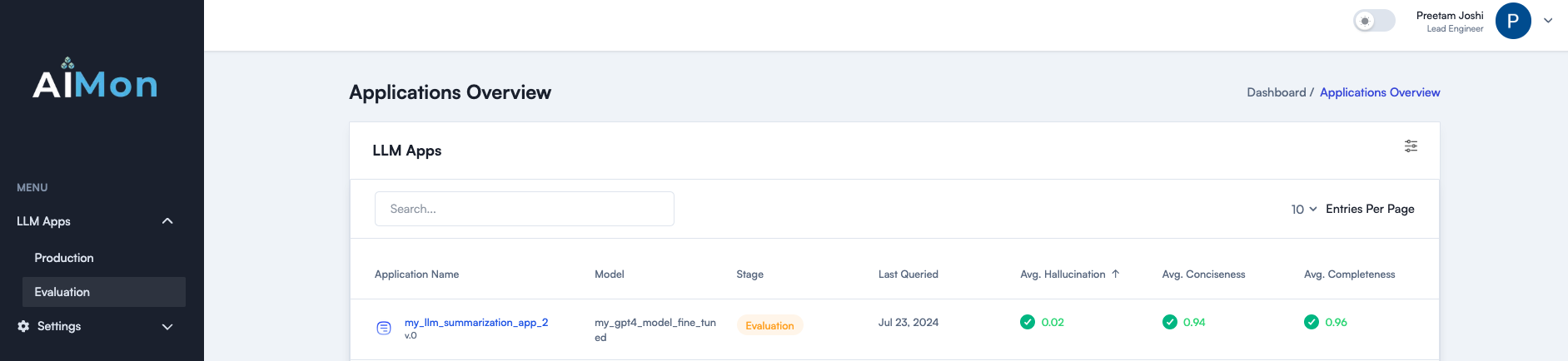

A Aimon ajuda os desenvolvedores a criar, a enviar e monitorar aplicativos LLM com mais confiança e confiabilidade com seu sistema de vários modelos de ponta para detectar problemas de qualidade LLM. Ajuda perfeitamente com avaliações offline e monitoramento contínuo de produção. A Aimon oferece detecção de alucinação rápida, confiável e econômica. Também suporta outras métricas importantes de qualidade, como integridade, concisão e toxicidade. Leia nossa postagem no blog para obter mais detalhes.

Junte -se à nossa comunidade no Slack

A seguir, é apresentada uma lista de métricas de qualidade atualmente disponíveis e em nosso roteiro. Entre em contato para expressar seu interesse em qualquer um desses.

| Métrica | Status |

|---|---|

| Modelo Hallucination (nível de passagem e frase) | ✓ |

| Integridade | ✓ |

| Concisão | ✓ |

| Toxicidade | ✓ |

| Aderência de instrução | ✓ |

A Aimon suporta instrumentação assíncrona ou detecções síncronas para as métricas mencionadas acima. Use essas etapas para começar o uso do Aimon SDK e do produto.

pip install aimon no seu terminal. from aimon import Detect

detect = Detect ( values_returned = [ 'context' , 'generated_text' ], config = { "hallucination" : { "detector_name" : "default" }})

@ detect

def my_llm_app ( context , query ):

# my_llm_model is the function that generates text using the LLM model

generated_text = my_llm_model ( context , query )

return context , generated_textanalyze_prod .

Para demonstrar a eficácia do nosso sistema, comparamos -o a benchmarks populares da indústria para a tarefa de detecção de alucinação. A tabela abaixo mostra nossos resultados.

Algumas takeaways importantes:

✅ Aimon é 10x mais barato que o GPT-4 Turbo.

✅ Aimon é 4x mais rápido que o GPT-4 Turbo.

✅ Aimon fornece a conveniência de uma API totalmente hospedada que inclui a explicação assada.

✅ Apoio a uma duração de contexto de até 32.000 tokens (com planos de expandir ainda mais isso em um futuro próximo).

No geral, a Aimon é 10 vezes mais barata, 4 vezes mais rápida e próxima ou até melhor que o GPT-4 nos benchmarks, tornando-o uma escolha adequada para a detecção offline e on-line de alucinações.

| Métrica | Aimon confia v1 | GPT-4 Turbo (LLM-AS-A-JUDGE) |

|---|---|---|

| Comprimento do contexto | 32.000 | 128.000 |

| True DataSet Precision/Recall | 0,808 / 0,922 | 0,810 / 0,926 |

| Summac (teste) Precisão equilibrada | 0,778 | 0,756 |

| Summac (teste) AUC | 0,809 | 0,780 |

| Teste de classificação de qualquer escala para precisão de alucinações | 0,665 | 0,741 |

| Teste de classificação de qualquer escala para alucinações rel. Precisão | 0,804 | 0,855 |

| Avg. Latência | 417ms | 1800ms |

| Custo (15 milhões de tokens em todos os conjuntos de dados de referência) excluindo o nível gratuito | $ 15 | $ 158 |

| Totalmente hospedado | ✅ | ✅ |

| Explicação | Pontuações automáticas no nível da sentença | Raciocínio detalhado com engenharia rápida adicional |

Faltam conjuntos de dados de referência padrão do setor para essas métricas. Em breve, publicaremos um conjunto de dados de avaliação. Fique atento! ⌛

Consulte o site Aponton.ai para obter detalhes.

Junte -se à nossa comunidade Slack para obter as últimas atualizações e discussões sobre a confiabilidade generativa da IA.