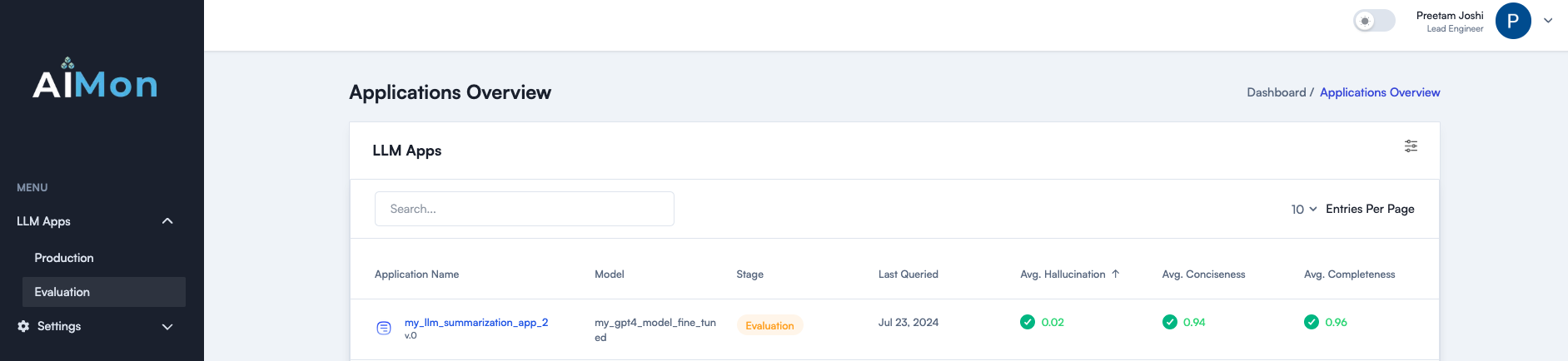

AIMON은 LLM 품질 문제를 감지하기위한 최첨단 멀티 모델 시스템을 통해 개발자가 LLM 앱을보다 자신있게 그리고 안정적으로 구축, 선적 및 모니터링하도록 도와줍니다. 오프라인 평가와 지속적인 생산 모니터링을 모두 원활하게 도와줍니다. Aimon은 빠르고 신뢰할 수 있으며 비용 효율적인 환각 탐지를 제공합니다. 또한 완전성, 간결함 및 독성과 같은 다른 중요한 품질 메트릭을 지원합니다. 자세한 내용은 블로그 게시물을 읽으십시오.

슬랙에서 우리 커뮤니티에 가입하십시오

다음은 현재 사용할 수있는 품질 메트릭 목록과 로드맵에 있습니다. 이들에 대한 관심을 표현하려면 연락하십시오.

| 메트릭 | 상태 |

|---|---|

| 모델 환각 (구절 및 문장 수준) | ✓ |

| 완전성 | ✓ |

| 간결 | ✓ |

| 독성 | ✓ |

| 지시 준수 | ✓ |

AIMON은 위에서 언급 한 메트릭에 대한 비동기 계측 또는 동기 탐지를 지원합니다. 이 단계를 사용하여 Aimon SDK 및 제품을 사용하여 시작하십시오.

pip install aimon 하여 AIMON SDK를 설치하십시오. from aimon import Detect

detect = Detect ( values_returned = [ 'context' , 'generated_text' ], config = { "hallucination" : { "detector_name" : "default" }})

@ detect

def my_llm_app ( context , query ):

# my_llm_model is the function that generates text using the LLM model

generated_text = my_llm_model ( context , query )

return context , generated_textanalyze_prod Decorator를 참조하십시오.

우리는 시스템의 효과를 입증하기 위해 환각 탐지 작업을위한 인기있는 업계 벤치 마크에 대해 벤치마킹했습니다. 아래 표는 결과를 보여줍니다.

몇 가지 주요 테이크 아웃 :

AIMON은 GPT-4 터보보다 10 배 저렴합니다 .

Aimon은 GPT-4 터보보다 4 배 빠릅니다 .

AIMON은 구운 설명이 포함 된 완전히 호스팅 된 API의 편의를 제공합니다.

✅ 최대 32,000 개의 컨텍스트 길이에 대한 지원 (가까운 시일 내에이를 더 확장 할 계획).

전반적으로 Aimon은 벤치 마크에서 GPT-4보다 10 배 저렴하고 4 배 더 빠르며 더 가깝거나 더 우수 합니다. 오프라인 및 온라인 환각 탐지 모두에 적합한 선택입니다.

| 메트릭 | Aimon Rely V1 | GPT-4 터보 (LLM-as-a-Judge) |

|---|---|---|

| 컨텍스트 길이 | 32,000 | 128,000 |

| 진정한 데이터 세트 정밀/리콜 | 0.808 / 0.922 | 0.810 / 0.926 |

| Summac (테스트) 균형 정확도 | 0.778 | 0.756 |

| Summac (테스트) AUC | 0.809 | 0.780 |

| 환각 정확도에 대한 모든 규모의 순위 테스트 | 0.665 | 0.741 |

| 환각에 대한 모든 규모의 순위 테스트 rel. 정확성 | 0.804 | 0.855 |

| avg. 숨어 있음 | 417ms | 1800ms |

| 무료 계층을 제외한 비용 (모든 벤치 마크 데이터 세트에서 15m) | $ 15 | $ 158 |

| 완전히 호스팅되었습니다 | ✅ | ✅ |

| 설명 가능성 | 자동 문장 수준 점수 | 추가적인 신속한 엔지니어링을 통한 상세한 추론 |

이러한 메트릭에 대한 업계 표준 벤치 마크 데이터 세트가 부족합니다. 우리는 곧 평가 데이터 세트를 게시 할 예정입니다. 계속 지켜봐! ⌛

자세한 내용은 웹 사이트 AIMON.AI를 참조하십시오.

생성 AI 신뢰성에 대한 최신 업데이트 및 토론을 위해 슬랙 커뮤니티에 가입하십시오.