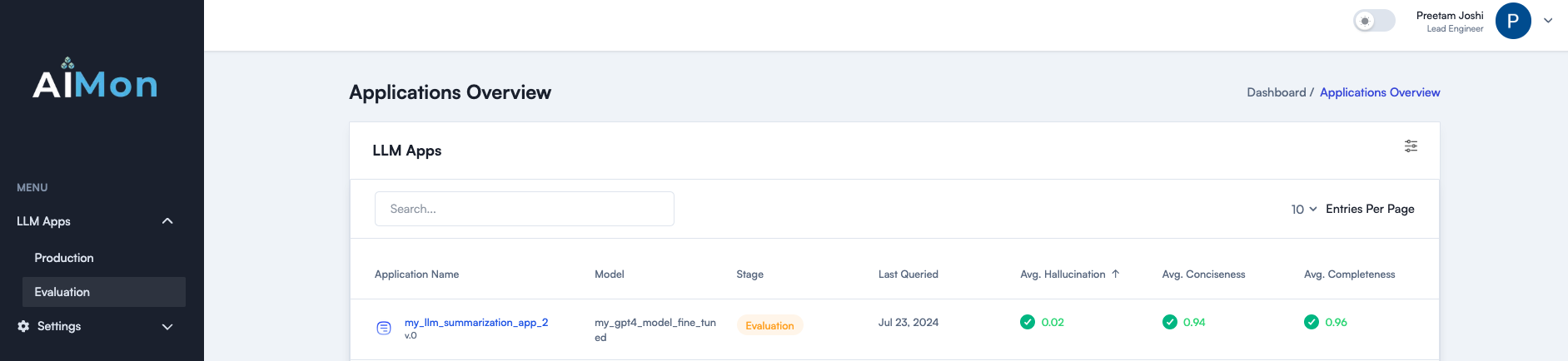

Aimon aide les développeurs à construire, expédier et surveiller les applications LLM plus en toute confiance et de manière fiable avec son système multi-modélisation à la pointe de la technologie pour détecter les problèmes de qualité LLM. Il aide parfaitement à des évaluations hors ligne et à une surveillance continue de la production. Aimon offre une détection d'hallucination rapide, fiable et rentable. Il soutient également d'autres mesures de qualité importantes telles que l'exhaustivité, la concision et la toxicité. Lisez notre article de blog pour plus de détails.

Rejoignez notre communauté sur Slack

Ce qui suit est une liste de mesures de qualité actuellement disponibles et sur notre feuille de route. Veuillez contacter votre intérêt pour l'un d'eux.

| Métrique | Statut |

|---|---|

| Hallucination modèle (passage et niveau de phrase) | ✓ |

| Complétude | ✓ |

| Concision | ✓ |

| Toxicité | ✓ |

| Adhésion à l'instruction | ✓ |

Aimon prend en charge l'instrumentation asynchrone ou les détections synchrones pour les métriques mentionnées ci-dessus. Utilisez ces étapes pour commencer à utiliser le SDK AIMON et le produit.

pip install aimon dans votre terminal. from aimon import Detect

detect = Detect ( values_returned = [ 'context' , 'generated_text' ], config = { "hallucination" : { "detector_name" : "default" }})

@ detect

def my_llm_app ( context , query ):

# my_llm_model is the function that generates text using the LLM model

generated_text = my_llm_model ( context , query )

return context , generated_textanalyze_prod Decorator.

Pour démontrer l'efficacité de notre système, nous l'avons comparé contre les repères populaires de l'industrie pour la tâche de détection d'hallucination. Le tableau ci-dessous montre nos résultats.

Quelques plats clés:

✅ Aimon est 10x moins cher que GPT-4 Turbo.

✅ AIMON est 4x plus rapide que GPT-4 Turbo.

✅ Aimon fournit la commodité d'une API entièrement hébergée qui inclut l'explication de la cuisson.

✅ Prise en charge d'une durée de contexte allant jusqu'à 32 000 jetons (avec des plans pour développer davantage cela dans un avenir proche).

Dans l'ensemble, Aimon est 10 fois moins cher, 4 fois plus rapide et proche ou même mieux que GPT-4 sur les repères, ce qui en fait un choix approprié pour la détection hors ligne et en ligne des hallucinations.

| Métrique | Aimon reposait V1 | GPT-4 Turbo (LLM-AS-A-JUDUS) |

|---|---|---|

| Durée du contexte | 32 000 | 128 000 |

| True précision / rappel de l'ensemble de données | 0,808 / 0,922 | 0,810 / 0,926 |

| Summer (test) Précision équilibrée | 0,778 | 0,756 |

| Résumé (test) AUC | 0,809 | 0,780 |

| Test de classement de toute l'échelle pour la précision des hallucinations | 0,665 | 0,741 |

| Test de classement de toute échelle pour les hallucinations Rel. Précision | 0,804 | 0,855 |

| Avg. Latence | 417 ms | 1800 ms |

| Coût (jetons de 15 millions de personnes sur tous les ensembles de données de référence) à l'exclusion du niveau gratuit | 15 $ | 158 $ |

| Entièrement hébergé | ✅ | ✅ |

| Explicabilité | Scores automatiques au niveau de la phrase | Raisonnement détaillé avec une ingénierie rapide supplémentaire |

Il y a un manque d'ensembles de données de référence standard pour ces mesures. Nous publierons bientôt un ensemble de données d'évaluation. Restez à l'écoute! ⌛

Reportez-vous au site Web Aimon.ai pour plus de détails.

Rejoignez notre communauté Slack pour les dernières mises à jour et discussions sur la fiabilité générative de l'IA.