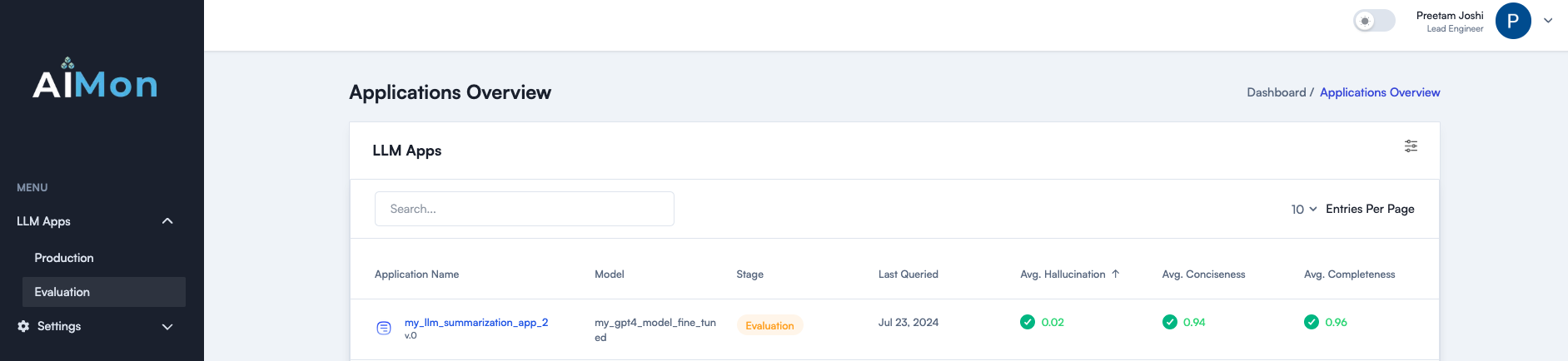

Aimonは、開発者がLLMの品質問題を検出するための最先端のマルチモデルシステムをより自信を持って確実に構築、出荷、監視するのを支援します。オフライン評価と継続的な生産監視の両方でシームレスに役立ちます。 Aimonは、高速で信頼性が高く、費用対効果の高い幻覚検出を提供します。また、完全性、簡潔さ、毒性など、他の重要な品質メトリックもサポートしています。詳細については、ブログ投稿をご覧ください。

Slackでコミュニティに参加してください

以下は、現在利用可能な品質メトリックのリストとロードマップでのリストです。これらのいずれかにあなたの関心を表明するために手を差し伸べてください。

| メトリック | 状態 |

|---|---|

| モデルの幻覚(通過と文のレベル) | ✓✓ |

| 完全 | ✓✓ |

| 簡潔 | ✓✓ |

| 毒性 | ✓✓ |

| 指導の順守 | ✓✓ |

Aimonは、上記のメトリックの非同期計装または同期検出をサポートしています。これらの手順を使用して、Aimon SDKと製品の使用を開始します。

pip install aimon 。 from aimon import Detect

detect = Detect ( values_returned = [ 'context' , 'generated_text' ], config = { "hallucination" : { "detector_name" : "default" }})

@ detect

def my_llm_app ( context , query ):

# my_llm_model is the function that generates text using the LLM model

generated_text = my_llm_model ( context , query )

return context , generated_textanalyze_prod Decoratorを参照してください。

当社のシステムの有効性を実証するために、幻覚検出タスクのための一般的な業界のベンチマークに対してそれをベンチマークしました。以下の表は、結果を示しています。

いくつかの重要なポイント:

AimonはGPT-4ターボよりも10倍安いです。

AimonはGPT-4ターボよりも4倍高速です。

Aimonは、Baked-Inの説明可能性を含む、完全にホストされたAPIの利便性を提供します。

context最大32,000トークンのコンテキスト長のサポート(近い将来にこれをさらに拡大する計画を備えています)。

全体として、Aimonはベンチマーク上のGPT-4よりも10倍安く、4倍高速で、またはさらに優れているため、オフラインとオンラインの両方の幻覚を検出するのに適しています。

| メトリック | AimonはV1に頼っています | GPT-4ターボ(LLM-As-A-Judge) |

|---|---|---|

| コンテキスト長 | 32,000 | 128,000 |

| 真のデータセット精度/リコール | 0.808 / 0.922 | 0.810 / 0.926 |

| summac(テスト)バランスの取れた精度 | 0.778 | 0.756 |

| summac(テスト)auc | 0.809 | 0.780 |

| 幻覚の精度のためのあらゆるスケールランキングテスト | 0.665 | 0.741 |

| 幻覚の任意のスケールランキングテストRel。正確さ | 0.804 | 0.855 |

| 平均。遅延 | 417ms | 1800ms |

| 無料層を除くコスト(すべてのベンチマークデータセットにわたって15mトークン) | 15ドル | 158ドル |

| 完全にホストされています | ✅ | ✅ |

| 説明可能性 | 自動文レベルのスコア | 追加の迅速なエンジニアリングを備えた詳細な推論 |

これらのメトリックには、業界標準のベンチマークデータセットが不足しています。まもなく評価データセットを公開します。乞うご期待! ⌛

詳細については、Webサイトaimon.aiを参照してください。

Slackコミュニティに参加して、生成的AIの信頼性に関する最新の更新とディスカッションを行います。