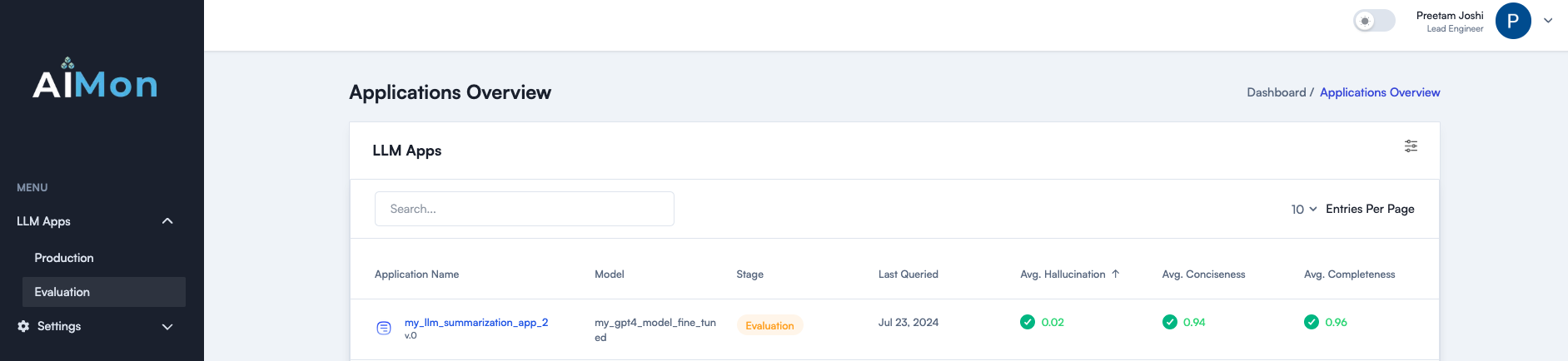

AIMON hilft Entwicklern, LLM-Apps mit seinem hochmodernen Multi-Model-System zur Erkennung von LLM-Qualitätsproblemen sicherer und zuverlässig besser und zuverlässig aufzubauen, zu versenden und zu überwachen. Es hilft nahtlos sowohl bei Offline -Bewertungen als auch bei der kontinuierlichen Produktionsüberwachung. Aimon bietet eine schnelle, zuverlässige und kostengünstige Halluzinationserkennung. Es unterstützt auch andere wichtige Qualitätsmetriken wie Vollständigkeit, Selbstverständlichkeit und Toxizität. Lesen Sie unseren Blog -Beitrag für weitere Details.

Schließen Sie sich unserer Community auf Slack bei

Im Folgenden finden Sie eine Liste der derzeit verfügbaren Qualitätsmetriken und auf unserer Roadmap. Bitte wenden Sie sich an Ihr Interesse an diesen.

| Metrisch | Status |

|---|---|

| Modell Halluzination (Passage und Satzebene) | ✓ |

| Vollständigkeit | ✓ |

| Prägnanz | ✓ |

| Toxizität | ✓ |

| Anweisungseinhaltung | ✓ |

Aimon unterstützt asynchrone Instrumente oder synchrone Erkennungen für die oben genannten Metriken. Verwenden Sie diese Schritte, um mit dem Aimon SDK und dem Produkt zu beginnen.

pip install aimon in Ihrem Terminal ausführen. from aimon import Detect

detect = Detect ( values_returned = [ 'context' , 'generated_text' ], config = { "hallucination" : { "detector_name" : "default" }})

@ detect

def my_llm_app ( context , query ):

# my_llm_model is the function that generates text using the LLM model

generated_text = my_llm_model ( context , query )

return context , generated_textanalyze_prod Decorator.

Um die Effektivität unseres Systems zu demonstrieren, haben wir es gegen die beliebten Industrie -Benchmarks für die Halluzinationserkennungsaufgabe bewertet. Die folgende Tabelle zeigt unsere Ergebnisse.

Ein paar wichtige Imbissbuden:

✅ Aimon ist 10x billiger als GPT-4-Turbo.

✅ Aimon ist 4x schneller als GPT-4-Turbo.

✅ AIMON bietet die Bequemlichkeit einer vollständig gehosteten API, die die Erklärung der Erklärung beinhaltet.

✅ Unterstützung für eine Kontextlänge von bis zu 32.000 Token (mit Plänen, dies in naher Zukunft weiter zu erweitern).

Insgesamt ist Aimon 10-mal billiger, 4-mal schneller und in der Nähe oder sogar besser als GPT-4 auf den Benchmarks, was es sowohl für die Offline- als auch für die Online-Erkennung von Halluzinationen zu einer geeigneten Wahl macht.

| Metrisch | Aimon verlassen sich v1 | GPT-4 Turbo (LLM-as-a-Judge) |

|---|---|---|

| Kontextlänge | 32.000 | 128.000 |

| True Dataset Precision/Recall | 0,808 / 0,922 | 0,810 / 0,926 |

| Summe (Test) ausgewogene Genauigkeit | 0,778 | 0,756 |

| SVAC (Test) AUC | 0,809 | 0,780 |

| AnyScale -Ranking -Test für die Genauigkeit der Halluzinationen | 0,665 | 0,741 |

| AnyScale Ranking Test für Halluzinationen rel. Genauigkeit | 0,804 | 0,855 |

| Avg. Latenz | 417 ms | 1800 ms |

| Kosten (15 Millionen Token über alle Benchmark -Datensätze) ohne kostenlose Stufe | $ 15 | $ 158 |

| Voll gehostet | ✅ | ✅ |

| Erklärung | Automatische Ergebnisse auf Satzebene | Detaillierte Argumentation mit zusätzlichem schnellem Engineering |

Für diese Metriken fehlen die Benchmark-Datensätze für Branchenstandards. Wir werden bald einen Bewertungsdatensatz veröffentlichen. Bleiben Sie dran! ⌛

Weitere Informationen finden Sie in der Website aveon.ai.

Schließen Sie sich unserer Slack -Community bei, um die neuesten Updates und Diskussionen über generative KI -Zuverlässigkeit zu erhalten.