Uma lista com curadoria de documentos e ferramentas que abrangem ameaças e vulnerabilidades LLM, tanto do ponto de vista de segurança quanto de privacidade. Os resumos, os principais pontos de argumento e detalhes adicionais para cada artigo são encontrados na pasta Paper-Summeries.

O arquivo main.bib contém as citações mais recentes dos artigos listados aqui.

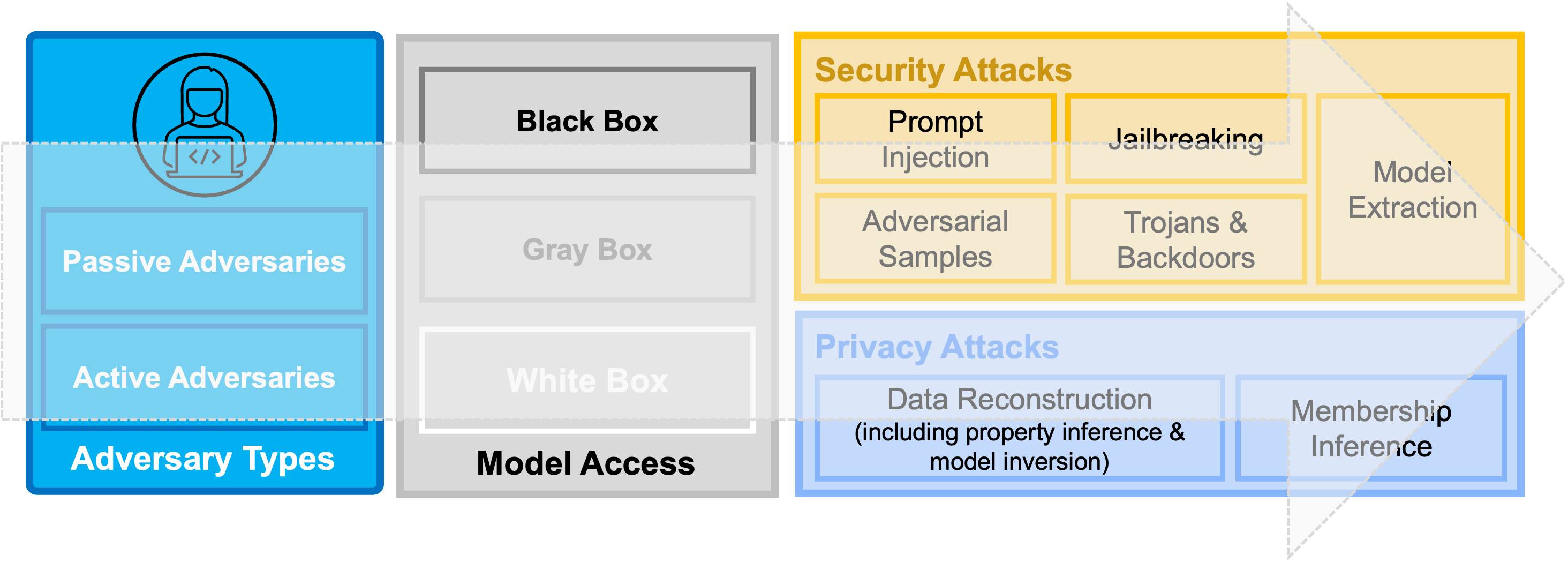

Visão geral Figura: Uma taxonomia das ameaças atuais de segurança e privacidade contra modelos de aprendizado profundo e modelos de idiomas consecutivamente grandes (LLMS).

Visão geral Figura: Uma taxonomia das ameaças atuais de segurança e privacidade contra modelos de aprendizado profundo e modelos de idiomas consecutivamente grandes (LLMS).

| Não. | Título do papel | Local | Ano | Categoria | Código | Resumo |

|---|---|---|---|---|---|---|

| 1. | Injetável: Benchmarking Indireto Primeiro injeções em grandes agentes de modelo de linguagem integrado a ferramentas | pré-impressão | 2024 | Injeção imediata | N / D | TBD |

| 2. | Os agentes LLM podem hackear sites autonomamente | pré-impressão | 2024 | Aplicações | N / D | TBD |

| 3. | Uma visão geral dos arrisários da IA catastrófica | pré-impressão | 2023 | Em geral | N / D | TBD |

| 4. | Uso de LLMs para fins ilícitos: ameaças, medidas de prevenção e vulnerabilidades | pré-impressão | 2023 | Em geral | N / D | TBD |

| 5. | Censura do LLM: um desafio de aprendizado de máquina ou um problema de segurança de computador? | pré-impressão | 2023 | Em geral | N / D | TBD |

| 6. | Além das salvaguardas: explorando os riscos de segurança do chatgpt | pré-impressão | 2023 | Em geral | N / D | TBD |

| 7. | Ataque de injeção imediata contra aplicações integradas de LLM | pré-impressão | 2023 | Injeção imediata | N / D | TBD |

| 8. | Identificando e mitigando os riscos de segurança de IA generativa | pré-impressão | 2023 | Em geral | N / D | TBD |

| 9. | Passgpt: modelagem de senha e geração (guiada) com grandes modelos de linguagem | Esorics | 2023 | Aplicações | TBD | |

| 10. | Aproveitando o GPT-4 para a geração de políticas GRC de segurança cibernética: um foco na mitigação de ataques de ransomware | Computadores e segurança | 2023 | Aplicações | N / D | TBD |

| 11. | Não é o que você se inscreveu: comprometendo aplicativos integrados ao mundo real com injeção indireta de injeção imediata | pré-impressão | 2023 | Injeção imediata | TBD | |

| 12. | Examinando reparo de vulnerabilidade com tiro zero com grandes modelos de linguagem | IEEE S&P | 2023 | Aplicações | N / D | TBD |

| 13. | Segurança da plataforma LLM: aplicando uma estrutura de avaliação sistemática aos plugins chatgpt da OpenAI | pré-impressão | 2023 | Em geral | N / D | TBD |

| 14. | A cadeia de verificação reduz a alucinação em grandes modelos de linguagem | pré-impressão | 2023 | Alucinações | N / D | TBD |

| 15. | Quiz pop! Um grande modelo de linguagem pode ajudar na engenharia reversa? | pré-impressão | 2022 | Aplicações | N / D | TBD |

| 16. | Extraindo dados de treinamento de grandes modelos de linguagem | Usenix Security | 2021 | Extração de dados | TBD | |

| 17. | Aí vem o worm da IA: desencadear vermes com cliques zero que têm como alvo aplicativos movidos a genai | pré-impressão | 2024 | Injeção rápida | TBD | |

| 18. | Cliff: aprendizado contrastante para melhorar a fidelidade e a factualidade em resumo abstrato | Emnlp | 2021 | Alucinações | TBD |

Se você estiver interessado em contribuir para este repositório, consulte Contribuindo.md para obter detalhes sobre as diretrizes.

Uma lista dos colaboradores atuais é encontrada aqui.

Para qualquer dúvida sobre este repositório e/ou colaborações em potencial (pesquisas), entre em contato com a Briland Hitaj.