Una lista curada de documentos y herramientas que cubren amenazas y vulnerabilidades de LLM, tanto desde el punto de vista de seguridad como de privacidad. Se encuentran resúmenes, puntos clave para llevar y detalles adicionales para cada documento en la carpeta de documentos de papel.

El archivo main.bib contiene las últimas citas de los documentos enumerados aquí.

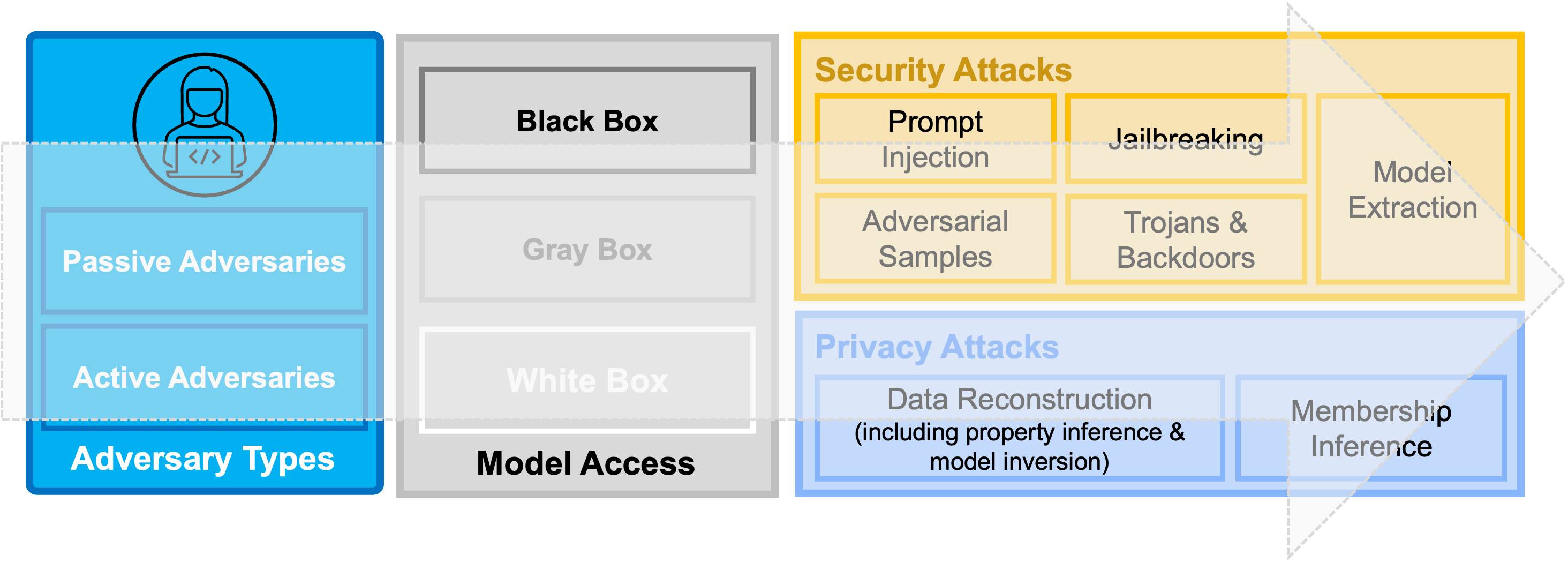

Figura general: una taxonomía de la seguridad actual y las amenazas de privacidad contra los modelos de aprendizaje profundo y los modelos de idiomas consecutivamente grandes (LLM).

Figura general: una taxonomía de la seguridad actual y las amenazas de privacidad contra los modelos de aprendizaje profundo y los modelos de idiomas consecutivamente grandes (LLM).

| No. | Título de papel | Evento | Año | Categoría | Código | Resumen |

|---|---|---|---|---|---|---|

| 1. | Inyectagent: Benchmarking inyecciones indirectas de inmediato en agentes de modelo de lenguaje grande integrado en herramientas | preimpresión | 2024 | Inyección rápida | N / A | TBD |

| 2. | Los agentes de LLM pueden piratear de forma autónoma sitios web | preimpresión | 2024 | Aplicaciones | N / A | TBD |

| 3. | Una descripción general de los riesgos catastróficos de IA | preimpresión | 2023 | General | N / A | TBD |

| 4. | Uso de LLM para fines ilícitos: amenazas, medidas de prevención y vulnerabilidades | preimpresión | 2023 | General | N / A | TBD |

| 5. | Censura de LLM: ¿Un desafío de aprendizaje automático o un problema de seguridad informática? | preimpresión | 2023 | General | N / A | TBD |

| 6. | Más allá de las salvaguardas: explorar los riesgos de seguridad de chatgpt | preimpresión | 2023 | General | N / A | TBD |

| 7. | Ataque de inyección inmediata contra aplicaciones integradas en LLM | preimpresión | 2023 | Inyección rápida | N / A | TBD |

| 8. | Identificar y mitigar los riesgos de seguridad de la IA generativa | preimpresión | 2023 | General | N / A | TBD |

| 9. | PASSGPT: modelado de contraseña y generación (guiada) con modelos de idiomas grandes | Esórico | 2023 | Aplicaciones | TBD | |

| 10. | Arnering GPT-4 para la generación de políticas de CyberseCurity GRC: un enfoque en la mitigación de ataque de ransomware | Computadoras y seguridad | 2023 | Aplicaciones | N / A | TBD |

| 11. | No es para lo que se ha registrado: comprometer aplicaciones integradas en el mundo real LLM con inyección indirecta de inmediato | preimpresión | 2023 | Inyección rápida | TBD | |

| 12. | Examinar la reparación de vulnerabilidades cero con modelos de idiomas grandes | IEEE S&P | 2023 | Aplicaciones | N / A | TBD |

| 13. | Seguridad de la plataforma LLM: aplicando un marco de evaluación sistemático a los complementos CHATGPT de OpenAI | preimpresión | 2023 | General | N / A | TBD |

| 14. | La cadena de verificación reduce la alucinación en modelos de idiomas grandes | preimpresión | 2023 | Alucinaciones | N / A | TBD |

| 15. | ¡Pop cuestión! ¿Puede un modelo de idioma grande ayudar con la ingeniería inversa? | preimpresión | 2022 | Aplicaciones | N / A | TBD |

| 16. | Extracción de datos de capacitación de modelos de idiomas grandes | Seguridad de Usenix | 2021 | Extracción de datos | TBD | |

| 17. | Aquí viene el gusano AI: desatando gusanos de clic cero que se dirigen a aplicaciones con alimentación de Genai | preimpresión | 2024 | Inyección inmediata | TBD | |

| 18. | Acantilado: aprendizaje contrastante para mejorar la fidelidad y la facturidad en el resumen abstracto | EMNLP | 2021 | Alucinaciones | TBD |

Si está interesado en contribuir a este repositorio, consulte Contriping.MD para obtener detalles sobre las pautas.

Aquí se encuentra una lista de contribuyentes actuales.

Para cualquier pregunta sobre este repositorio y/o posibles colaboraciones (investigación), comuníquese con Briland Hitaj.