Une liste organisée de papiers et d'outils couvrant les menaces et les vulnérabilités LLM, à la fois du point de vue de la sécurité et de la confidentialité. Des résumés, des points clés à retenir et des détails supplémentaires pour chaque article se trouvent dans le dossier papier-en été.

Le fichier main.bib contient les dernières citations des articles répertoriés ici.

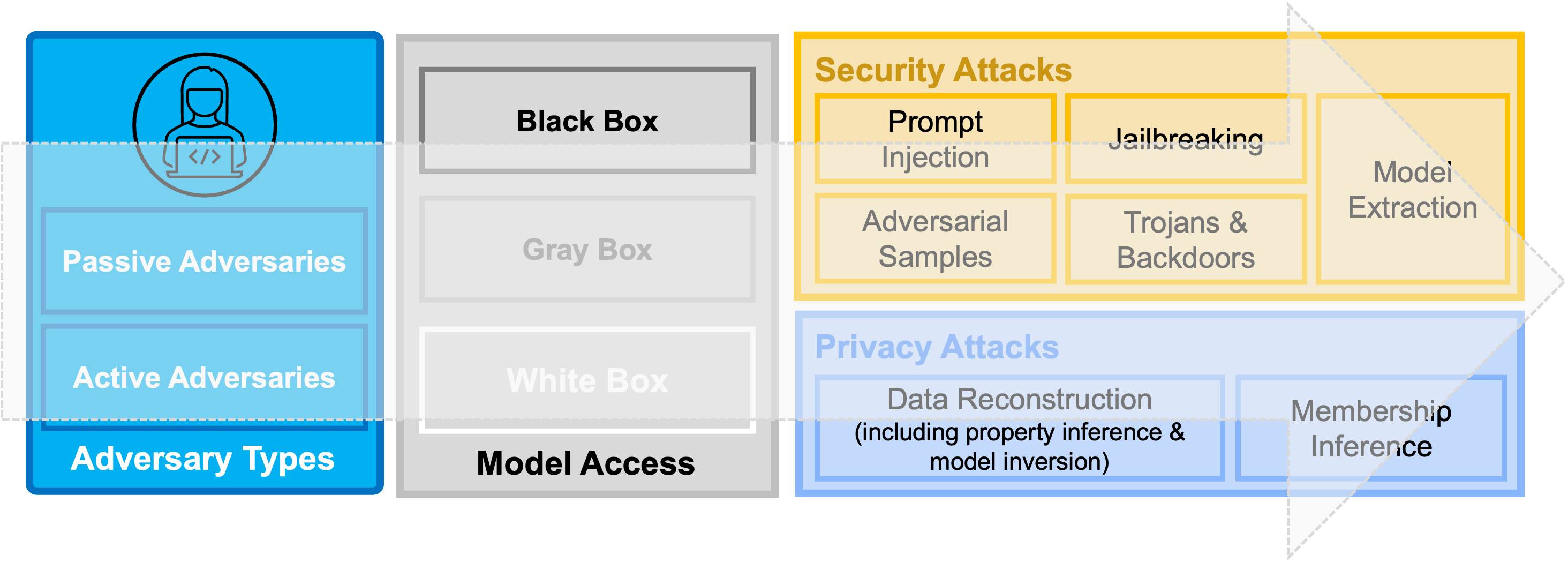

Présentation Figure: Une taxonomie des menaces actuelles de sécurité et de confidentialité contre les modèles d'apprentissage en profondeur et les modèles de langage consécutivement grands (LLM).

Présentation Figure: Une taxonomie des menaces actuelles de sécurité et de confidentialité contre les modèles d'apprentissage en profondeur et les modèles de langage consécutivement grands (LLM).

| Non. | Titre de papier | Lieu | Année | Catégorie | Code | Résumé |

|---|---|---|---|---|---|---|

| 1 et 1 | InjectAgent: analyse comparative d'injections rapide indirectes dans les agents de modèle de grande langue intégrés à l'outil | pré-imprimer | 2024 | Injection rapide | N / A | TBD |

| 2 | Les agents LLM peuvent pirater de manière autonome les sites Web | pré-imprimer | 2024 | Applications | N / A | TBD |

| 3 et 3 | Un aperçu des risques de l'IA catastrophique | pré-imprimer | 2023 | Général | N / A | TBD |

| 4 | Utilisation des LLM à des fins illicites: menaces, mesures de prévention et vulnérabilités | pré-imprimer | 2023 | Général | N / A | TBD |

| 5 | Censure LLM: un défi d'apprentissage automatique ou un problème de sécurité informatique? | pré-imprimer | 2023 | Général | N / A | TBD |

| 6. | Au-delà des garanties: explorer les risques de sécurité de Chatgpt | pré-imprimer | 2023 | Général | N / A | TBD |

| 7 | Attaque d'injection rapide contre les applications intégrées à LLM | pré-imprimer | 2023 | Injection rapide | N / A | TBD |

| 8 | Identifier et atténuer les risques de sécurité de l'IA générative | pré-imprimer | 2023 | Général | N / A | TBD |

| 9. | Passgpt: modélisation de mot de passe et génération (guidée) avec de grands modèles de langue | Ésoric | 2023 | Applications | TBD | |

| 10 | Exploitation du GPT-4 pour la génération de politiques de cybersécurité GRC: Focus sur l'atténuation des attaques des ransomwares | Ordinateurs et sécurité | 2023 | Applications | N / A | TBD |

| 11 | Pas ce pour quoi vous vous êtes inscrit: compromettre les applications réelles intégrées au monde LLM avec injection rapide indirecte | pré-imprimer | 2023 | Injection rapide | TBD | |

| 12 | Examiner la réparation de vulnérabilité zéro avec de grands modèles de langue | IEEE S&P | 2023 | Applications | N / A | TBD |

| 13 | Sécurité de la plate-forme LLM: appliquant un cadre d'évaluation systématique aux plugins ChatGPT d'OpenAI | pré-imprimer | 2023 | Général | N / A | TBD |

| 14 | La chaîne de vérification réduit les hallucinations dans les modèles de grande langue | pré-imprimer | 2023 | Hallucinations | N / A | TBD |

| 15 | Quiz pop! Un modèle grand langage peut-il aider à l'ingénierie inverse? | pré-imprimer | 2022 | Applications | N / A | TBD |

| 16 | Extraction des données de formation à partir de modèles de gros langues | Sécurité Usenix | 2021 | Extraction de données | TBD | |

| 17 | Voici le ver de l'IA: libérer des vers zéro cliquez sur les applications alimentées par Genai | pré-imprimer | 2024 | Injection rapide | TBD | |

| 18 | Cliff: apprentissage contrastif pour améliorer la fidélité et la factualité dans le résumé abstractif | EMNLP | 2021 | Hallucinations | TBD |

Si vous souhaitez contribuer à ce référentiel, veuillez consulter contribution.md pour plus de détails sur les directives.

Une liste des contributeurs actuelles se trouve ici.

Pour toute question concernant ce référentiel et / ou les collaborations potentielles (recherche), veuillez contacter Brilland Hitaj.