Eine kuratierte Liste von Papieren und Tools, die LLM -Bedrohungen und Schwachstellen sowohl aus Sicherheitsgründen als auch aus Datenschutzpunkten abdecken. Zusammenfassungen, wichtige Takeaway-Punkte und zusätzliche Details für jedes Papier finden Sie im Ordner Papier-Summen.

Main.bib -Datei enthält die neuesten Zitate der hier aufgeführten Artikel.

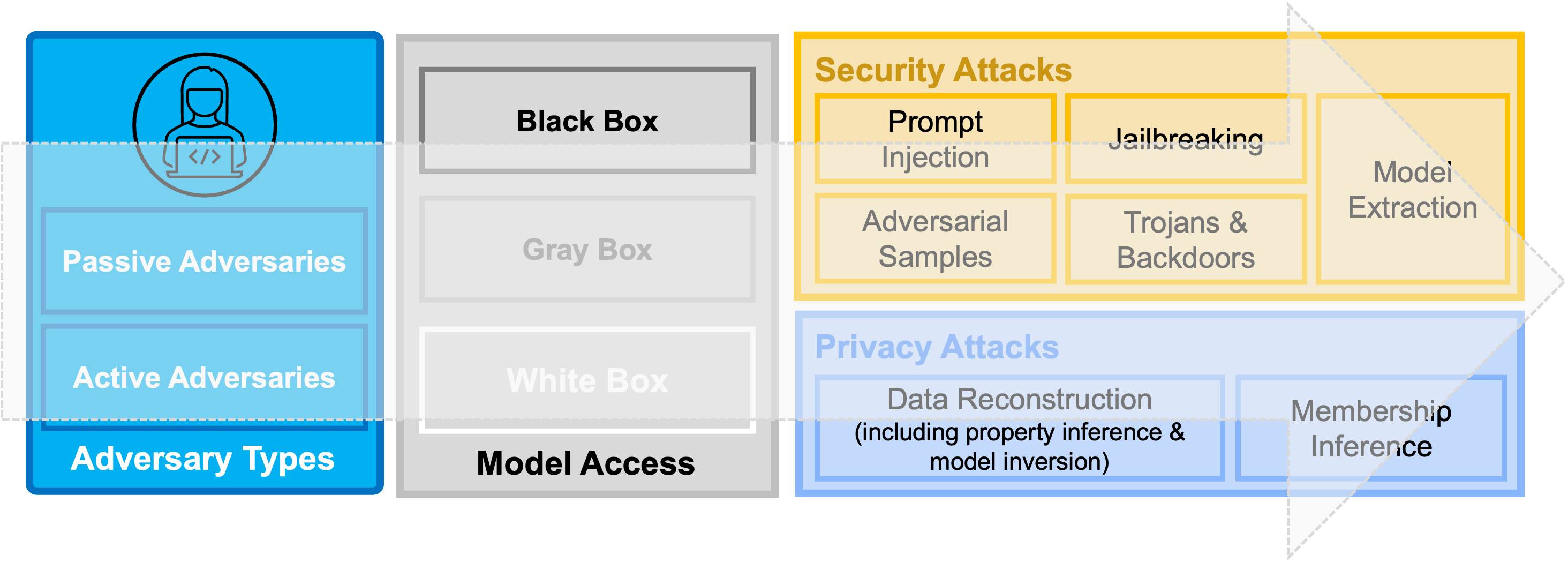

Übersicht Abbildung: Eine Taxonomie der aktuellen Sicherheits- und Datenschutzbedrohungen gegen Deep -Learning -Modelle und nacheinander große Sprachmodelle (LLMs).

Übersicht Abbildung: Eine Taxonomie der aktuellen Sicherheits- und Datenschutzbedrohungen gegen Deep -Learning -Modelle und nacheinander große Sprachmodelle (LLMs).

| NEIN. | Papierentitel | Veranstaltungsort | Jahr | Kategorie | Code | Zusammenfassung |

|---|---|---|---|---|---|---|

| 1. | Injectagent: Benchmarking Indirekte schnelle Injektionen in mit Werkzeugen integrierten Großsprachenmodellagenten | Vorabdruck | 2024 | Sofortige Injektion | N / A | TBD |

| 2. | LLM -Agenten können Websites autonom hacken | Vorabdruck | 2024 | Anwendungen | N / A | TBD |

| 3. | Ein Überblick über katastrophale KI -Risiken | Vorabdruck | 2023 | Allgemein | N / A | TBD |

| 4. | Verwendung von LLMs für illegale Zwecke: Bedrohungen, Präventionsmaßnahmen und Schwachstellen | Vorabdruck | 2023 | Allgemein | N / A | TBD |

| 5. | LLM -Zensur: Eine Herausforderung für maschinelles Lernen oder ein Problem der Computersicherheit? | Vorabdruck | 2023 | Allgemein | N / A | TBD |

| 6. | Über die Schutzmaßnahmen hinaus: Erforschung der Sicherheitsrisiken von ChatGPT | Vorabdruck | 2023 | Allgemein | N / A | TBD |

| 7. | Einheitlicher Injektionsangriff gegen LLM-integrierte Anwendungen | Vorabdruck | 2023 | Sofortige Injektion | N / A | TBD |

| 8. | Identifizierung und Minderung der Sicherheitsrisiken von generativem KI | Vorabdruck | 2023 | Allgemein | N / A | TBD |

| 9. | PASSGPT: Kennwortmodellierung und (geführte) Generation mit großen Sprachmodellen | Esorik | 2023 | Anwendungen | TBD | |

| 10. | GPT-4 für die Erzeugung von Cybersecurity GRC-Richtlinien nutzen: Ein Fokus auf Ransomware-Angriffsminderung | Computer & Sicherheit | 2023 | Anwendungen | N / A | TBD |

| 11. | Nicht das, wofür Sie sich angemeldet haben: Kompromisse bei der realen LLM-integrierten Anwendungen mit indirekter Einspritzung | Vorabdruck | 2023 | Sofortige Injektion | TBD | |

| 12. | Untersuchung der Reparatur von Null-Shot-Verwundbarkeit mit großartigen Modellen | IEEE S & P. | 2023 | Anwendungen | N / A | TBD |

| 13. | LLM -Plattformsicherheit: Anwenden eines systematischen Bewertungsframeworks auf OpenAI -ChatGPT -Plugins | Vorabdruck | 2023 | Allgemein | N / A | TBD |

| 14. | Die Kette der Verwendungskette reduziert die Halluzination in Großsprachenmodellen | Vorabdruck | 2023 | Halluzinationen | N / A | TBD |

| 15. | Pop -Quiz! Kann ein großes Sprachmodell bei Reverse Engineering helfen? | Vorabdruck | 2022 | Anwendungen | N / A | TBD |

| 16. | Extrahieren von Trainingsdaten aus Großsprachenmodellen | Usenix -Sicherheit | 2021 | Datenextraktion | TBD | |

| 17. | Hier kommt der KI-Wurm: Entfesselung von Null-Klick-Würmern, die auf genai-betriebene Anwendungen abzielen | Vorabdruck | 2024 | Eingabeaufforderung | TBD | |

| 18. | Cliff: Kontrastives Lernen zur Verbesserung der Treue und Fakten in der abstrakten Zusammenfassung | EMNLP | 2021 | Halluzinationen | TBD |

Wenn Sie daran interessiert sind, zu diesem Repository beizutragen, finden Sie Informationen zu den Richtlinien.

Hier finden Sie eine Liste der aktuellen Mitwirkenden.

Bei Fragen zu diesem Repository- und/oder potenziellen (Forschungs-) Kooperationen wenden Sie sich bitte an Briland Hitaj.