Exploração do desempenho do GPT-4 e ChatGPT (ambos open) no Projeto Euler, um conjunto de problemas que misturam raciocínio e programação matemática.

Aqui, forneci o texto e as equações (quando necessário usando formatação de látex, que GPT-4 e ChatGPT são capazes de analisar) para representar problemas do projeto Euler 1-30 como um prompt. Para consistência, em todos os casos, adicionei uma frase solicitando a solução na forma de um script python. Depois de avaliar esse script contra linhas de base conhecidas e fundamentadas, solicitei o GPT-4 ou o Chatgpt a tentar novamente ou mudei para o próximo problema.

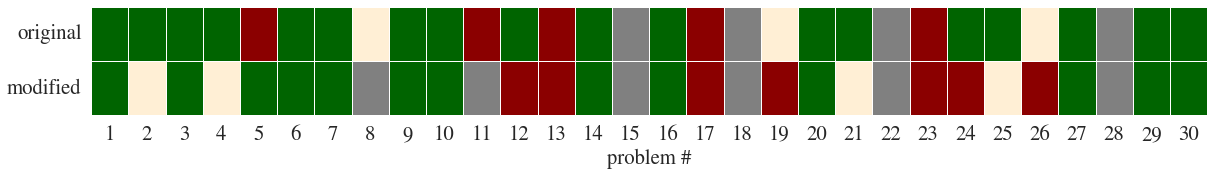

Em seguida, modifiquei os problemas de modo que o conceito e a estrutura do problema permanecessem os mesmos, mas as particularidades foram alteradas (como este exemplo); Isso produziu alguns resultados mais interessantes (veja comentários).

Aqui, Green denota Chatgpt, encontrando a solução correta no início; laranja em segunda pergunta; Vermelho significa que não encontrou a solução. Gray significa que eu não consegui encontrar uma boa maneira de representar o problema, geralmente porque exigia entender uma imagem.

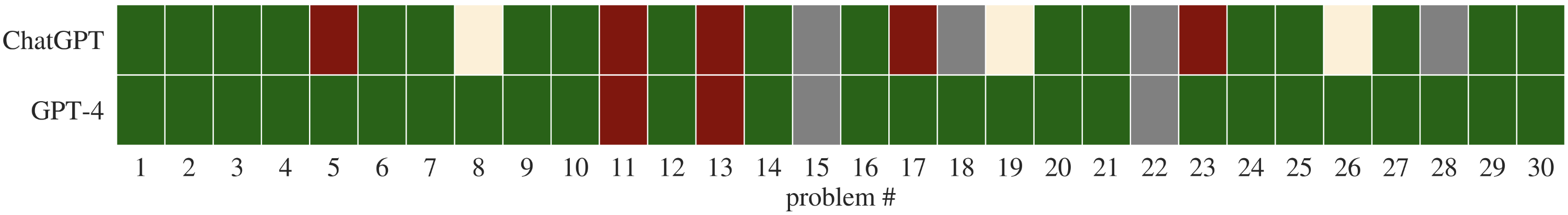

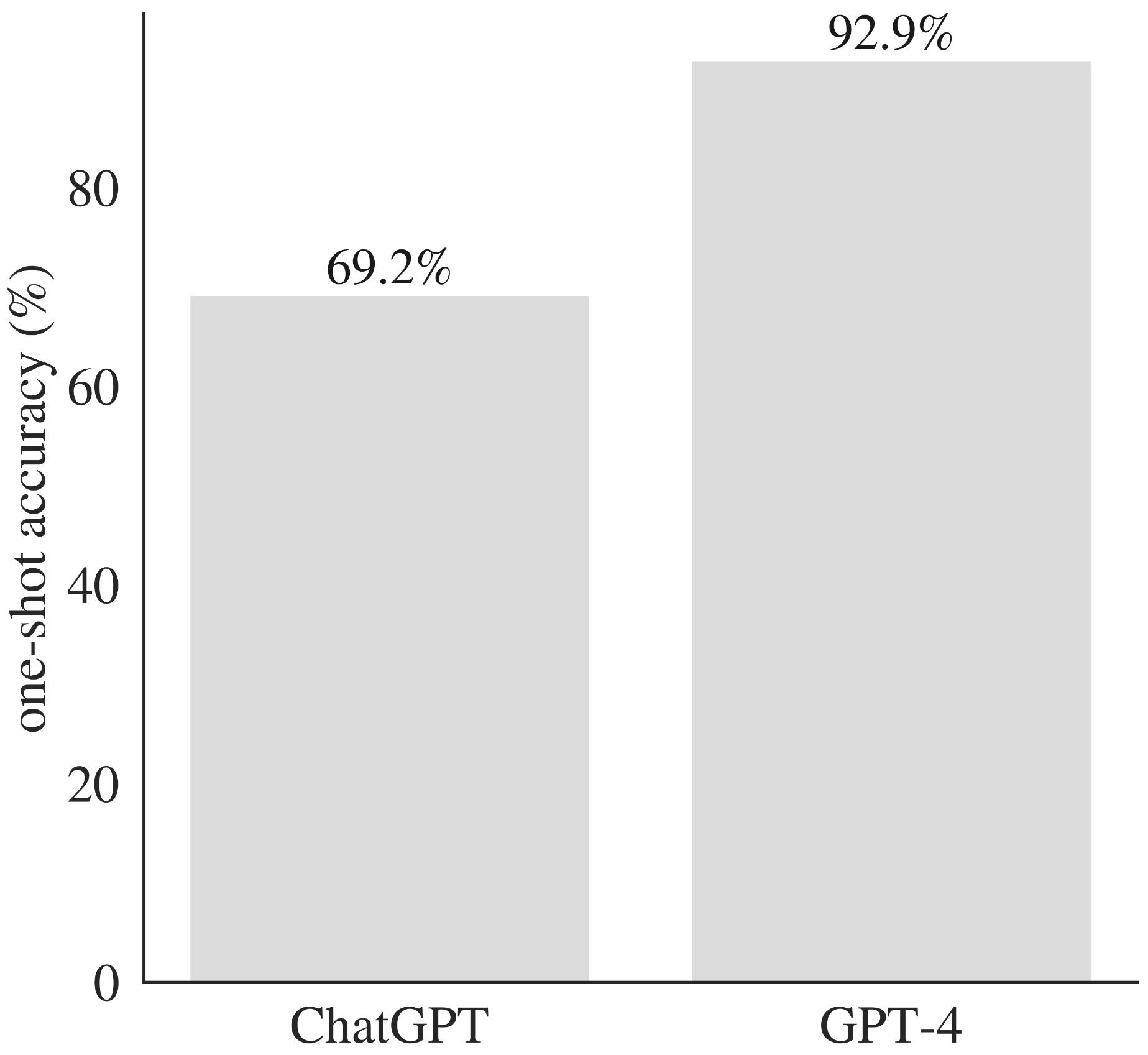

Aumentando o GPT-4 e o ChatGPT com os problemas originais também permitem uma comparação direta de seu desempenho.

O GPT-4 supera o chatgpt nos problemas correspondentes.

| Problema # | Solução de verdadeira-verdade | Soluções chatgpt | Soluções GPT-4 |

|---|---|---|---|

| Problema 1 | Problema 1 solução | primeira tentativa | primeira tentativa |

| Problema 2 | Problema 2 Solução | primeira tentativa | primeira tentativa |

| Problema 3 | Problema 3 Solução | primeira tentativa | primeira tentativa |

| Problema 4 | Problema 4 Solução | primeira tentativa | primeira tentativa |

| Problema 5 | Problema 5 Solução | Primeira tentativa - segunda tentativa | primeira tentativa |

| Problema 6 | Problema 6 Solução | primeira tentativa | primeira tentativa |

| Problema 7 | Problema 7 Solução | primeira tentativa | primeira tentativa |

| Problema 8 | Problema 8 Solução | Primeira tentativa - segunda tentativa | primeira tentativa |

| Problema 9 | Problema 9 Solução | primeira tentativa | primeira tentativa |

| Problema 10 | Problema 10 Solução | primeira tentativa | primeira tentativa |

| Problema 11 | Problema 11 Solução | Primeira tentativa - segunda tentativa | Primeira tentativa - segunda tentativa |

| Problema 12 | Problema 12 Solução | primeira tentativa | primeira tentativa |

| Problema 13 | Problema 13 Solução | Primeira tentativa - segunda tentativa | Primeira tentativa - segunda tentativa |

| Problema 14 | Problema 14 Solução | primeira tentativa | primeira tentativa |

| Problema 15 | Problema 15 Solução | n / D | n / D |

| Problema 16 | Problema 16 Solução | primeira tentativa | primeira tentativa |

| Problema 17 | Problema 17 Solução | Primeira tentativa - segunda tentativa | primeira tentativa |

| Problema 18 | Problema 18 Solução | n / D | primeira tentativa |

| Problema 19 | Problema 19 Solução | Primeira tentativa - segunda tentativa | primeira tentativa |

| Problema 20 | Problema 20 Solução | primeira tentativa | primeira tentativa |

| Problema 21 | Problema 21 Solução | primeira tentativa | primeira tentativa |

| Problema 22 | Problema 22 Solução | n / D | n / D |

| Problema 23 | Problema 23 Solução | Primeira tentativa - segunda tentativa | primeira tentativa |

| Problema 24 | Problema 24 Solução | primeira tentativa | primeira tentativa |

| Problema 25 | Problema 25 Solução | primeira tentativa | primeira tentativa |

| Problema 26 | Problema 26 Solução | Primeira tentativa - segunda tentativa | primeira tentativa |

| Problema 27 | Problema 27 Solução | primeira tentativa | primeira tentativa |

| Problema 28 | Problema 28 Solução | n / D | primeira tentativa |

| Problema 29 | Problema 29 Solução | primeira tentativa | primeira tentativa |

| Problema 30 | Problema 30 Solução | primeira tentativa | primeira tentativa |

O desempenho foi inegavelmente impressionante, dado o desafio desses problemas (e significativamente melhor do que o desempenho do ChatGPT nos Promtps correspondentes). Os dois problemas para os quais o GPT-4 falharam em produzir uma solução de trabalho, ambos envolveram a análise muito longa (400 e 5000 dígitos, respectivamente), talvez sugerindo uma falha de tokenização, em vez de raciocinar.

O GPT-4 supera o ChatGPT em termos de precisão de um tiro em uma variedade de problemas matemáticos e de programação.

O desempenho foi, na minha opinião, bastante impressionante. O ChatGPT não (obviamente) regurgitou as amostras de código de seu conjunto de dados de treinamento (nenhum dos scripts do Python gerou correspondeu a nenhum no GitHub ou Gitlab) e às vezes fazia tentativas para otimizar a solução (por exemplo, usando abordagens de divisão e conquista no Problema 19, ou no Problema 6 onde usa:

Conforme observado por outros, o modelo luta com números muito grandes, mesmo quando eles não aumentam apreciavelmente a dificuldade conceitual do problema (CF Problema 13).

Finalmente, os problemas modificados produziram algumas idéias. Em vários casos, o modelo gerou um script python que gerou a resposta correta (para o problema modificado), mas o ChatGPT escreveu a resposta numérica da pergunta original. Em outros casos, ignorou completamente a redação modificada e me forneceu uma solução de trabalho para o enquadramento original do problema.