Exploración del rendimiento de GPT-4 y ChatGPT (ambos OpenAI) en Project Euler, un conjunto de problemas que combinan el razonamiento y la programación matemática.

Aquí, proporcioné el texto y las ecuaciones (cuando sea necesario, utilizando el formato de látex, que GPT-4 y ChatGPT pueden analizar) para representar los problemas del Proyecto Euler 1-30 como un aviso. Para consistencia, en todos los casos, agregué una oración solicitando la solución en forma de un script de Python. Después de evaluar este script contra líneas de base de verdades de verdad conocidas, luego solicité GPT-4 o ChatGPT a intentarlo nuevamente, o pasé al siguiente problema.

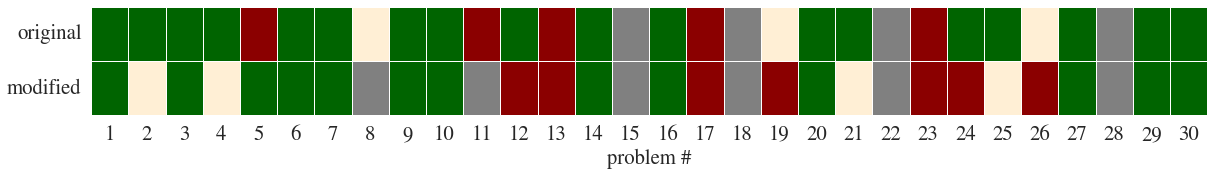

Luego modifiqué los problemas de tal manera que el concepto y la estructura del problema se mantuvieron igual, pero las particularidades se cambiaron (como este ejemplo); Esto arrojó algunos resultados más interesantes (ver comentarios).

Aquí, Green denota ChatGPT para encontrar la solución correcta al principio preguntando; naranja en la segunda pregunta; Rojo significa que no encontró la solución. Gray significa que no pude encontrar una buena manera de representar el problema, generalmente porque requería comprender una imagen.

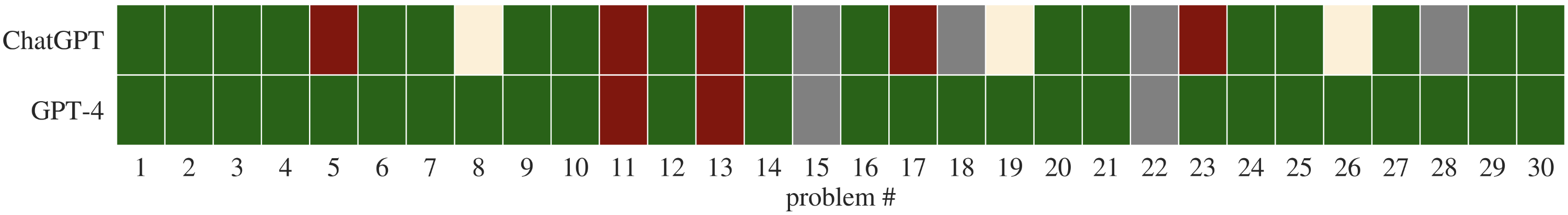

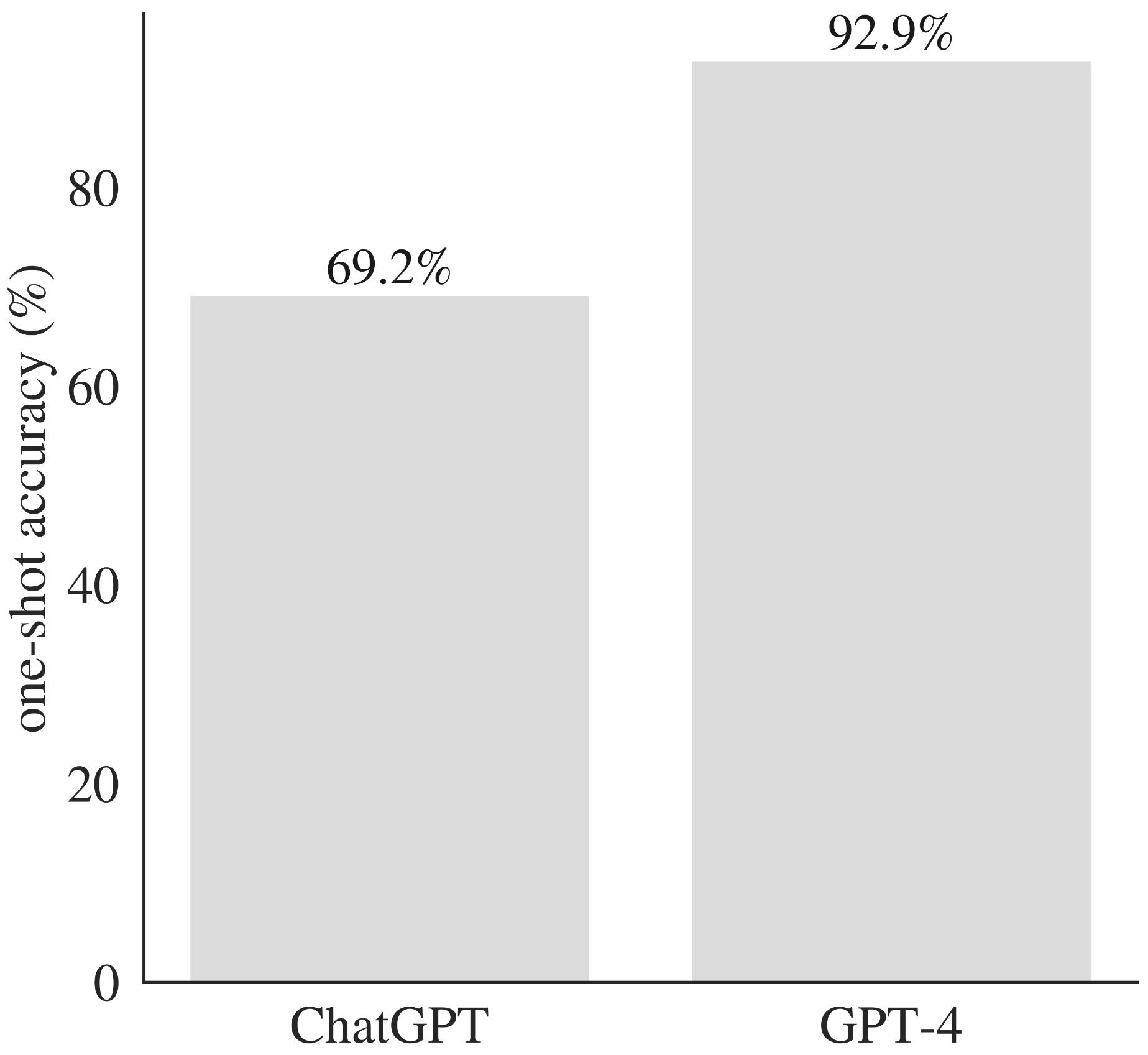

Involucrar tanto a GPT-4 como a ChatGPT con los problemas originales también permite una comparación directa de su rendimiento.

GPT-4 supera a ChatGPT en problemas coincidentes.

| Problema # | Solución de verdad en tierra | Soluciones de chatgpt | Soluciones GPT-4 |

|---|---|---|---|

| Problema 1 | Solución del problema 1 | primer intento | primer intento |

| Problema 2 | Solución del problema 2 | primer intento | primer intento |

| Problema 3 | Solución del problema 3 | primer intento | primer intento |

| Problema 4 | Solución del problema 4 | primer intento | primer intento |

| Problema 5 | Solución del problema 5 | Primer intento - Segundo intento | primer intento |

| Problema 6 | Solución del problema 6 | primer intento | primer intento |

| Problema 7 | Problema 7 Solución | primer intento | primer intento |

| Problema 8 | Problema 8 Solución | Primer intento - Segundo intento | primer intento |

| Problema 9 | Solución del problema 9 | primer intento | primer intento |

| Problema 10 | Solución del problema 10 | primer intento | primer intento |

| Problema 11 | Problema 11 Solución | Primer intento - Segundo intento | Primer intento - Segundo intento |

| Problema 12 | Solución del problema 12 | primer intento | primer intento |

| Problema 13 | Solución del problema 13 | Primer intento - Segundo intento | Primer intento - Segundo intento |

| Problema 14 | Solución del problema 14 | primer intento | primer intento |

| Problema 15 | Solución del problema 15 | n / A | n / A |

| Problema 16 | Problema 16 Solución | primer intento | primer intento |

| Problema 17 | Problema 17 Solución | Primer intento - Segundo intento | primer intento |

| Problema 18 | Solución del problema 18 | n / A | primer intento |

| Problema 19 | Solución del problema 19 | Primer intento - Segundo intento | primer intento |

| Problema 20 | Solución de problema 20 | primer intento | primer intento |

| Problema 21 | Solución del problema 21 | primer intento | primer intento |

| Problema 22 | Solución del problema 22 | n / A | n / A |

| Problema 23 | Solución del problema 23 | Primer intento - Segundo intento | primer intento |

| Problema 24 | Solución del problema 24 | primer intento | primer intento |

| Problema 25 | Problema 25 Solución | primer intento | primer intento |

| Problema 26 | Problema 26 Solución | Primer intento - Segundo intento | primer intento |

| Problema 27 | Solución de problema 27 | primer intento | primer intento |

| Problema 28 | Problema 28 Solución | n / A | primer intento |

| Problema 29 | Problema 29 Solución | primer intento | primer intento |

| Problema 30 | Solución del problema 30 | primer intento | primer intento |

El rendimiento fue innegablemente impresionante dado el desafío de estos problemas (y significativamente mejor que el rendimiento de ChatGPT en PROMTP coincidentes). Los dos problemas para los que GPT-4 no pudo producir una solución de trabajo implicaron analizar números muy largos (400 y 5000 dígitos, respectivamente), tal vez sugiriendo una falla de la tokenización en lugar de razonarse.

GPT-4 supera a ChatGPT en términos de precisión de un solo disparo en una gama de problemas matemáticos y de programación.

El rendimiento fue, en mi opinión, bastante impresionante. ChatGPT no regurgitó (obviamente) muestras de código de su conjunto de datos de entrenamiento (ninguno de los scripts de Python generados coincidió con GitHub o Gitlab), y a veces hizo intentos de optimizar la solución (por ejemplo, utilizando enfoques divididos y conquistadores en el problema 19, o en el problema 6 donde usa:

Como señalaron otros, el modelo lucha con cantidades muy grandes, incluso cuando no aumentan apreciablemente la dificultad conceptual del problema (CF Problema 13).

Finalmente, los problemas modificados arrojaron algunas ideas. En varios casos, el modelo generó un script de Python que generó la respuesta correcta (para el problema modificado), pero ChatGPT escribió la respuesta numérica de la pregunta original. En otros casos, ignoró por completo la redacción modificada y me proporcionó una solución de trabajo para el encuadre original del problema.