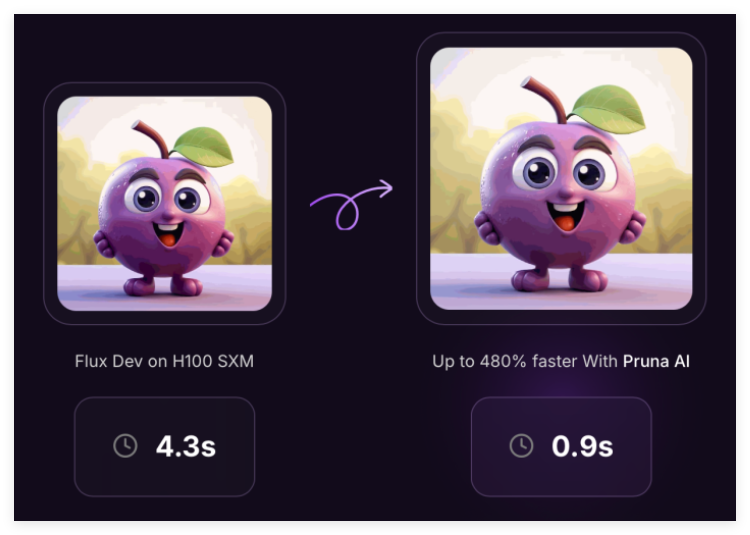

Pruna AI는 AI 모델을위한 압축 알고리즘 개발에 중점을 둔 유럽의 스타트 업입니다. 최근이 회사는 개발자가 더 효율적으로 압축하고 AI 모델을 압축하고 AI 모델을 확보 할 수 있도록 최적화 프레임 워크를 개방 할 것이라고 발표했습니다.

Pruna AI가 개발 한 프레임 워크는 캐싱, 가지 치기, 양자화 및 증류를 포함한 다양한 효율적인 접근 방식을 결합하여 AI 모델의 성능을 향상시킵니다. 이 프레임 워크는 압축 모델의 저장 및 로딩을 표준화 할뿐만 아니라 압축 모델을 평가하여 압축으로 인한 성능 향상을 측정하면서 품질이 크게 떨어 졌는지 여부를 결정합니다.

Pruna AI의 공동 창립자이자 최고 기술 책임자 인 John Rachwan은“우리의 프레임 워크는 Face의 변압기 및 디퓨저 표준화와 유사하며 다양한 효율성 방법을 통일하고 사용하는 통일 된 방법을 제공합니다. OpenAI와 같은 대기업은 증류를 사용하여 플래그십 모델의 빠른 버전을 만드는 것과 같은 모델에 여러 압축 방법을 적용했습니다.

증류는 개발자가 교사 모델과 기록 출력에 요청을 보내는 "교사 학생"모델을 통해 지식을 추출하는 기술입니다. 그런 다음 이러한 출력은 학생 모델을 교육하여 교사 모델의 동작을 근사화하는 데 사용됩니다. Lahwan은 많은 대기업이 압축 도구 자체를 구축하는 경향이 있지만 오픈 소스 커뮤니티에서는 단일 방법을 기반으로 한 솔루션이 종종 발견되며 Pruna AI는 여러 방법을 통합하여 사용 프로세스를 크게 단순화하는 도구를 제공한다고 지적합니다.

현재 Pruna AI의 프레임 워크는 대형 언어 모델, 확산 모델, 음성 인식 모델 및 컴퓨터 비전 모델을 포함한 다양한 모델을 지원합니다. 그러나이 회사는 현재 이미지 및 비디오 생성 모델의 최적화에 중점을두고 있습니다. 시나리오 및 Photoroom과 같은 회사는 이미 Pruna AI 서비스를 사용했습니다.

Pruna AI는 오픈 소스 버전 외에도 고급 최적화 기능과 최적화 에이전트가 포함 된 엔터프라이즈 버전도 출시했습니다. "우리가 출시하려는 가장 흥미로운 기능은 압축 에이전트입니다. 여기서 사용자는 모델을 제공하고 속도 및 정확도 요구 사항을 설정하면됩니다. 에이전트는 최상의 압축 조합을 자동으로 찾을 수 있습니다."

Pruna AI는 사용자가 클라우드 서비스에 GPU를 임대하는 방식과 유사한 시간당 요금을 청구합니다. 최적화 된 모델을 사용함으로써 비즈니스는 추론 할 때 많은 돈을 절약 할 수 있습니다. 예를 들어, Pruna AI는 정확도가 거의 손실되지 않으면 서 LLAMA 모델의 크기를 8 배나 성공적으로 줄였습니다. 회사는 고객이 압축 프레임 워크를 궁극적으로 수익을 얻는 투자로 볼 수 있기를 희망합니다.

최근 Pruna AI는 EQT Ventures, Daphni, Motier Ventures 및 Kima Ventures를 포함한 투자자와 함께 650 만 달러의 종자 파이낸싱을 완료했습니다.

프로젝트 : https://github.com/prunaai/pruna

핵심 사항 :

Pruna AI는 여러 압축 방법을 결합하여 AI 모델의 성능을 향상시키는 오픈 소스 최적화 프레임 워크를 시작합니다.

대기업은 종종 증류 및 기타 기술을 사용하며 Pruna AI는 사용 프로세스를 단순화하기 위해 여러 방법을 통합하는 도구를 제공합니다.

Enterprise Edition은 고급 기능을 지원하여 사용자가 정확도를 유지하면서 모델 압축 및 성능 향상을 달성 할 수 있도록 도와줍니다.