Pruna AIは、AIモデルの圧縮アルゴリズムの開発に焦点を当てたヨーロッパのスタートアップです。最近、同社は、開発者がより効率的にモデルを圧縮し、AIモデルを支援するために最適化フレームワークをオープンすると発表しました。

Pruna AIによって開発されたフレームワークは、AIモデルのパフォーマンスを向上させるために、キャッシュ、剪定、量子化、蒸留など、さまざまな効率的アプローチを組み合わせています。このフレームワークは、圧縮モデルのストレージと負荷を標準化するだけでなく、圧縮モデルを評価して、圧縮によってもたらされるパフォーマンスの改善を測定しながら、その品質が大幅に低下したかどうかを判断します。

「私たちのフレームワークは、トランスとディフューザーのFaceの標準化に似ており、さまざまな効率的な方法を呼び出して使用する統一された方法を提供します」 Openaiなどの大企業は、蒸留を使用してフラッグシップモデルのより高速なバージョンを作成するなど、モデルに重圧縮法を適用しています。

蒸留は、開発者が教師モデルにリクエストを送信して出力を記録する「教師と学生」モデルを通じて知識を抽出するテクノロジーです。これらの出力は、生徒モデルをトレーニングするために使用され、教師モデルの動作を近似します。 Lahwanは、多くの大企業が圧縮ツール自体を構築する傾向があるのに対し、オープンソースコミュニティでは、単一の方法に基づくソリューションはしばしば見つかり、Pruna AIは複数の方法を統合するツールを提供し、使用プロセスを大幅に簡素化すると述べています。

現在、Pruna AIのフレームワークは、大規模な言語モデル、拡散モデル、音声認識モデル、コンピュータービジョンモデルなど、さまざまなモデルをサポートしています。しかし、同社は現在、画像およびビデオ生成モデルの最適化に焦点を当てています。シナリオやPhotoroomなどの企業は、すでにPruna AIサービスを使用しています。

オープンソースバージョンに加えて、Pruna AIは、高度な最適化機能と最適化エージェントを含むエンタープライズバージョンも起動しています。 「私たちがリリースしようとしている最もエキサイティングな機能は圧縮エージェントです。ここでは、ユーザーはモデルを提供し、速度と精度の要件を設定するだけで、エージェントは自動的に最高の圧縮の組み合わせを見つけます。」

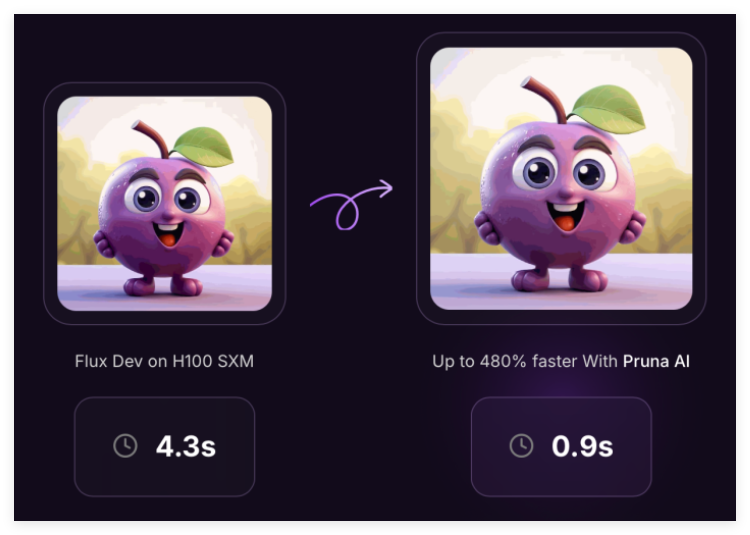

Pruna AIは、ユーザーがクラウドサービスでGPUをレンタルする方法と同様に、1時間ごとの料金を請求します。最適化されたモデルを使用することにより、企業は推論するときに多くのお金を節約できます。たとえば、Pruna AIは、ラマモデルのサイズを8回縮小し、精度はほとんどありませんでした。同社は、顧客がその圧縮フレームワークを最終的にリターンを獲得する投資と見なすことができることを望んでいます。

最近、Pruna AIは、EQT Ventures、Daphni、Motier Ventures、Kima Venturesなどの投資家とともに、650万ドルの種子資金調達を完了しました。

プロジェクト:https://github.com/prunaai/pruna

キーポイント:

Pruna AIは、AIモデルのパフォーマンスを改善するために、重圧縮法を組み合わせたオープンソース最適化フレームワークを開始します。

大企業は蒸留やその他の技術を使用することが多く、Pruna AIは複数の方法を統合して使用プロセスを簡素化するツールを提供します。

Enterprise Editionは、精度を維持しながら、ユーザーがモデルの圧縮とパフォーマンスの改善を達成できるように、高度な機能をサポートしています。