Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

Pruna AI est une startup d'Europe axée sur le développement d'algorithmes de compression pour les modèles d'IA. Récemment, la société a annoncé qu'elle ouvrirait son cadre d'optimisation pour aider les développeurs à comprimer et à des modèles d'IA plus efficacement.

Le cadre développé par Pruna AI combine une variété d'approches d'efficacité, notamment la mise en cache, l'élagage, la quantification et la distillation, pour améliorer les performances des modèles d'IA. Ce cadre non seulement standardise le stockage et le chargement des modèles de compression, mais évalue également le modèle compressé pour déterminer si sa qualité a chuté de manière significative tout en mesurant les améliorations des performances apportées par la compression.

"Notre cadre est similaire à la standardisation des transformateurs et des diffuseurs par les étreintes, et nous fournissons un moyen unifié d'appeler et d'utiliser diverses méthodes d'efficacité", a déclaré John Rachwan, co-fondateur et directeur de la technologie de Pruna AI. Les grandes entreprises telles que OpenAI ont appliqué plusieurs méthodes de compression dans leurs modèles, telles que l'utilisation de la distillation pour créer des versions plus rapides de leurs modèles phares.

La distillation est une technologie qui extrait les connaissances via le modèle "Teacher-Student", où les développeurs envoient des demandes au modèle des enseignants et enregistrent la sortie. Ces sorties sont ensuite utilisées pour former le modèle étudiant à approximer le comportement du modèle de l'enseignant. Lahwan note que si de nombreuses grandes entreprises ont tendance à créer elles-mêmes des outils de compression, dans la communauté open source, des solutions basées sur une seule méthode sont souvent trouvées uniquement, et Pruna AI fournit un outil qui intègre plusieurs méthodes, simplifiant considérablement le processus d'utilisation.

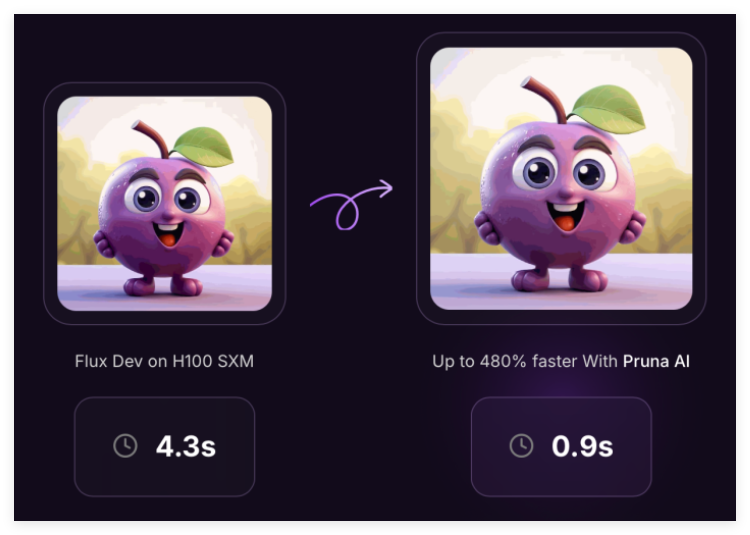

Actuellement, le cadre de Pruna AI prend en charge une variété de modèles, y compris des modèles de grands langues, des modèles de diffusion, des modèles de reconnaissance vocale et des modèles de vision par ordinateur. Mais l'entreprise se concentre actuellement sur l'optimisation des modèles de génération d'images et de vidéo. Des sociétés telles que Scénario et Photoroom ont déjà utilisé les services Pruna AI.

En plus de la version open source, Pruna AI a également lancé une version d'entreprise qui comprend des fonctionnalités d'optimisation avancées et un agent d'optimisation. "La fonctionnalité la plus excitante que nous allons publier est l'agent de compression, où les utilisateurs doivent seulement fournir le modèle et définir les exigences de vitesse et de précision, et l'agent trouvera automatiquement la meilleure combinaison de compression."

Pruna AI facture des frais horaires, similaires à la façon dont les utilisateurs louent des GPU sur les services cloud. En utilisant des modèles optimisés, les entreprises peuvent économiser beaucoup d'argent lors du raisonnement. Par exemple, Pruna AI a réussi à réduire la taille d'un modèle de lama de huit fois, avec peu de perte de précision. La société espère que les clients pourront considérer son cadre de compression comme un investissement qui gagne finalement des rendements.

Récemment, Pruna AI a achevé un financement de semences de 6,5 millions de dollars, avec des investisseurs tels que EQT Ventures, Daphni, Motier Ventures et Kima Ventures.

Projet: https://github.com/prunaai/pruna

Points clés:

Pruna AI lance un cadre d'optimisation open source qui combine plusieurs méthodes de compression pour améliorer les performances des modèles d'IA.

Les grandes entreprises utilisent souvent la distillation et d'autres technologies, et Pruna AI fournit des outils qui intègrent plusieurs méthodes pour simplifier le processus d'utilisation.

L'Enterprise Edition prend en charge les fonctionnalités avancées pour aider les utilisateurs à réaliser des améliorations de compression et de performances tout en maintenant la précision.