Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

Pruna AI es una startup de Europa centrada en el desarrollo de algoritmos de compresión para modelos de IA. Recientemente, la compañía anunció que abrirá su marco de optimización para ayudar a los desarrolladores a comprimir y a los modelos de IA de manera más eficiente.

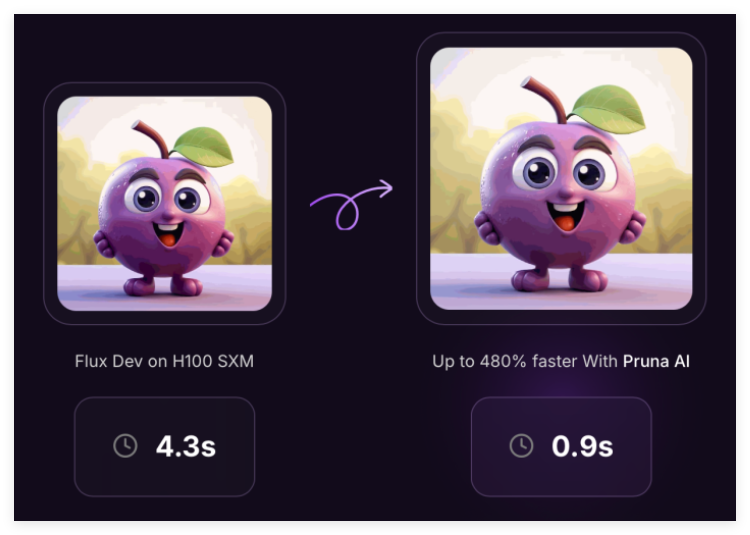

El marco desarrollado por Pruna AI combina una variedad de enfoques de eficiencia, que incluyen almacenamiento en caché, poda, cuantización y destilación, para mejorar el rendimiento de los modelos de IA. Este marco no solo estandariza el almacenamiento y la carga de los modelos de compresión, sino que también evalúa el modelo comprimido para determinar si su calidad ha disminuido significativamente mientras mide las mejoras de rendimiento traídas por la compresión.

"Nuestro marco es similar a la estandarización de los transformadores y difusores de Hugging Face, y proporcionamos una forma unificada de llamar y usar varios métodos de eficiencia", dijo John Rachwan, cofundador y director de tecnología de Pruna AI. Las grandes empresas como OpenAI han aplicado múltiples métodos de compresión en sus modelos, como el uso de la destilación para crear versiones más rápidas de sus modelos insignia.

La destilación es una tecnología que extrae conocimiento a través del modelo "maestro-estudiante", donde los desarrolladores envían solicitudes al modelo de maestro y la producción de registro. Estas salidas se utilizan para capacitar al modelo de estudiante para aproximar el comportamiento del modelo de maestro. Lahwan señala que si bien muchas grandes empresas tienden a construir herramientas de compresión mismas, en la comunidad de código abierto, a menudo solo se encuentran soluciones basadas en un solo método, y Pruna AI proporciona una herramienta que integra múltiples métodos, simplificando en gran medida el proceso de uso.

Actualmente, el marco de Pruna AI admite una variedad de modelos, incluidos modelos de idiomas grandes, modelos de difusión, modelos de reconocimiento de voz y modelos de visión por computadora. Pero la compañía se está centrando actualmente en la optimización de los modelos de generación de imágenes y videos. Empresas como Escenario y Photoroom ya han utilizado los servicios de Pruna AI.

Además de la versión de código abierto, Pruna AI también ha lanzado una versión empresarial que incluye funciones de optimización avanzadas y un agente de optimización. "La característica más emocionante que estamos a punto de lanzar es el agente de compresión, donde los usuarios solo necesitan proporcionar el modelo y establecer los requisitos de velocidad y precisión, y el agente encontrará automáticamente la mejor combinación de compresión".

Pruna AI cobra una tarifa por hora, similar a la forma en que los usuarios alquilan GPU en los servicios en la nube. Al usar modelos optimizados, las empresas pueden ahorrar mucho dinero al razonar. Por ejemplo, Pruna AI redujo con éxito el tamaño de un modelo de llama en ocho veces, con poca pérdida de precisión. La compañía espera que los clientes puedan ver su marco de compresión como una inversión que finalmente obtiene rendimientos.

Recientemente, Pruna AI completó un financiamiento de semillas de $ 6.5 millones, con inversores que incluyen EQT Ventures, Daphni, Motier Ventures y Kima Ventures.

Proyecto: https://github.com/prunaai/pruna

Puntos clave:

Pruna AI inicia un marco de optimización de código abierto que combina múltiples métodos de compresión para mejorar el rendimiento de los modelos de IA.

Las grandes empresas a menudo usan la destilación y otras tecnologías, y Pruna AI proporciona herramientas que integran múltiples métodos para simplificar el proceso de uso.

La edición Enterprise admite funciones avanzadas para ayudar a los usuarios a lograr mejoras de compresión y rendimiento del modelo mientras mantiene la precisión.