Pruna AI ist ein Startup aus Europa, das sich auf die Entwicklung von Kompressionsalgorithmen für KI -Modelle konzentriert. Kürzlich gab das Unternehmen bekannt, dass es seinen Optimierungsrahmen für die Komprimierung von Entwicklern und KI -Modellen effizienter eröffnen wird.

Das von Pruna AI entwickelte Rahmen kombiniert eine Vielzahl von Effizienzansätzen, einschließlich Caching, Beschneidung, Quantisierung und Destillation, um die Leistung von AI -Modellen zu verbessern. Dieser Framework standardisiert nicht nur die Speicherung und Belastung von Komprimierungsmodellen, sondern bewertet auch das komprimierte Modell, um festzustellen, ob seine Qualität bei der Messung der durch Komprimierung verursachten Leistungsverbesserungen erheblich gesunken ist.

"Unser Rahmen ähnelt der Standardisierung von Face durch die Standardisierung von Transformatoren und Diffusoren durch die Face, und wir bieten eine einheitliche Möglichkeit, verschiedene Effizienzmethoden anzurufen und anzuwenden", sagte John Rachwan, Mitbegründer und Chief Technology Officer von Pruna AI. Große Unternehmen wie OpenAI haben in ihren Modellen mehrere Komprimierungsmethoden angewendet, z. B. die Verwendung von Destillation, um schnellere Versionen ihrer Flaggschiff -Modelle zu erstellen.

Destillation ist eine Technologie, die Wissen über das Modell "Lehrer-Schüler" extrahiert, in dem Entwickler Anfragen an das Lehrermodell und die Aufzeichnungsausgabe senden. Diese Ausgaben werden dann verwendet, um das Schülermodell zu schulen, um das Verhalten des Lehrermodells zu approximieren. Lahwan merkt an, dass in der Open -Source -Community viele große Unternehmen dazu neigen, Komprimierungstools selbst aufzubauen, in der Open -Source -Community, die auf einer einzigen Methode basieren, häufig nur zu finden sind, und Pruna AI bietet ein Tool, das mehrere Methoden integriert und den Nutzungsprozess erheblich vereinfacht.

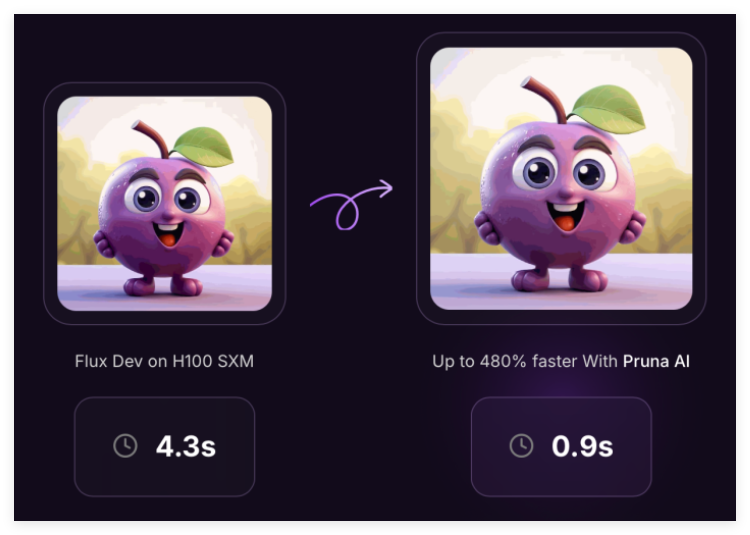

Derzeit unterstützt das Rahmen von Pruna AI eine Vielzahl von Modellen, darunter große Sprachmodelle, Diffusionsmodelle, Spracherkennungsmodelle und Computer -Vision -Modelle. Das Unternehmen konzentriert sich derzeit jedoch auf die Optimierung von Bild- und Videogenerierungsmodellen. Unternehmen wie Szenario und Fotoroom haben bereits Pruna AI -Dienste genutzt.

Zusätzlich zur Open -Source -Version hat Pruna AI auch eine Enterprise -Version gestartet, die erweiterte Optimierungsfunktionen und einen Optimierungsagenten enthält. "Die aufregendste Funktion, die wir veröffentlichen, ist der Komprimierungsagent, bei dem Benutzer das Modell nur bereitstellen und die Geschwindigkeits- und Genauigkeitsanforderungen festlegen müssen. Der Agent findet automatisch die beste Komprimierungskombination."

Pruna AI erhebt eine stündliche Gebühr, ähnlich wie die Nutzer GPUs für Cloud -Dienste mieten. Durch die Verwendung optimierter Modelle können Unternehmen beim Argumentieren viel Geld sparen. Zum Beispiel reduzierte Pruna AI die Größe eines Lama -Modells erfolgreich um achtmal mit geringer Genauigkeitsverlust. Das Unternehmen hofft, dass Kunden seinen Komprimierungsrahmen als eine Investition betrachten können, die letztendlich Renditen erzielt.

Kürzlich hat Pruna AI eine Saatgutfinanzierung von 6,5 Millionen US -Dollar mit Investoren wie EQT Ventures, Daphni, Motier Ventures und Kima Ventures abgeschlossen.

Projekt: https://github.com/prunaai/pruna

Schlüsselpunkte:

Pruna AI startet ein Open -Source -Optimierungsframework, das mehrere Komprimierungsmethoden zur Verbesserung der Leistung von KI -Modellen kombiniert.

Große Unternehmen verwenden häufig Destillation und andere Technologien, und Pruna AI bietet Tools, die mehrere Methoden zur Vereinfachung des Nutzungsprozesses integrieren.

Die Enterprise Edition unterstützt erweiterte Funktionen, mit denen Benutzer die Modellkomprimierung und die Leistungsverbesserungen erzielen und gleichzeitig die Genauigkeit beibehalten können.