Waseda University의 일본 행사의 공동 감각 지식 그래프의 영어 및 중국어 번역의 예

영어로

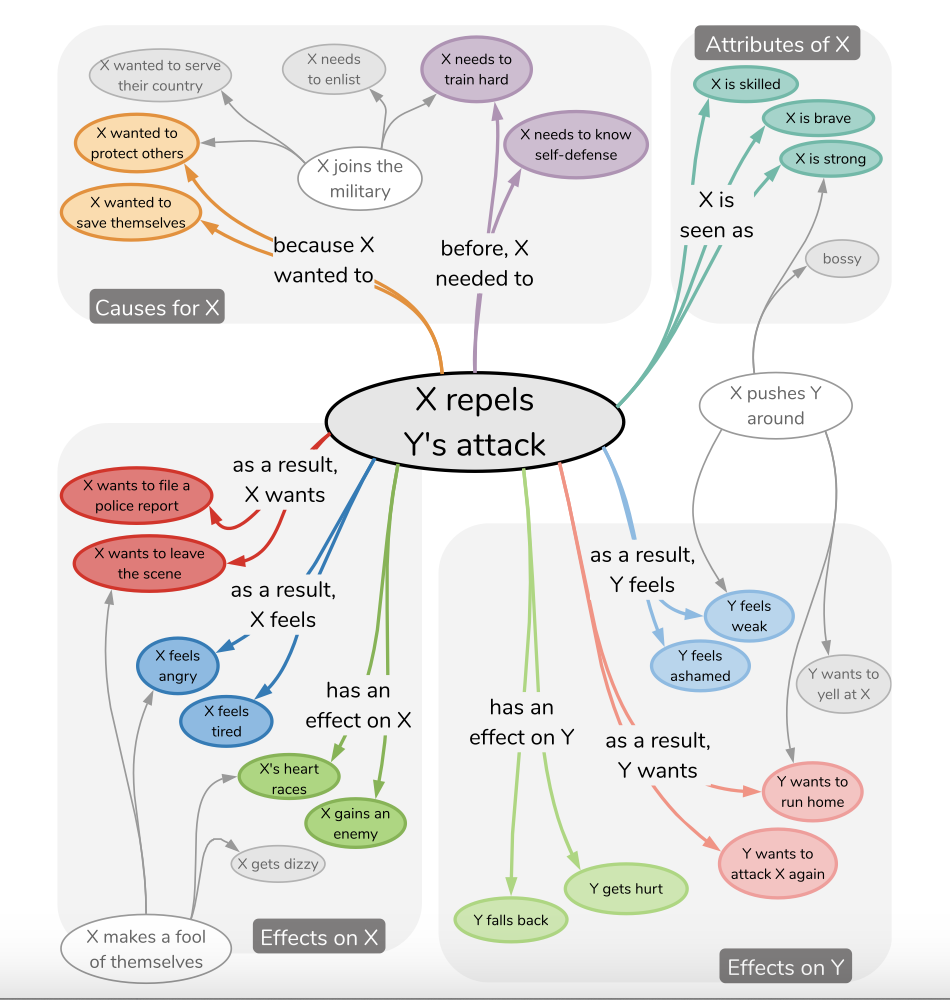

삶의 매일 상식 추론은 아래 그림과 같이 조밀 한 추론 지식 관계를 통해 얻을 수 있습니다.

Waseda University는 일본어로 데이터 세트 NLP-WASEDA/COMET-ATOMIC-JA를 태그 했으며이 모델이 이전에 보지 못한 사건에 대한 상식적 추론을 배울 수 있는지 여부를 연구했습니다. 그들은 각각 GPT2 및 T5 모델을 탐색했습니다. (이벤트 문구 e와 추론 치수 C가 주어지면, 모델은 대상 t = fθ (e, c)를 생성합니다. 이것은 오늘날의 큐 학습 문제 모델링 방법을 사용하여 쉽게 달성 할 수 있습니다.

이 프로젝트의 초점은 코퍼스를 영어와 중국어로 번역하고 T5 스타일 모델을 훈련하여 영어와 중국어의 그러한 문제를 다루는 신속한 학습의 적응성을 확인하는 것입니다.

JSON 구조 예

{ 'event': {'event': 'Xがパチンコ屋へ行く', 'mental_state': 'Xがパチンコ屋へ行く' },

'inference': {'event': {'before': ['Xが小遣いをもらう',

'Xがパチンコで勝つ',

'Xが金を用意する',

'Xがギャンブル依存症だと自覚する',

'Xが車を運転する',

'Xが金を稼ぐ',

'Xが金を持っている',

'Xが時間的余裕を持つ'],

'after': ['Xが負ける']},

'mental_state': {'before': ['時間をつぶしたい',

'ギャンブルがしたい',

'何か面白いことないかな',

'時間つぶしだ',

'暇だ',

'お金が欲しい',

'お金を儲ける',

'ストレス発散したい'],

'after': ['お金を失う',

'お金がなくなった',

'お金をたくさん使う',

'もう少ししたら帰る',

'お金が減る',

'また負けた',

'当たりそうだ',

'勝ったら嬉しい',

'負けて帰ってくる',

'お金がなくなる']}}} JSON 구조 예

{ 'en_event': {'event': 'X is going to the pachinko parlor',

'mental_state': 'X is going to the pachinko parlor' },

'en_inference': {'event': {'before': ['X gets an allowance',

'X wins at pachinko.',

'X gets the money.',

'Realize X has a gambling problem',

'X drives a car',

'X makes money',

'X has money',

'X has time to spare'],

'after': ['X will lose']},

'mental_state': {'before': ['X wants to kill time',

'X wants to gamble',

'I need something fun to do',

'X is killing time',

" I'm not busy " ,

'I want money',

'Make some money',

'I want to relieve stress'],

'after': ['Lose money',

'Money is running out',

'Spend a lot of money',

" I'll be home in a little while " ,

'X will have less money',

'I lost again.',

" I think I'm going to win. " ,

" I'll be happy if I win " ,

'X comes home defeated',

'X runs out of money']}}} JSON 구조 예

{ 'zh_event': {'event': 'X要去柏青哥店。', 'mental_state': 'X要去柏青哥店。' },

'zh_inference': {'event': {'before': ['X得到一笔津贴',

'X在弹子机上赢了。',

'X拿到钱',

'X意识到自己有赌博问题',

'X驾驶汽车',

'X 挣钱',

'X有钱了',

'X有时间'],

'after': ['X输了一场比赛']},

'mental_state': {'before': ['X想打发时间',

'X想赌博',

'我需要一些有趣的事情来做',

'X在打发时间',

'我不忙。',

'我想要钱',

'赚点钱',

'我想缓解压力'],

'after': ['失去了金钱。',

'我已经没有钱了',

'我花了很多钱',

'我一会儿就回家了',

'X有更少的钱',

'我又输了。',

'我想我要赢了。',

'如果我赢了,我会很高兴。',

'X败兴而归',

'X钱用完了']}}} 나는 내가 만든 그래프에서 영어와 중국어 (PEFT의 도움말)로 T5 기반 및 LORA 기반 모델을 미세 조정했습니다.

LORA에 대한 자세한 정보 및 예는 LORA 기반 Controlnet을 통해 이미지 출력을 제어하기위한 안정적인 확산 모델 도메인의 LORA 기반 Controlnet 애플리케이션 인 https://github.com/svjack/controllora-chinese에서 볼 수 있습니다.

pip install -r requirements.txtHuggingface에서 사용할 수있는 모델 :

| 이름 | 포옹 페이스 모델 링크 | 포옹 페이스 공간 링크 |

|---|---|---|

| 영어 혜성 원자? | https://huggingface.co/svjack/comet-atomic-en | https://huggingface.co/spaces/svjack/english-comet-atomic |

| 중국 혜성 원자 | https://huggingface.co/svjack/comet-atomic-zh | https://huggingface.co/spaces/svjack/chinese-comet-atomic |

| 중국 혜성 원자 T5 Lora | https://huggingface.co/svjack/mt0-large-comet-atomic-zh-peft-early-cpu | https://huggingface.co/spaces/svjack/chinese-comet-atomic-large-lora |

온라인 또는 모델 카드를 기반으로 사용할 수 있습니다.

svjack- [email protected] [email protected]

프로젝트 링크 : https : //github.com/svjack/comet-atomic-en-zh