Exemples de traduction en anglais et chinois des graphiques de connaissances de bon sens de l'événement japonais de l'Université Waseda

En anglais

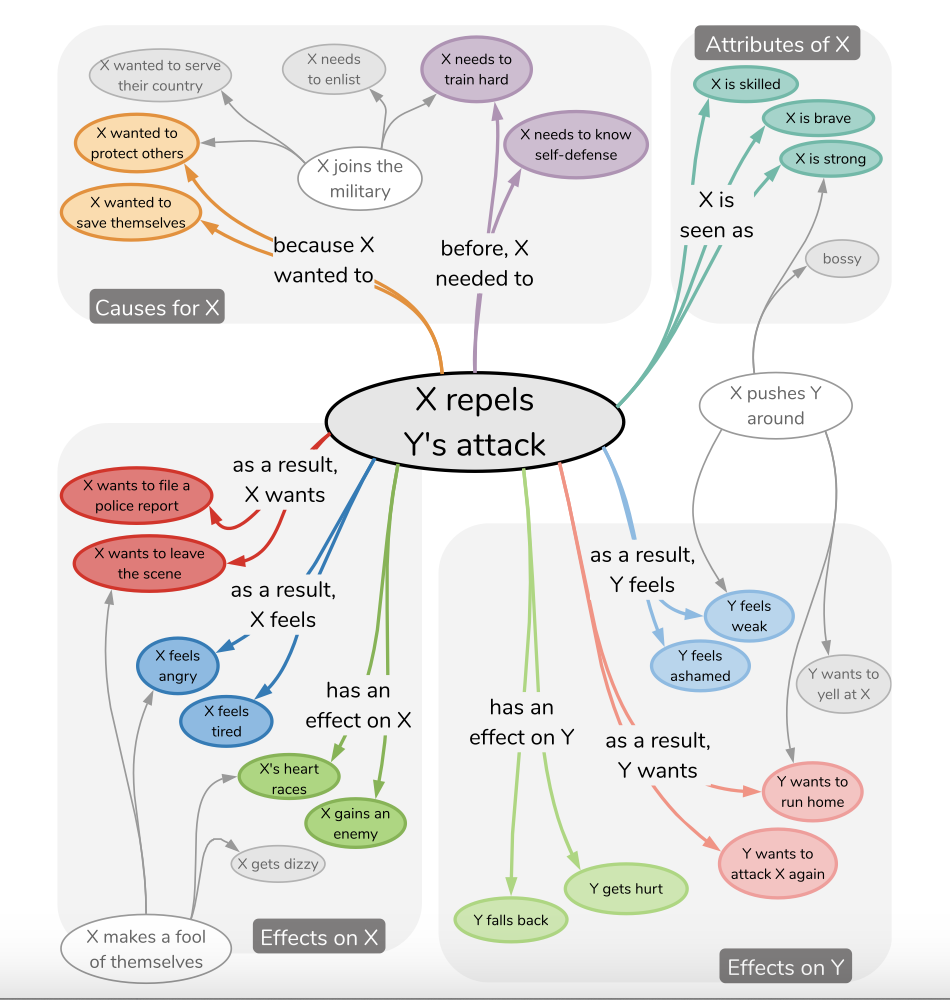

Le raisonnement quotidien de bon sens dans la vie peut être obtenu grâce à certaines relations de connaissances dense en matière de connaissances, comme le montre la figure ci-dessous:

L'Université Waseda a marqué un ensemble de données NLP-Waseda / Comet-atomic-ja en japonais et a étudié si le modèle pouvait apprendre si-alors le bon sens des événements qui n'avaient pas été vus auparavant. Ils ont exploré respectivement les modèles GPT2 et T5. (Compte tenu de la phrase d'événement E et de la dimension d'inférence C, le modèle génère la cible t = fθ (e, c).) Cela peut être facilement réalisé à l'aide des méthodes de modélisation des problèmes d'apprentissage d'aujourd'hui.

L'objectif de ce projet est de traduire leur corpus en anglais et en chinois, et à former le modèle de style T5 pour vérifier l'adaptabilité de l'apprentissage rapide à faire face à de tels problèmes en anglais et en chinois.

Exemple de structure JSON

{ 'event': {'event': 'Xがパチンコ屋へ行く', 'mental_state': 'Xがパチンコ屋へ行く' },

'inference': {'event': {'before': ['Xが小遣いをもらう',

'Xがパチンコで勝つ',

'Xが金を用意する',

'Xがギャンブル依存症だと自覚する',

'Xが車を運転する',

'Xが金を稼ぐ',

'Xが金を持っている',

'Xが時間的余裕を持つ'],

'after': ['Xが負ける']},

'mental_state': {'before': ['時間をつぶしたい',

'ギャンブルがしたい',

'何か面白いことないかな',

'時間つぶしだ',

'暇だ',

'お金が欲しい',

'お金を儲ける',

'ストレス発散したい'],

'after': ['お金を失う',

'お金がなくなった',

'お金をたくさん使う',

'もう少ししたら帰る',

'お金が減る',

'また負けた',

'当たりそうだ',

'勝ったら嬉しい',

'負けて帰ってくる',

'お金がなくなる']}}} Exemple de structure JSON

{ 'en_event': {'event': 'X is going to the pachinko parlor',

'mental_state': 'X is going to the pachinko parlor' },

'en_inference': {'event': {'before': ['X gets an allowance',

'X wins at pachinko.',

'X gets the money.',

'Realize X has a gambling problem',

'X drives a car',

'X makes money',

'X has money',

'X has time to spare'],

'after': ['X will lose']},

'mental_state': {'before': ['X wants to kill time',

'X wants to gamble',

'I need something fun to do',

'X is killing time',

" I'm not busy " ,

'I want money',

'Make some money',

'I want to relieve stress'],

'after': ['Lose money',

'Money is running out',

'Spend a lot of money',

" I'll be home in a little while " ,

'X will have less money',

'I lost again.',

" I think I'm going to win. " ,

" I'll be happy if I win " ,

'X comes home defeated',

'X runs out of money']}}} Exemple de structure JSON

{ 'zh_event': {'event': 'X要去柏青哥店。', 'mental_state': 'X要去柏青哥店。' },

'zh_inference': {'event': {'before': ['X得到一笔津贴',

'X在弹子机上赢了。',

'X拿到钱',

'X意识到自己有赌博问题',

'X驾驶汽车',

'X 挣钱',

'X有钱了',

'X有时间'],

'after': ['X输了一场比赛']},

'mental_state': {'before': ['X想打发时间',

'X想赌博',

'我需要一些有趣的事情来做',

'X在打发时间',

'我不忙。',

'我想要钱',

'赚点钱',

'我想缓解压力'],

'after': ['失去了金钱。',

'我已经没有钱了',

'我花了很多钱',

'我一会儿就回家了',

'X有更少的钱',

'我又输了。',

'我想我要赢了。',

'如果我赢了,我会很高兴。',

'X败兴而归',

'X钱用完了']}}} J'ai affiné les modèles basés sur T5 et basés sur LORA en anglais et chinois (avec l'aide de PEFT) sur le graphique que j'ai construit.

Plus d'informations et des exemples sur LORA peuvent être consultés dans https://github.com/svjack/controllora-chinois, une application ControlNet basée sur LORA dans le domaine du modèle de diffusion stable pour contrôler la sortie de l'image via ControlNet basé sur LORA.

pip install -r requirements.txtModèles disponibles dans HuggingFace:

| Nom | Lien de modèle HuggingFace | Lien d'espace étreint |

|---|---|---|

| Comète anglaise atomique? | https://huggingface.co/svjack/comet-atomic-en | https://huggingface.co/spaces/svjack/english-comet-atomic |

| Comète chinoise atomique | https://huggingface.co/svjack/comet-atomic-zh | https://huggingface.co/spaces/svjack/chinese-comet-atomic |

| Comète chinoise atomique t5 lora | https://huggingface.co/svjack/mt0-large-comet-atomic-zh-peft-early-cpu | https://huggingface.co/spaces/svjack/chinese-comet-atomic-t5-large-lora |

Vous pouvez l'utiliser en ligne ou en fonction des cartes modèles.

svjack - [email protected] - [email protected]

Lien du projet: https: //github.com/svjack/comet-atomic-en-zh