Beispiele für englische und chinesische Übersetzung von Wissensgrafiken des gesunden Menschenverstands der japanischen Veranstaltung der Waseda University

Auf Englisch

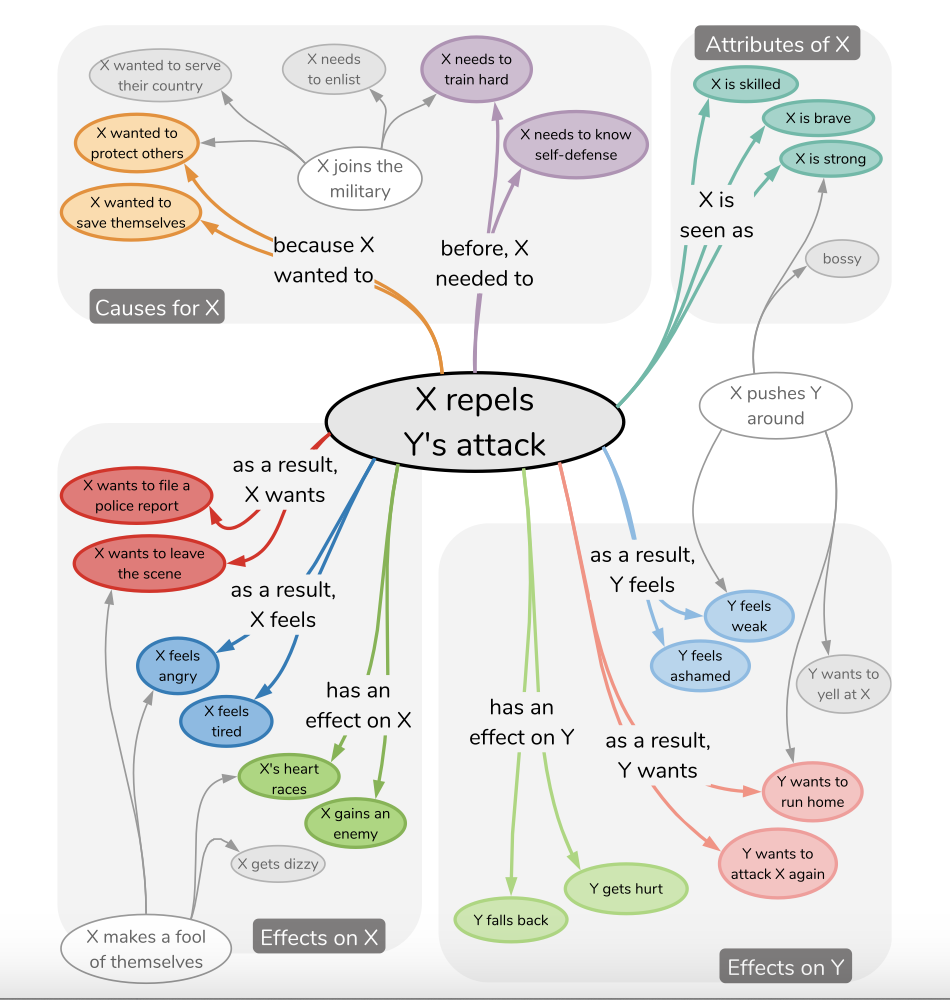

Das tägliche Argumentieren im Leben im Leben kann durch einige dichte Inferenzwissenbeziehungen erhalten werden, wie in der folgenden Abbildung gezeigt:

Die Waseda-Universität markierte auf Japanisch ein Datensatz von NLP-Waseda/Comet-Atomic-Ja und untersuchte, ob das Modell lernen könnte, ob es sich um einen gesunden Menschenverstand lernte, dass Ereignisse, die zuvor noch nicht gesehen wurden,. Sie untersuchten die GPT2- bzw. T5 -Modelle. (Angesichts der Ereignisphrase E und der Inferenzdimension C erzeugt das Modell das Ziel T = Fθ (e, c).) Dies kann mit Hilfe der heutigen Modellierungsmethoden für Cue -Lernprobleme leicht erreicht werden.

Der Schwerpunkt dieses Projekts liegt auf der Übersetzung ihres Korpus in Englisch und Chinesisch und trainiert das T5 -Modell, um die Anpassungsfähigkeit des sofortigen Lernens zu überprüfen, um solche Probleme in Englisch und Chinesisch zu bewältigen.

Beispiel für JSON -Struktur

{ 'event': {'event': 'Xがパチンコ屋へ行く', 'mental_state': 'Xがパチンコ屋へ行く' },

'inference': {'event': {'before': ['Xが小遣いをもらう',

'Xがパチンコで勝つ',

'Xが金を用意する',

'Xがギャンブル依存症だと自覚する',

'Xが車を運転する',

'Xが金を稼ぐ',

'Xが金を持っている',

'Xが時間的余裕を持つ'],

'after': ['Xが負ける']},

'mental_state': {'before': ['時間をつぶしたい',

'ギャンブルがしたい',

'何か面白いことないかな',

'時間つぶしだ',

'暇だ',

'お金が欲しい',

'お金を儲ける',

'ストレス発散したい'],

'after': ['お金を失う',

'お金がなくなった',

'お金をたくさん使う',

'もう少ししたら帰る',

'お金が減る',

'また負けた',

'当たりそうだ',

'勝ったら嬉しい',

'負けて帰ってくる',

'お金がなくなる']}}} Beispiel für JSON -Struktur

{ 'en_event': {'event': 'X is going to the pachinko parlor',

'mental_state': 'X is going to the pachinko parlor' },

'en_inference': {'event': {'before': ['X gets an allowance',

'X wins at pachinko.',

'X gets the money.',

'Realize X has a gambling problem',

'X drives a car',

'X makes money',

'X has money',

'X has time to spare'],

'after': ['X will lose']},

'mental_state': {'before': ['X wants to kill time',

'X wants to gamble',

'I need something fun to do',

'X is killing time',

" I'm not busy " ,

'I want money',

'Make some money',

'I want to relieve stress'],

'after': ['Lose money',

'Money is running out',

'Spend a lot of money',

" I'll be home in a little while " ,

'X will have less money',

'I lost again.',

" I think I'm going to win. " ,

" I'll be happy if I win " ,

'X comes home defeated',

'X runs out of money']}}} Beispiel für JSON -Struktur

{ 'zh_event': {'event': 'X要去柏青哥店。', 'mental_state': 'X要去柏青哥店。' },

'zh_inference': {'event': {'before': ['X得到一笔津贴',

'X在弹子机上赢了。',

'X拿到钱',

'X意识到自己有赌博问题',

'X驾驶汽车',

'X 挣钱',

'X有钱了',

'X有时间'],

'after': ['X输了一场比赛']},

'mental_state': {'before': ['X想打发时间',

'X想赌博',

'我需要一些有趣的事情来做',

'X在打发时间',

'我不忙。',

'我想要钱',

'赚点钱',

'我想缓解压力'],

'after': ['失去了金钱。',

'我已经没有钱了',

'我花了很多钱',

'我一会儿就回家了',

'X有更少的钱',

'我又输了。',

'我想我要赢了。',

'如果我赢了,我会很高兴。',

'X败兴而归',

'X钱用完了']}}} Ich habe in dem von mir erstellten Diagramm fein abgestimmte T5-basierte und lora-basierte Modelle in Englisch und Chinesisch (mit Hilfe von PEFT).

Weitere Informationen und Beispiele zu LORA können unter https://github.com/svjack/controllora-chinese, einer LORA-basierten ControlNET-Anwendung in der stabilen Diffusionsmodell-Domäne zur Steuerung der Bildausgabe über LORA-basiertes ControlNet, betrachtet werden.

pip install -r requirements.txtModelle in Suggingface erhältlich:

| Name | Umarmungsface -Modelllink | Umarmungspace -Space -Link |

|---|---|---|

| Englischer Kometatomic? | https://huggingface.co/svjack/comet-atomic-en | https://huggingface.co/spaces/svjack/english-comet-atomic |

| Chinesische Kometatomic | https://huggingface.co/svjack/comet-atomic-zh | https://huggingface.co/spaces/svjack/chinese-comet-atomic |

| Chinesischer Komet Atomic T5 Lora | https://huggingface.co/svjack/mt0-large-comet-atomic-zh-peft-early-cpu | https://huggingface.co/spaces/svjack/chinese-comet-atomic-t5-large-lora |

Sie können es online oder basierend auf Modellkarten verwenden.

svjack - [email protected] - [email protected]

Projektlink: https: //github.com/svjack/comet-atomic-en-zh