常識の英語と中国語の翻訳の例は、連邦大学の日本のイベントのグラフのグラフ

英語で

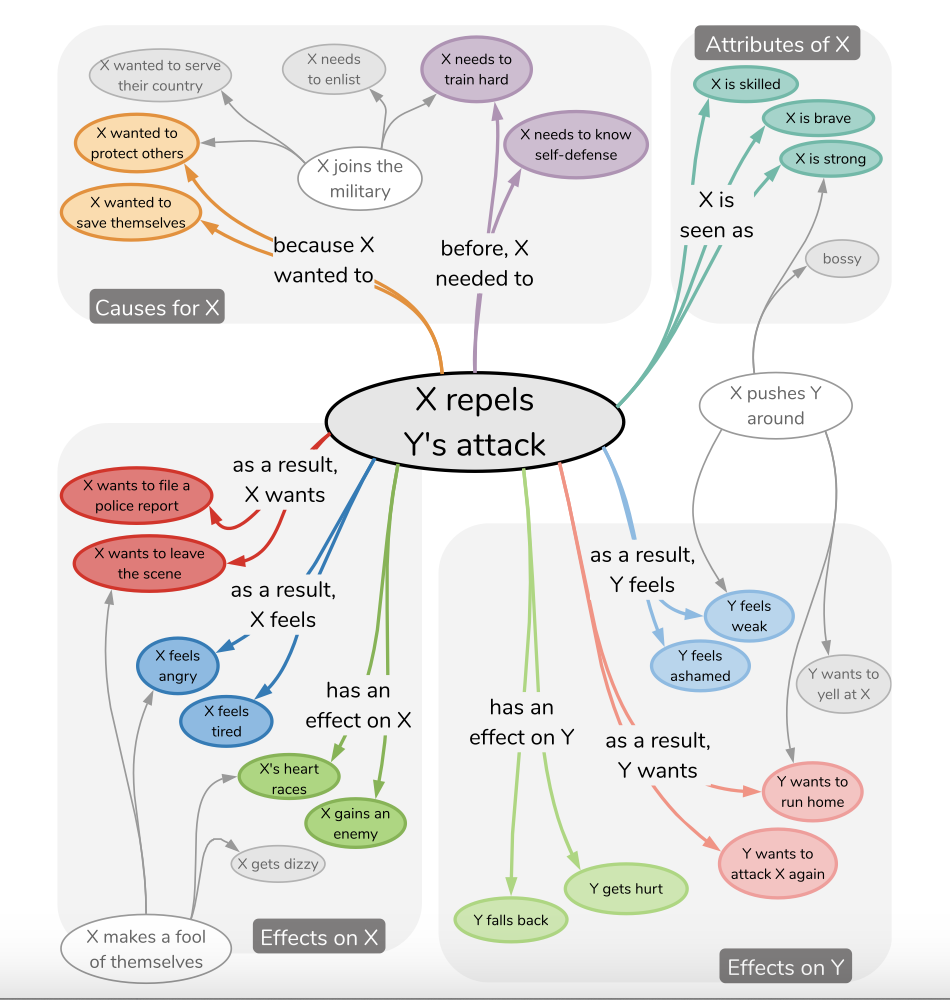

以下の図に示すように、人生における毎日の常識推論は、いくつかの密な推論知識関係を通じて得ることができます。

Waseda Universityは、日本語でデータセットNLP-Waseda/Comet-Atomic-Jaにタグを付け、モデルが以前に見られなかったイベントの常識推論を学習できるかどうかを研究しました。彼らはそれぞれGPT2およびT5モデルを調査しました。 (イベントフレーズEおよび推論ディメンションCを考えると、モデルはターゲットt =fθ(e、c)を生成します。)これは、今日のキュー学習問題モデリング方法の助けを借りて簡単に実現できます。

このプロジェクトの焦点は、コーパスを英語と中国語に変換し、T5スタイルモデルを訓練して、英語と中国語でそのような問題に対処するための迅速な学習の適応性を確認することです。

JSON構造の例

{ 'event': {'event': 'Xがパチンコ屋へ行く', 'mental_state': 'Xがパチンコ屋へ行く' },

'inference': {'event': {'before': ['Xが小遣いをもらう',

'Xがパチンコで勝つ',

'Xが金を用意する',

'Xがギャンブル依存症だと自覚する',

'Xが車を運転する',

'Xが金を稼ぐ',

'Xが金を持っている',

'Xが時間的余裕を持つ'],

'after': ['Xが負ける']},

'mental_state': {'before': ['時間をつぶしたい',

'ギャンブルがしたい',

'何か面白いことないかな',

'時間つぶしだ',

'暇だ',

'お金が欲しい',

'お金を儲ける',

'ストレス発散したい'],

'after': ['お金を失う',

'お金がなくなった',

'お金をたくさん使う',

'もう少ししたら帰る',

'お金が減る',

'また負けた',

'当たりそうだ',

'勝ったら嬉しい',

'負けて帰ってくる',

'お金がなくなる']}}} JSON構造の例

{ 'en_event': {'event': 'X is going to the pachinko parlor',

'mental_state': 'X is going to the pachinko parlor' },

'en_inference': {'event': {'before': ['X gets an allowance',

'X wins at pachinko.',

'X gets the money.',

'Realize X has a gambling problem',

'X drives a car',

'X makes money',

'X has money',

'X has time to spare'],

'after': ['X will lose']},

'mental_state': {'before': ['X wants to kill time',

'X wants to gamble',

'I need something fun to do',

'X is killing time',

" I'm not busy " ,

'I want money',

'Make some money',

'I want to relieve stress'],

'after': ['Lose money',

'Money is running out',

'Spend a lot of money',

" I'll be home in a little while " ,

'X will have less money',

'I lost again.',

" I think I'm going to win. " ,

" I'll be happy if I win " ,

'X comes home defeated',

'X runs out of money']}}} JSON構造の例

{ 'zh_event': {'event': 'X要去柏青哥店。', 'mental_state': 'X要去柏青哥店。' },

'zh_inference': {'event': {'before': ['X得到一笔津贴',

'X在弹子机上赢了。',

'X拿到钱',

'X意识到自己有赌博问题',

'X驾驶汽车',

'X 挣钱',

'X有钱了',

'X有时间'],

'after': ['X输了一场比赛']},

'mental_state': {'before': ['X想打发时间',

'X想赌博',

'我需要一些有趣的事情来做',

'X在打发时间',

'我不忙。',

'我想要钱',

'赚点钱',

'我想缓解压力'],

'after': ['失去了金钱。',

'我已经没有钱了',

'我花了很多钱',

'我一会儿就回家了',

'X有更少的钱',

'我又输了。',

'我想我要赢了。',

'如果我赢了,我会很高兴。',

'X败兴而归',

'X钱用完了']}}}私は、私が構築したグラフの英語と中国語(PEFTの助けを借りて)のT5ベースとロラベースのモデルを微調整しました。

LORAに関する詳細情報と例は、https://github.com/svjack/controllorora-chineseで見ることができます。これは、LORAベースのコントロールネットを介した画像出力を制御するための安定した拡散モデルドメインのロラベースのコントロールネットアプリケーションです。

pip install -r requirements.txtHuggingfaceで利用可能なモデル:

| 名前 | ハギングフェイスモデルリンク | ハギングフェイススペースリンク |

|---|---|---|

| 英語彗星アトミック? | https://huggingface.co/svjack/comet-atomic-en | https://huggingface.co/spaces/svjack/english-comet-atomic |

| 中国の彗星原子 | https://huggingface.co/svjack/comet-atomic-zh | https://huggingface.co/spaces/svjack/chinese-comet-atomic |

| 中国の彗星アトミックT5ロラ | https://huggingface.co/svjack/mt0-large-comet-atomic-zh-peft-early-cpu | https://huggingface.co/spaces/svjack/chinese-comet-atomic-t5-large-lora |

オンラインまたはモデルカードに基づいて使用できます。

svjack [email protected] [email protected]

プロジェクトリンク:https://github.com/svjack/comet-atomic-en-zh