L'Université de Hong Kong et ByteDance ont lancé conjointement LlamaGen, une technologie innovante qui applique le paradigme de prédiction des modèles de langage à grande échelle au domaine de la génération d'images et qui a obtenu des résultats remarquables. En repensant le segmenteur d'images et en entraînant le modèle à grande échelle, LlamaGen atteint des performances de génération d'images de pointe sans avoir recours à un biais d'induction de signal visuel, apportant ainsi de nouvelles avancées dans le domaine de la génération d'images. Cette technologie fonctionne non seulement bien dans le benchmark ImageNet, mais démontre également d'excellentes capacités en matière de qualité d'image et d'alignement de texte, et permet une accélération significative grâce au cadre de service vllm. Les différents modèles et outils proposés fournissent des ressources précieuses aux développeurs et aux chercheurs.

Entrée du produit : https://top.aibase.com/tool/llamagen

LlamaGen est une innovation révolutionnaire par rapport aux modèles de génération d'images traditionnels, démontrant que les modèles autorégressifs ordinaires peuvent atteindre des performances de génération d'images de pointe même en l'absence de biais d'induction de signal visuel, à condition qu'ils soient correctement mis à l'échelle. L'autorégression LlamaGen est la sortie du Transformer et le jeton suivant est utilisé comme entrée pour prédire le prochain jeton. Il utilise l'architecture LLaMA et n'utilise pas le modèle de diffusion. Cette découverte apporte de nouvelles possibilités et inspirations dans le domaine de la génération d’images, et fournit de nouvelles idées et orientations pour les futures recherches sur la génération d’images.

Les fonctionnalités de LlamaGen incluent :

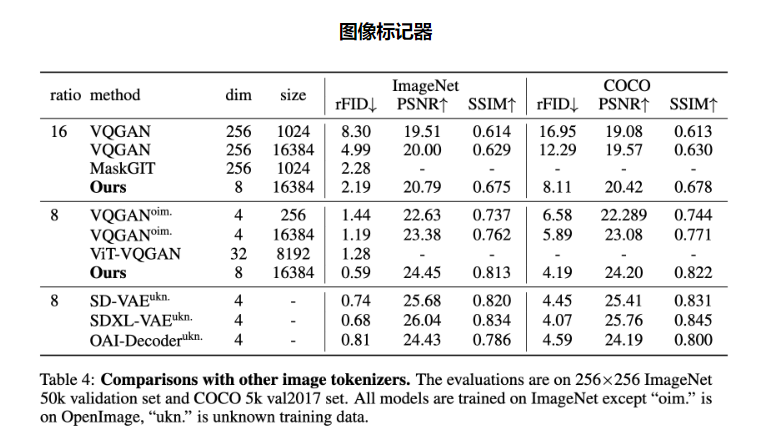

Tokenizer d'images : lancement d'un tokenizer d'images avec un taux de sous-échantillonnage de 16x, une qualité de reconstruction de 0,94 et une utilisation du livre de codes de 97 %, qui a obtenu de bons résultats sur le benchmark ImageNet.

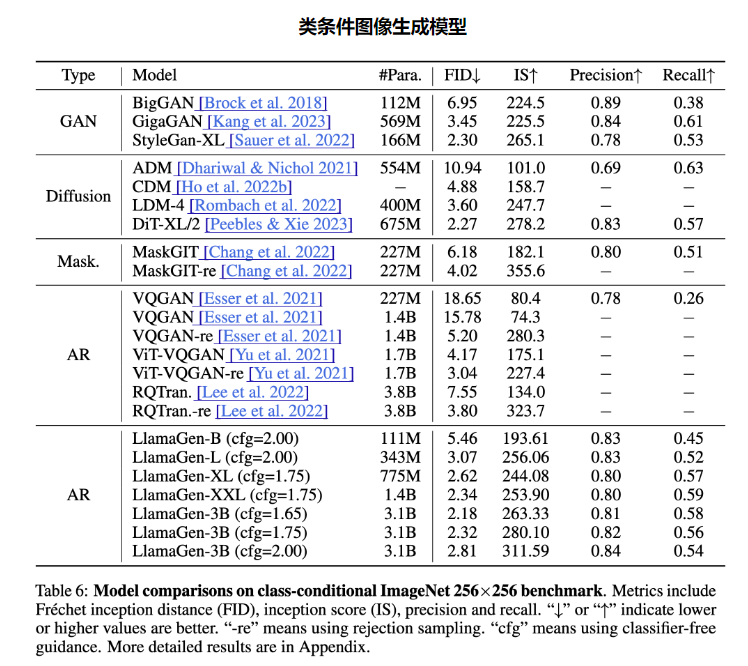

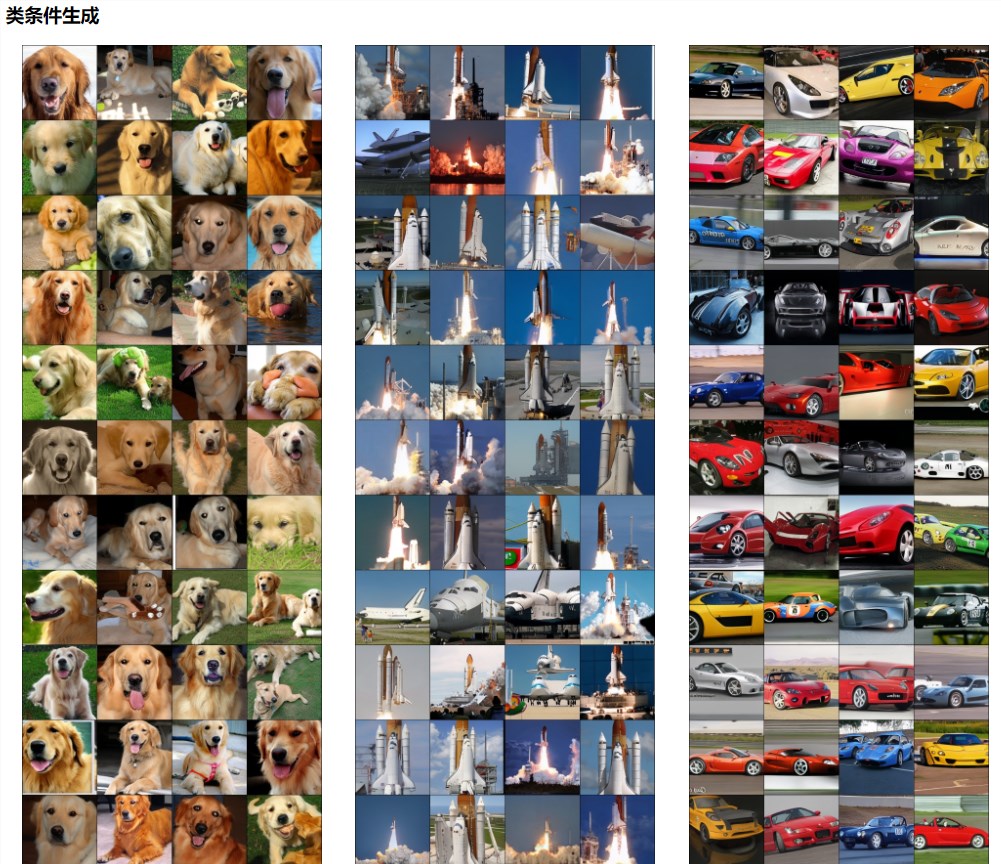

Modèle de génération d'images conditionnelles par catégorie : une série de modèles de génération d'images conditionnelles par catégorie avec des plages de paramètres allant de 111 M à 3,1 B ont été lancées, atteignant un FID de 2,18 sur le benchmark ImageNet256×256, dépassant le modèle de diffusion populaire.

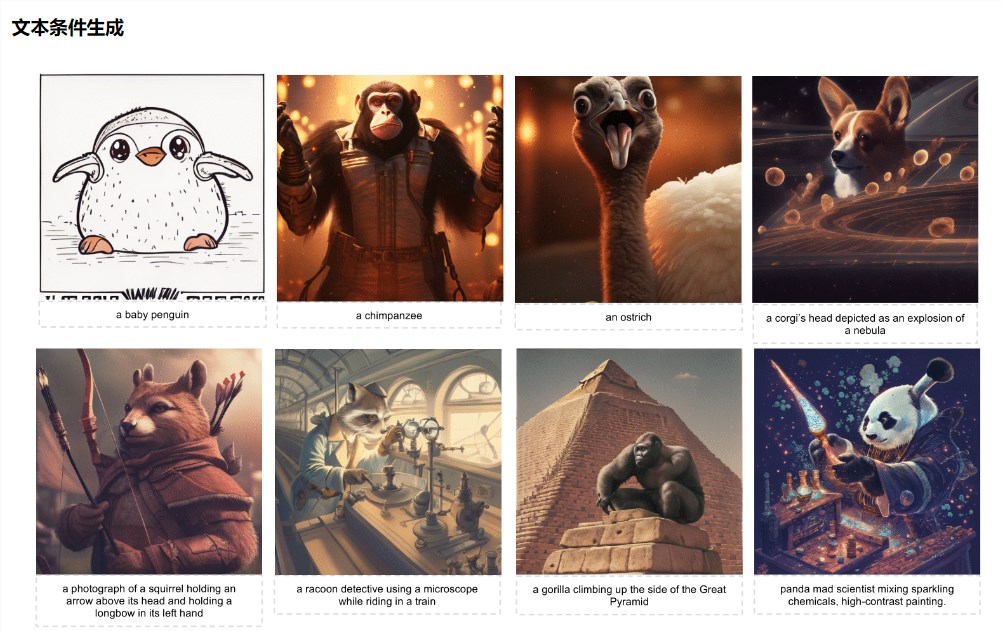

Modèle de génération d'images conditionnelles de texte : Un modèle de génération d'images conditionnelles de texte avec 775 millions de paramètres a été lancé après une formation en deux étapes par LAION-COCO, il peut générer des images esthétiques de haute qualité et démontrer une excellente qualité visuelle et des performances d'alignement de texte.

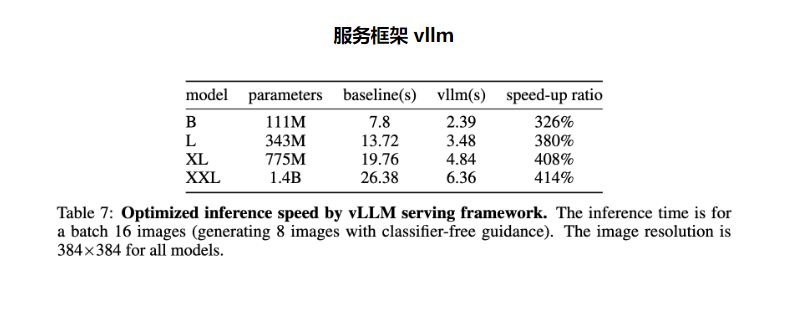

Service framework vllm : vérification de l'efficacité du cadre de service LLM pour optimiser la vitesse d'inférence du modèle de génération d'images, atteignant une accélération de 326 % à 414 %.

Dans ce projet, l'équipe de recherche a publié deux segmenteurs d'images, des modèles de génération conditionnelle à sept catégories et deux modèles de génération conditionnelle de texte, tout en fournissant des démonstrations en ligne et un cadre de service à haut débit. La publication de ces modèles et outils offre aux développeurs et aux chercheurs une multitude de ressources et d'outils, leur permettant de mieux comprendre et appliquer la technologie LlamaGen.

L'émergence de LlamaGen favorise non seulement l'avancement de la technologie de génération d'images, mais fournit également de nouvelles orientations et idées pour les recherches futures dans le domaine de l'intelligence artificielle. Il vaut la peine d'attendre avec impatience son application et son développement dans davantage de domaines.