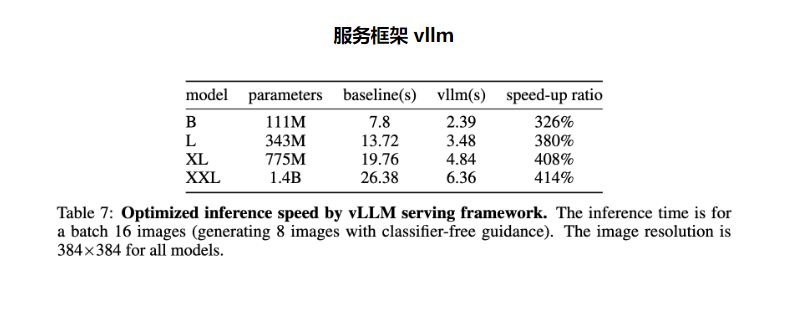

La Universidad de Hong Kong y ByteDance lanzaron conjuntamente LlamaGen, una tecnología innovadora que aplica el paradigma de predicción de modelos de lenguaje a gran escala al campo de la generación de imágenes y ha logrado resultados notables. Al rediseñar el segmentador de imágenes y entrenar el modelo a gran escala, LlamaGen logra un rendimiento líder en generación de imágenes sin la necesidad de sesgo de inducción de señales visuales, aportando nuevos avances en el campo de la generación de imágenes. Esta tecnología no solo funciona bien en el punto de referencia ImageNet, sino que también demuestra excelentes capacidades en calidad de imagen y alineación de texto, y logra una aceleración significativa a través del marco de servicio vllm. Los diversos modelos y herramientas que proporciona proporcionan recursos valiosos para desarrolladores e investigadores.

Entrada del producto: https://top.aibase.com/tool/llamagen

LlamaGen es una innovación disruptiva para los modelos tradicionales de generación de imágenes, lo que demuestra que los modelos autorregresivos ordinarios pueden lograr un rendimiento líder en generación de imágenes incluso en ausencia de sesgo de inducción de señales visuales, siempre que estén escalados adecuadamente. La autorregresión de LlamaGen es la salida del Transformador y el siguiente token se usa como entrada para predecir el siguiente token. Utiliza la arquitectura LLaMA y no utiliza el modelo de Difusión. Este descubrimiento aporta nuevas posibilidades e inspiraciones al campo de la generación de imágenes y proporciona nuevas ideas y direcciones para futuras investigaciones sobre generación de imágenes.

Las características de LlamaGen incluyen:

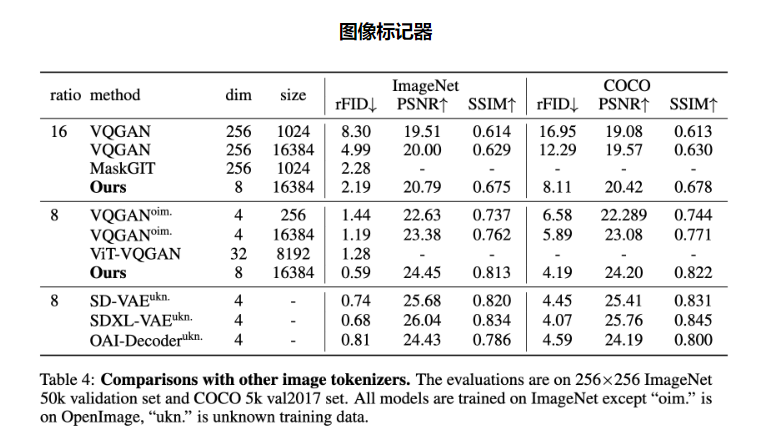

Tokenizador de imágenes: lanzó un tokenizador de imágenes con una relación de reducción de resolución de 16x, una calidad de reconstrucción de 0,94 y una utilización del libro de códigos del 97 %, que tuvo un buen desempeño en el punto de referencia ImageNet.

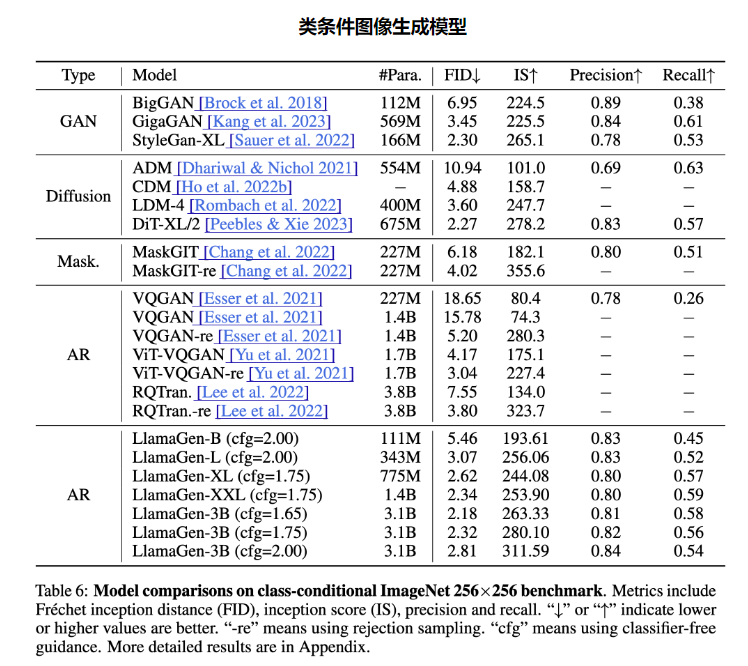

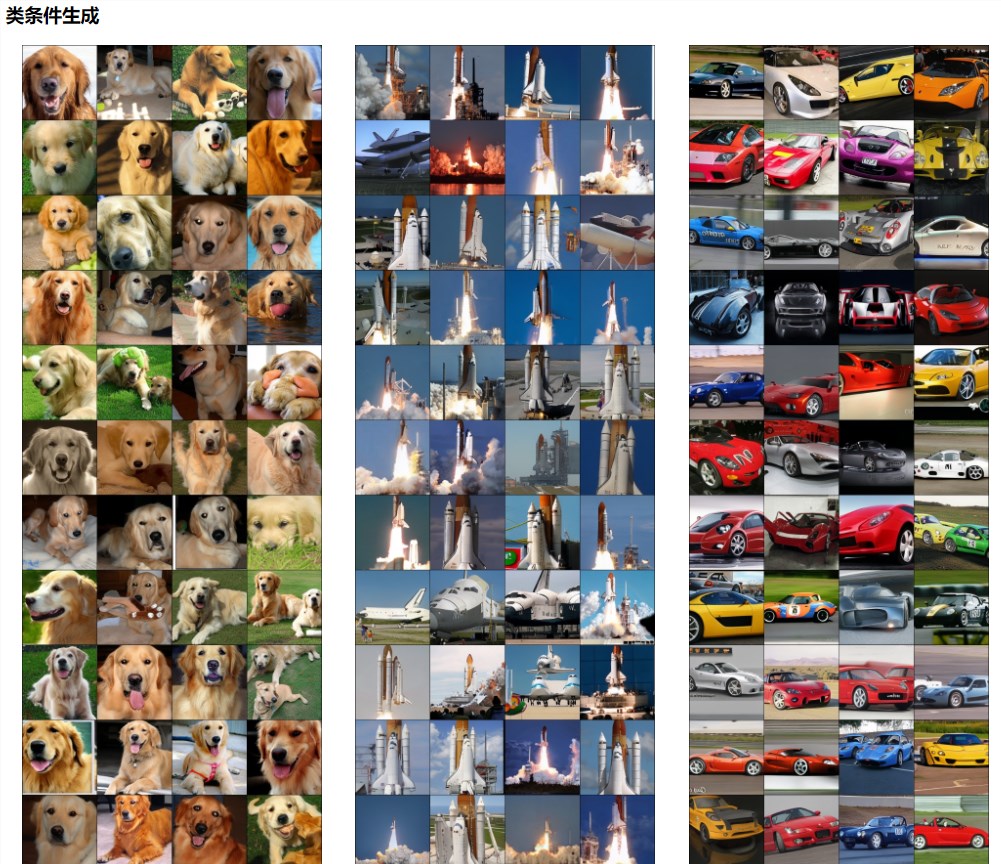

Modelo de generación de imágenes condicional por categoría: se lanzó una serie de modelos de generación de imágenes condicionales por categoría con rangos de parámetros de 111 M a 3,1 B, logrando un FID de 2,18 en el punto de referencia ImageNet256 × 256, superando el popular modelo de difusión.

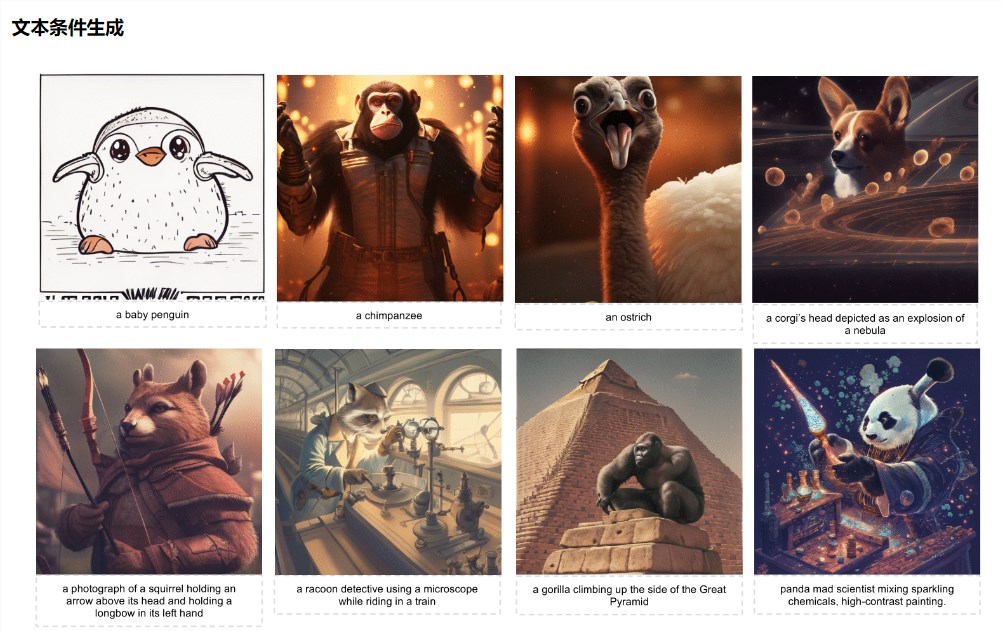

Modelo de generación de imágenes condicionales de texto: se lanzó un modelo de generación de imágenes condicionales de texto con parámetros de 775M después de un entrenamiento de dos etapas por parte de LAION-COCO, puede generar imágenes estéticas de alta calidad y demostrar una calidad visual y un rendimiento de alineación de texto excelentes.

Marco de servicio vllm: Verificó la efectividad del marco de servicio LLM en la optimización de la velocidad de inferencia del modelo de generación de imágenes, logrando una aceleración del 326% al 414%.

En este proyecto, el equipo de investigación lanzó dos segmentadores de imágenes, modelos de generación condicional de siete categorías y dos modelos de generación condicional de texto, al tiempo que proporcionó demostraciones en línea y un marco de servicio de alto rendimiento. El lanzamiento de estos modelos y herramientas proporciona a los desarrolladores e investigadores una gran cantidad de recursos y herramientas, permitiéndoles comprender y aplicar mejor la tecnología LlamaGen.

La aparición de LlamaGen no solo promueve el avance de la tecnología de generación de imágenes, sino que también proporciona nuevas direcciones e ideas para futuras investigaciones en el campo de la inteligencia artificial. Vale la pena esperar su aplicación y desarrollo en más campos.