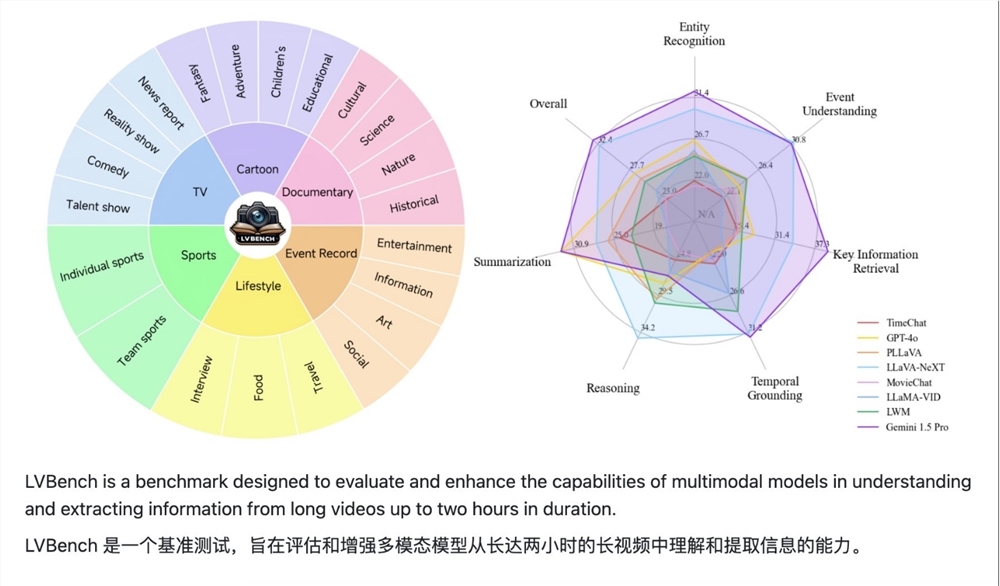

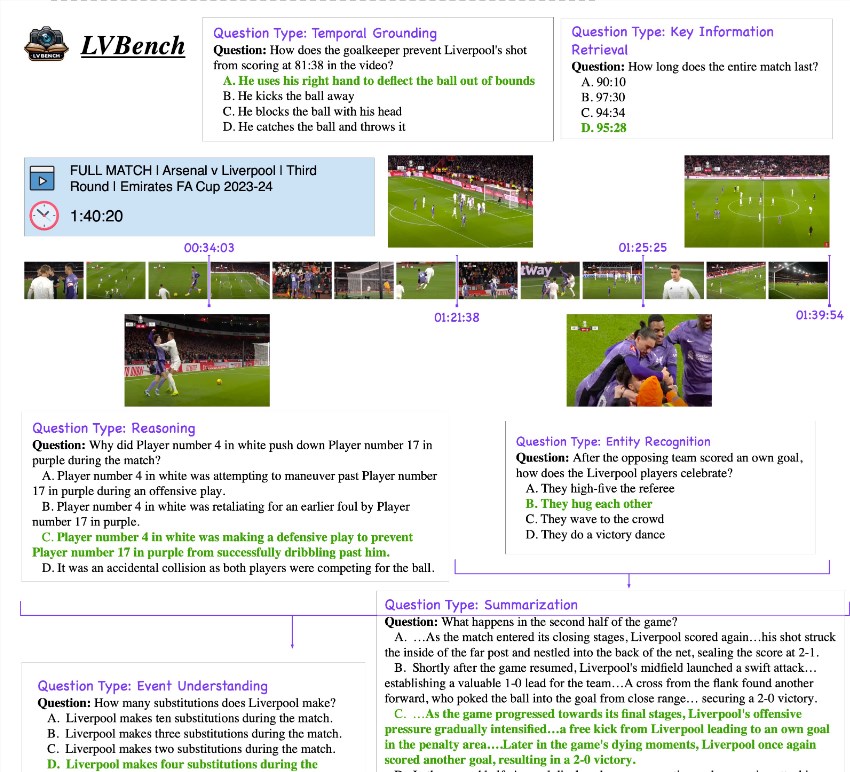

LVBench, un projet de référence sur la compréhension des vidéos longues lancé conjointement par Zhipu, l'Université Tsinghua et l'Université de Pékin, vise à résoudre les défis rencontrés par les grands modèles de langage multimodaux existants dans le traitement de longues vidéos. Le projet fournit plusieurs heures de données d'assurance qualité couvrant différents types de contenu vidéo tels que les séries télévisées, les émissions sportives et les vidéos de surveillance, et contient 6 catégories principales et 21 sous-catégories. Les données sont annotées de haute qualité et LLM est utilisé pour filtrer. problèmes difficiles, couvrant une variété de tâches telles que le résumé vidéo, la détection d'événements, la reconnaissance de personnages et la compréhension de scènes. Le lancement de LVBench favorisera les percées et les innovations dans la technologie de compréhension des vidéos longues, en fournissant un solide support pour des applications telles que la prise de décision intelligente incarnée, les critiques approfondies de films et de télévision et les commentaires sportifs professionnels.

Ce projet contient plusieurs heures de données d'assurance qualité dans 6 catégories principales et 21 sous-catégories, couvrant différents types de contenus vidéo tels que des séries télévisées, des retransmissions sportives et des images de surveillance quotidiennes provenant de sources publiques. Les données sont toutes annotées de haute qualité et LLM est utilisé pour filtrer les problèmes difficiles. Il est rapporté que l'ensemble de données LVBench couvre une variété de tâches telles que le résumé vidéo, la détection d'événements, la reconnaissance de personnages et la compréhension de scènes.

Le lancement du benchmark LVBench vise non seulement à tester les capacités de raisonnement et de fonctionnement du modèle dans de longs scénarios vidéo, mais favorise également les percées et les innovations dans les technologies connexes pour parvenir à une prise de décision intelligente et incarnée, à des critiques approfondies de films et de télévision et à des sports professionnels. les commentaires dans le domaine des vidéos longues. Les applications doivent donner un nouvel élan.

De nombreux instituts de recherche ont commencé à travailler sur l'ensemble de données LVBench, repoussant progressivement les limites de l'intelligence artificielle dans la compréhension des flux d'informations à long terme en créant de grands modèles pour les tâches vidéo longues et en injectant de nouvelles idées dans l'exploration continue de la compréhension vidéo, multimodale. l'apprentissage et d'autres domaines de vitalité.

github :https://github.com/THUDM/LVBench

Projet : https://lvbench.github.io

Article : https://arxiv.org/abs/2406.08035

Le lancement du projet LVBench marque une nouvelle étape dans le développement de la technologie de compréhension des vidéos longues. Les riches ensembles de données et les tâches difficiles qu'elle propose inciteront davantage de chercheurs à participer, accéléreront les progrès de l'intelligence artificielle dans le domaine de la compréhension des vidéos longues et. apporter des avantages aux applications futures. Plus de possibilités. Dans l’attente de plus de résultats de recherche basés sur LVBench à l’avenir.