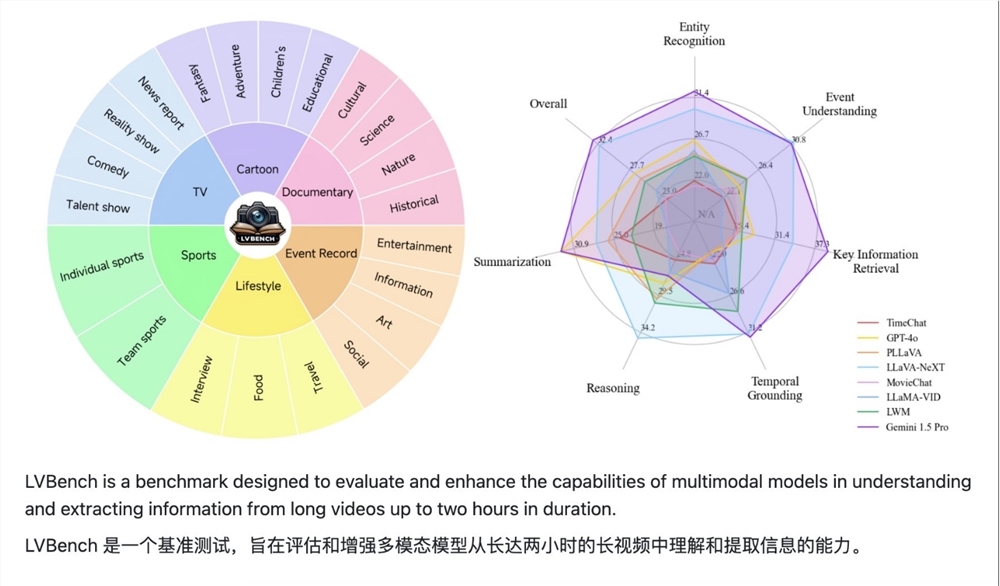

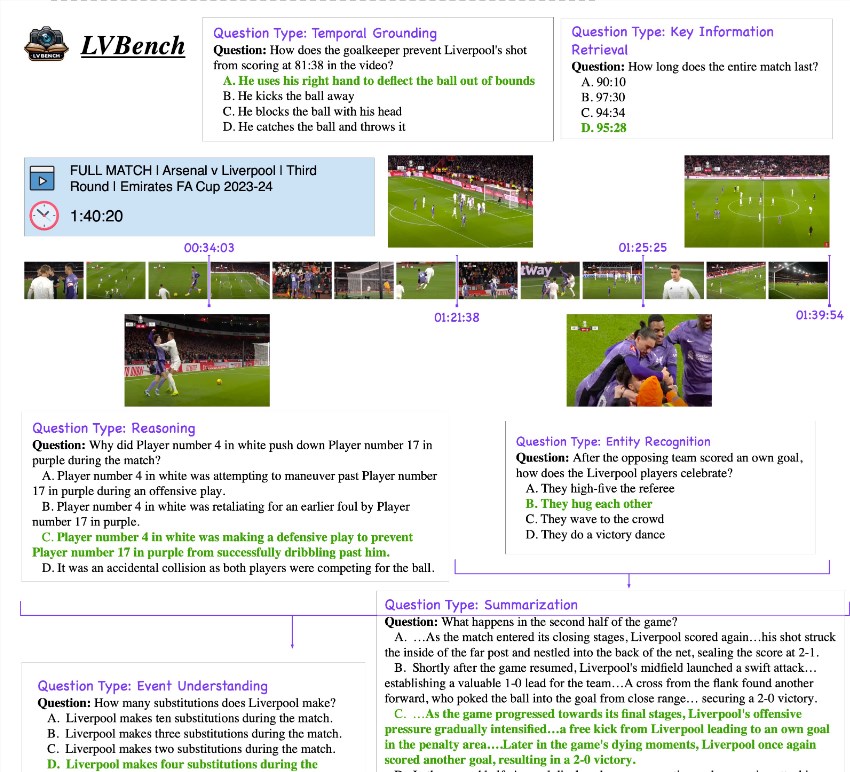

LVBench, un proyecto de referencia de comprensión de videos largos lanzado conjuntamente por Zhipu, la Universidad de Tsinghua y la Universidad de Pekín, tiene como objetivo resolver los desafíos que enfrentan los modelos de lenguajes grandes multimodales existentes en el procesamiento de videos largos. El proyecto proporciona varias horas de datos de control de calidad que cubren diferentes tipos de contenido de vídeo, como series de televisión, retransmisiones deportivas y vídeos de vigilancia, y contiene 6 categorías principales y 21 subcategorías. Los datos están anotados con alta calidad y se utiliza LLM para filtrar. problemas desafiantes, que cubren una variedad de tareas como resumen de video, detección de eventos, reconocimiento de personajes y comprensión de escenas. El lanzamiento de LVBench promoverá avances e innovaciones en la tecnología de comprensión de videos de larga duración, brindando un fuerte soporte para aplicaciones como la toma de decisiones inteligente incorporada, reseñas en profundidad de películas y televisión y comentarios deportivos profesionales.

Este proyecto contiene varias horas de datos de control de calidad en 6 categorías principales y 21 subcategorías, que cubren diferentes tipos de contenido de vídeo, como series de televisión, retransmisiones deportivas y secuencias de vigilancia diarias de fuentes públicas. Todos los datos están anotados de alta calidad y LLM se utiliza para filtrar problemas desafiantes. Se informa que el conjunto de datos de LVBench cubre una variedad de tareas como resumen de video, detección de eventos, reconocimiento de personajes y comprensión de escenas.

El lanzamiento del punto de referencia LVBench no solo tiene como objetivo probar el razonamiento y las capacidades operativas del modelo en escenarios de video largos, sino que también promueve avances e innovaciones en tecnologías relacionadas para lograr toma de decisiones inteligente incorporada, reseñas en profundidad de películas y televisión y deportes profesionales. Los comentarios en el campo de los vídeos largos necesitan inyectar un nuevo impulso.

Muchas instituciones de investigación han comenzado a trabajar en el conjunto de datos de LVBench, ampliando gradualmente los límites de la inteligencia artificial en la comprensión de los flujos de información a largo plazo mediante la construcción de modelos grandes para tareas de video largas e inyectando nuevas ideas en la exploración continua de la comprensión del video, multimodal. aprendizaje y otros campos de la vitalidad.

github: https://github.com/THUDM/LVBench

Proyecto: https://lvbench.github.io

Documento: https://arxiv.org/abs/2406.08035

El lanzamiento del proyecto LVBench marca una nueva etapa en el desarrollo de la tecnología de comprensión de videos de larga duración. Los ricos conjuntos de datos y las tareas desafiantes que proporciona atraerán a más investigadores a participar, acelerarán el progreso de la inteligencia artificial en el campo de la comprensión de videos de larga duración. aportar beneficios a futuras aplicaciones. Más posibilidades. Esperamos más resultados de investigación basados en LVBench en el futuro.