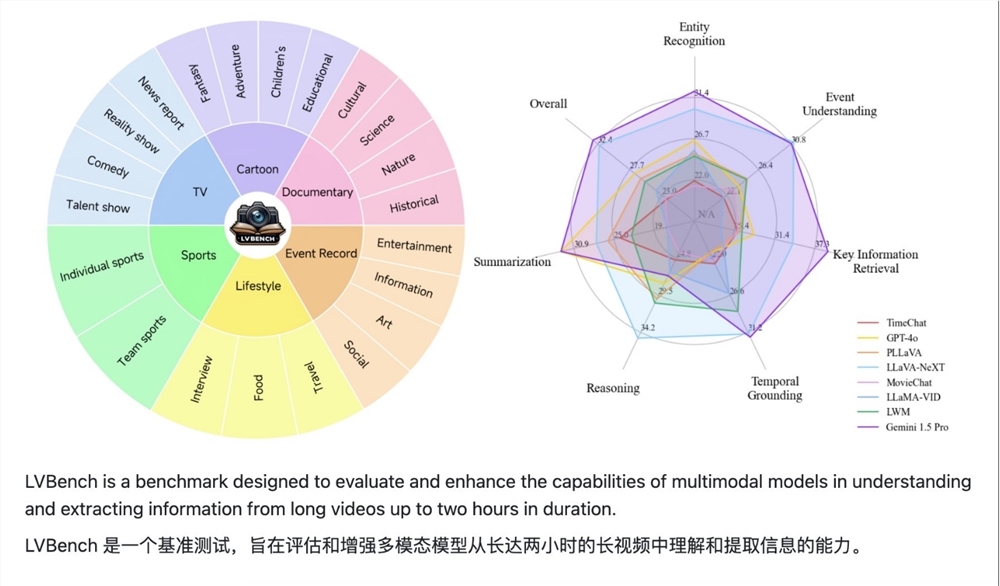

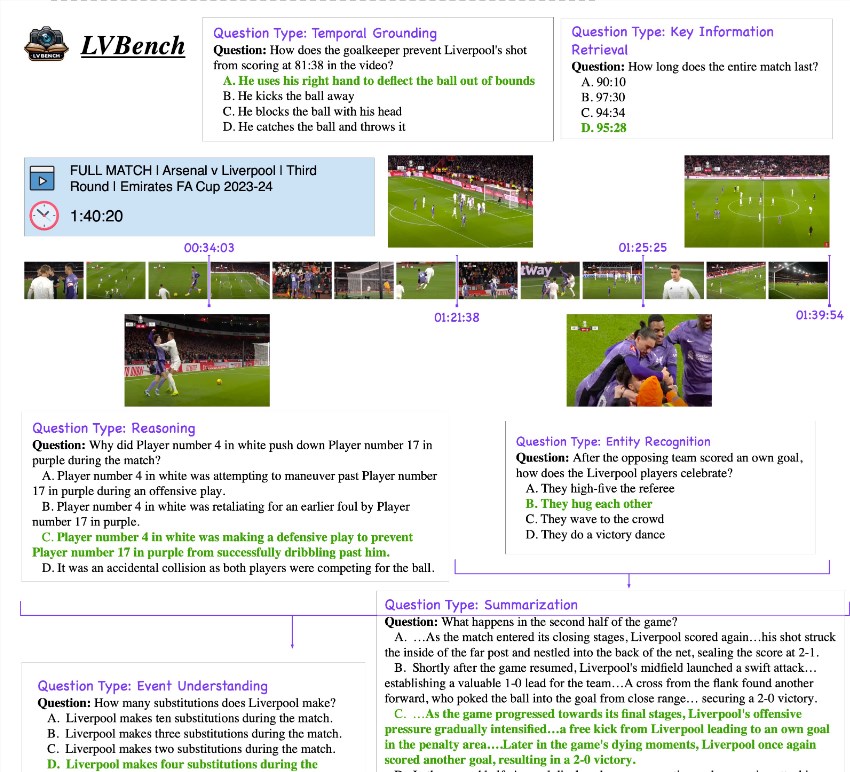

LVBench, ein Benchmark-Projekt zum Verständnis langer Videos, das gemeinsam von Zhipu, der Tsinghua-Universität und der Peking-Universität ins Leben gerufen wurde, zielt darauf ab, die Herausforderungen zu lösen, mit denen bestehende multimodale große Sprachmodelle bei der Verarbeitung langer Videos konfrontiert sind. Das Projekt stellt mehrere Stunden QA-Daten zu verschiedenen Arten von Videoinhalten wie Fernsehserien, Sportübertragungen und Überwachungsvideos bereit und enthält 6 Hauptkategorien und 21 Unterkategorien. Die Daten werden mit hoher Qualität annotiert und zum Herausfiltern wird LLM verwendet anspruchsvolle Probleme, die eine Vielzahl von Aufgaben abdecken, wie z. B. Videozusammenfassung, Ereigniserkennung, Zeichenerkennung und Szenenverständnis. Die Einführung von LVBench wird Durchbrüche und Innovationen in der Technologie zum Verstehen langer Videos fördern und eine starke Unterstützung für Anwendungen wie verkörperte intelligente Entscheidungsfindung, ausführliche Film- und Fernsehkritiken und professionelle Sportkommentare bieten.

Dieses Projekt enthält mehrere Stunden QA-Daten in 6 Hauptkategorien und 21 Unterkategorien und deckt verschiedene Arten von Videoinhalten wie Fernsehserien, Sportübertragungen und tägliches Überwachungsmaterial aus öffentlichen Quellen ab. Die Daten sind alle hochwertig annotiert und LLM wird verwendet, um herausfordernde Probleme herauszufiltern. Es wird berichtet, dass der LVBench-Datensatz eine Vielzahl von Aufgaben abdeckt, wie z. B. Videozusammenfassung, Ereigniserkennung, Zeichenerkennung und Szenenverständnis.

Die Einführung des LVBench-Benchmarks zielt nicht nur darauf ab, die Denk- und Betriebsfähigkeiten des Modells in langen Videoszenarien zu testen, sondern fördert auch Durchbrüche und Innovationen in verwandten Technologien, um verkörperte intelligente Entscheidungen, ausführliche Film- und Fernsehkritiken sowie Profisport zu erreichen Kommentierung im Bereich Langvideos bringt neue Impulse.

Viele Forschungseinrichtungen haben mit der Arbeit am LVBench-Datensatz begonnen und erweitern schrittweise die Grenzen der künstlichen Intelligenz beim Verständnis langfristiger Informationsflüsse, indem sie große Modelle für lange Videoaufgaben erstellen und neue Ideen in die kontinuierliche Erforschung des multimodalen Videoverständnisses einbringen Lernen und andere Bereiche der Vitalität.

github:https://github.com/THUDM/LVBench

Projekt: https://lvbench.github.io

Papier: https://arxiv.org/abs/2406.08035

Der Start des LVBench-Projekts markiert eine neue Etappe in der Entwicklung der Technologie zum Verstehen langer Videos. Die umfangreichen Datensätze und herausfordernden Aufgaben, die es bietet, werden mehr Forscher zur Teilnahme anziehen, den Fortschritt der künstlichen Intelligenz im Bereich des Verstehens langer Videos beschleunigen Vorteile für zukünftige Anwendungen bringen. Wir freuen uns auf weitere Forschungsergebnisse auf Basis von LVBench in der Zukunft.