Le chiffon pour les articles avec du code est une méthode plus facile à parcourir des tonnes de recherche ML en appuyant simplement sur un bouton. Un système de chiffon qui exploite facilement une grande quantité d'informations. Vous lui poserez vos questions en langage naturel et il répondra en fonction des articles pertinents qu'il trouve sur les articles avec du code.

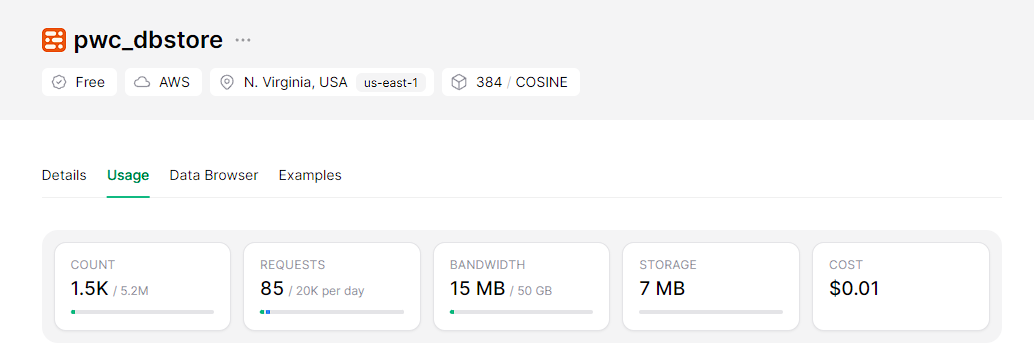

Du côté backend, le système est propulsé par un cadre de génération augmentée (RAG) de récupération qui s'appuie sur une base de données de vecteurs sans serveur évolutive appelée Upstash, pour les incorporations que nous utilisons des modèles BGE sur le HuggingFace, et Mixtral-8x7B-Instruct-V0.1 comme LLM à partir de Hugging Face.

Du côté frontal, cet assistant sera intégré dans une application Web interactive et facilement déployable construite avec Streamlit.

Cloner le repo

git clone https://github.com/wittyicon29/PWC-RAG.gitPassez au répertoire de l'espace de travail

cd PWC-RAG Indexation de l'index des données dans la base de données vectorielle, vous devez d'abord créer un index sur Upstash et remplir les informations d'identification dans le fichier .env :

UPSTASH_URL=...

UPSTASH_TOKEN=...

Exécutez la commande suivante:

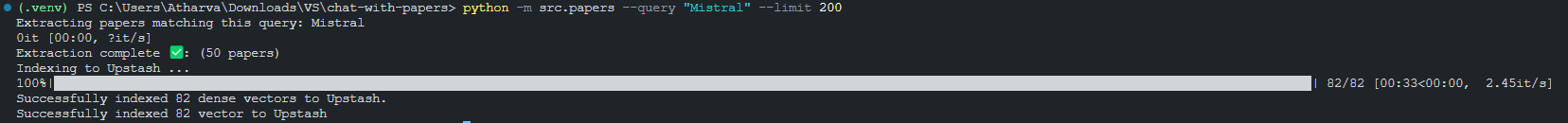

python -m src.index_papers --query " Mistral " --limit 200Résultat de l'indexation de 200 morceaux correspondant à la requête "Mistral".

Exécuter les applications de rationalisation localement

Avant d'exécuter l'application Streamlit, vous devez définir le jeton API HuggingFace dans le fichier '.env':

HUGGINGFACE_API_TOKEN=...Maintenant vous pouvez l'application rationalisée

python -m streamlit run src/app.py

Comment créer une application LLM pour discuter avec des papiers avec un code