Anglais | chinois simplifié

Autodl Challenge @ Neirips Challenge, voir la compétition AutoDL pour plus de détails.

AutoDL se concentre sur un algorithme général qui effectue automatiquement une classification multi-étiquettes des modalités arbitraires (image, vidéo, voix, texte, données tabulaires). Réglage des données, fonctionnalités, modèles, pour des problèmes tels que les super paramètres, vous pouvez faire un classificateur avec d'excellentes performances en aussi peu que 10 secondes. Ce projet a obtenu des résultats extrêmement excellents dans 24 ensembles de données hors ligne et 15 ensembles de données en ligne dans différents domaines . Autodl a les fonctionnalités suivantes:

☕full -Automatique : Cadre d'apprentissage en profondeur / apprentissage automatique entièrement automatique, aucune intervention manuelle n'est requise pour l'ensemble du processus. Tous les détails des données, des fonctionnalités et des modèles ont été ajustés aux meilleurs, et les problèmes de limitation des ressources, de biais de données, de petites données, d'ingénierie des fonctionnalités, de sélection de modèles, d'optimisation de la structure du réseau et de recherche d'hyperparamètre ont été résolus uniformément. Préparez simplement les données, démarrez Autodl et prenez une tasse de café .

? Université : prend en charge les modalités arbitraires , y compris les images, la vidéo, l'audio, le texte et les données tabulaires structurées, et prend en charge tout problème de classification multi-étiquettes , y compris la classification binaire, la multi-classification et la classification multi-étiquettes. Il a obtenu des résultats extrêmement excellents dans différents domaines , tels que la reconnaissance des piétons, la reconnaissance d'action des piétons, la reconnaissance du visage, la reconnaissance de l'empreinte vocale, la classification de la musique, la classification des accent, la classification des langues, la classification des émotions, la classification des e-mails, la classification des nouvelles, l'optimisation publicitaire, les systèmes de recommandation, la recherche moteurs, marketing de précision, etc.

? Résultats excellents : la compétition Autodl a remporté un programme de champion écrasant, y compris le soutien aux modèles d'apprentissage automatique traditionnels et les derniers modèles d'apprentissage en profondeur. La bibliothèque de modèles comprend des modèles de champion préférés de LR / SVM / LGB / CGB / XGB à Resnet * / MC3 / DNN / ThinResnet * / TextCnn / RCNN / GRU / Bert et ainsi de suite.

⚡Extreme Speed / Time en temps réel : obtenez des performances de modèle compétitives en dix secondes aussi rapidement. Les résultats sont actualisés en temps réel (secondes) et vous pouvez obtenir des commentaires en temps réel sur le modèle sans attendre.

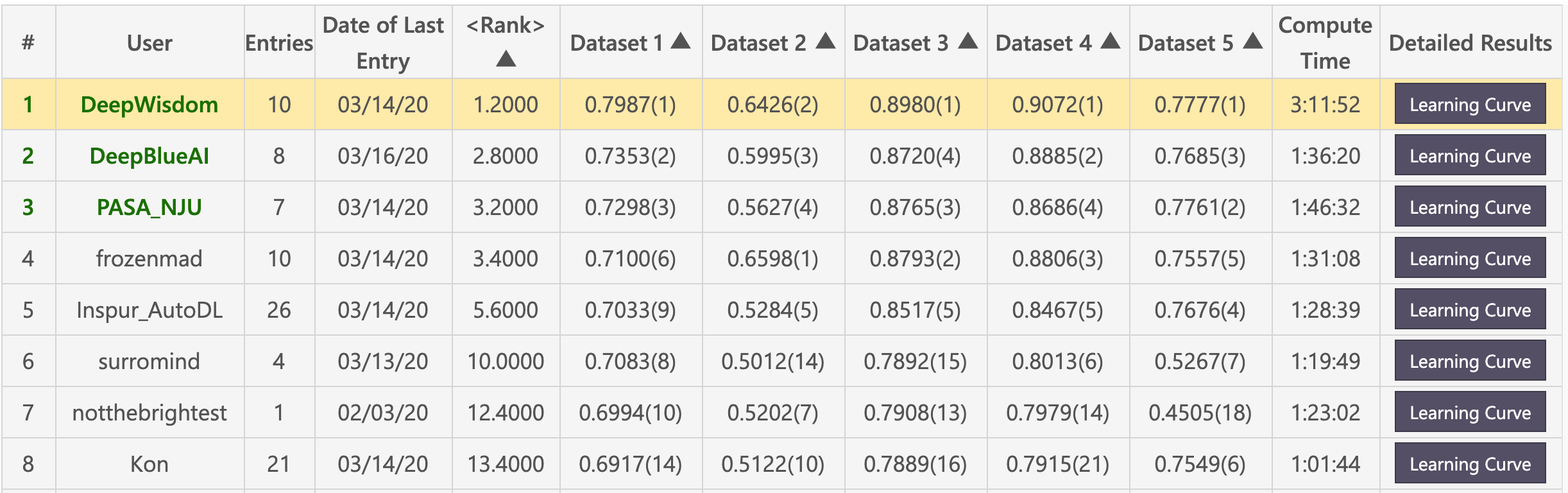

Liste préliminaire (Deepwisdom s'est classé premier au total, avec un classement moyen de 1,2, et a remporté 4 premières en 5 ensembles de données)

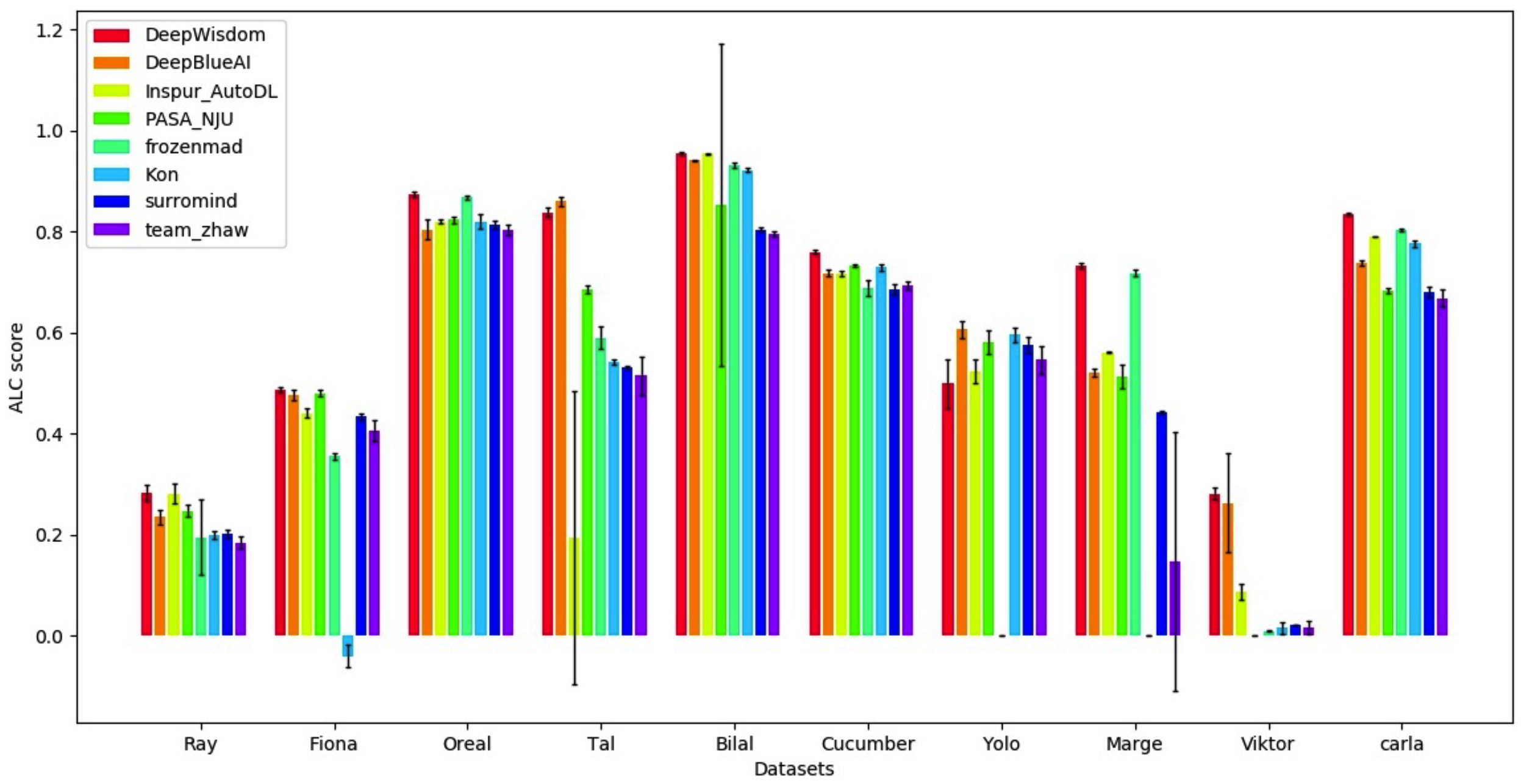

Liste des finales (Deepwisdom s'est classé premier au total, avec un classement moyen de 1,8, et classé 7 premières en 10 ensembles de données)

Environnement de base

python > =3.5

CUDA 10

cuDNN 7.5entrepôt de clones

cd <path_to_your_directory>

git clone https://github.com/DeepWisdom/AutoDL.git

Modèle pré-formé pour télécharger le modèle Speech_Model.h5 et le mettre dans AutoDL_sample_code_submission/at_speech/pretrained_models/ Directory.

Facultatif: utilisez un environnement Docker synchronisé avec la concurrence

cd path/to/autodl/

docker run -it -v "$(pwd):/app/codalab" -p 8888:8888 evariste/autodl:cpu-latest

nvidia-docker run -it -v "$(pwd):/app/codalab" -p 8888:8888 evariste/autodl:gpu-latest

Préparation de l'ensemble de données: Utilisez l'échantillon de données dans AutoDL_sample_data , ou téléchargez par lots l'ensemble de données publique du concours.

Effectuer des tests locaux

python run_local_test.py

Les tests locaux sont utilisés en totalité. python run_local_test.py -dataset_dir='AutoDL_sample_data/miniciao' -code_dir='AutoDL_sample_code_submission' Vous pouvez afficher la page HTML pour une rétroaction de courbe d'apprentissage en temps réel dans AutoDL_scoring_output/ Directory.

Pour plus de détails, veuillez consulter AutoDL Challenge OFFICIEL START_KIT.

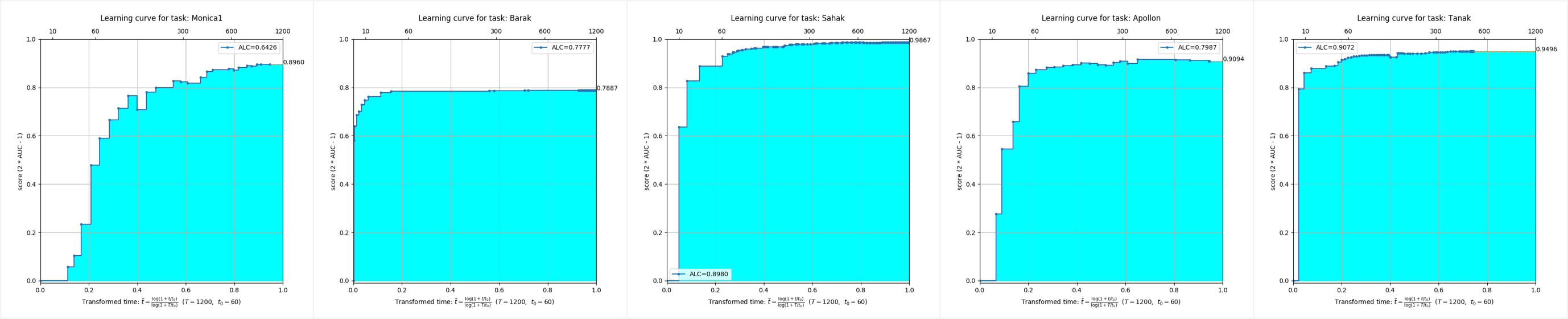

On peut voir que dans les ensembles de données de cinq modes différents, les flux d'algorithmes AutoDL ont atteint des effets extrêmement excellents à temps plein et peuvent atteindre une précision extrêmement élevée en très peu de temps.

Ce référentiel est testé sur Python 3.6+, Pytorch 1.3.1 et TensorFlow 1.15.

Vous devez installer Autodl dans l'environnement virtuel. Si vous n'êtes pas familier avec l'environnement virtuel, veuillez vous référer aux conseils de l'utilisateur.

Créez un environnement virtuel avec la version Python appropriée et activez-la.

start_env.batMiniconda3 installé cmd.exe " /K " . M iniconda3 S cripts a ctivate.bat . M iniconda3start_env.bat pour installer Autodl-GPU conda install pytorch==1.3.1

conda install torchvision -c pytorch

pip install autodl-gpupip install autodl-gpuPour les instructions, veuillez consulter le test d'effet local Autodl pour un accès rapide et consultez des exemples / run_local_test.py par exemple le code.

Voir la classification de l'image de démarrage rapide et l'exemple de code est affiché dans des exemples / run_image_classification_example.py

Pour les instructions, veuillez vous référer à la classification vidéo rapide.

Pour les instructions, veuillez consulter la classification audio pour un accès rapide, et par exemple le code, veuillez vous référer aux exemples / run_speech_classification_example.py

Pour dire, consultez la classification du texte du texte rapide à main et consultez des exemples de codes dans des exemples / run_text_classification_example.py.

Pour obtenir des conseils, consultez la classification de la table rapide de démarrage et consultez des exemples / run_tabular_classification_example.py par exemple le code.

python download_public_datasets.py| # | Nom | Taper | Domaine | Taille | Source | Données (sans étiquettes de test) | Étiquettes de test |

|---|---|---|---|---|---|---|---|

| 1 | Munster | Image | Hwr | 18 Mb | MNIST | munster.data | Munster.Solution |

| 2 | Ville | Image | Objets | 128 MB | Cifar-10 | ville.data | solution de ville |

| 3 | Croustillant | Image | Objets | 128 MB | CIFAR-100 | chucky.data | chucky.solution |

| 4 | Pédro | Image | Personnes | 377 MB | PA-100K | pedro.data | Pedro.Solution |

| 5 | Autocollant | Image | Aérien | 73 MB | NWPU VHR-10 | décalale.data | décalcomanie.solution |

| 6 | Marteau | Image | Médical | 111 MB | HAM10000 | Hammer.data | Hammer.Solution |

| 7 | Kreatur | Vidéo | Action | 469 MB | Kth | kreatur.data | kreur.solution |

| 8 | Kreatur3 | Vidéo | Action | 588 MB | Kth | kreatur3.data | KRAUTUR3.Solution |

| 9 | Kraut | Vidéo | Action | 1,9 Go | Kth | kraut.data | kraut.solution |

| 10 | Katze | Vidéo | Action | 1,9 Go | Kth | katze.data | katze.solution |

| 11 | data01 | Discours | Conférencier | 1,8 Go | - | data01.data | data01.solution |

| 12 | data02 | Discours | Émotion | 53 MB | - | data02.data | data02.Solution |

| 13 | data03 | Discours | Accent | 1,8 Go | - | data03.data | data03.solution |

| 14 | data04 | Discours | Genre | 469 MB | - | data04.data | data04.solution |

| 15 | data05 | Discours | Langue | 208 MB | - | data05.data | data05.Solution |

| 16 | O1 | Texte | Commentaires | 828 Ko | - | O1.data | O1.Solution |

| 17 | O2 | Texte | Émotion | 25 Mb | - | O2.data | O2.Solution |

| 18 | O3 | Texte | Nouvelles | 88 Mb | - | O3.data | O3 |

| 19 | O4 | Texte | Courrier indésirable | 87 Mb | - | O4.data | O4. |

| 20 | O5 | Texte | Nouvelles | 14 Mb | - | O5.data | O5. |

| vingt-et-un | Adulte | Tabulaire | Recensement | 2 Mb | Adulte | adulte.data | solution adulte |

| vingt-deux | Dilbert | Tabulaire | - | 162 MB | - | dilbert.data | dilbert.solution |

| vingt-trois | Chiffres | Tabulaire | Hwr | 137 MB | MNIST | Digits.data | chiffres.Solution |

| vingt-quatre | Madeline | Tabulaire | - | 2,6 Mb | - | madeline.data | Madeline.Solution |

❤️ Veuillez n'hésiter pas à participer à la contribution ouvrir un problème ou à soumettre PRS.

Licence Apache 2.0