Englisch | vereinfacht Chinesisch

Autodl Challenge@Neurips Challenge, siehe Autodl -Wettbewerb für Details.

Autodl konzentriert sich auf einen allgemeinen Algorithmus, der automatisch eine Multi-Label-Klassifizierung von willkürlichen Modalitäten durchführt (Bild, Video, Sprache, Text, tabuläre Daten). Datenanpassung, Funktionen, Modelle, für Probleme wie Superparameter können Sie einen Klassifikator mit einer hervorragenden Leistung in nur 10 Sekunden erstellen. Dieses Projekt hat in 24 Offline -Datensätzen und 15 Online -Datensätzen in verschiedenen Bereichen exzellente Ergebnisse erzielt . Autodl hat die folgenden Funktionen:

☕ful -automat : Vollautomatisch Deep Learning/Machine Learning Framework, für den gesamten Prozess ist keine manuelle Intervention erforderlich. Alle Details zu Daten, Merkmalen und Modellen wurden an die besten und die Probleme der Ressourcenbeschränkung, der Datenverckung, der kleinen Daten, der Feature Engineering, der Modellauswahl, der Netzwerkstrukturoptimierung und der Hyperparameter -Suche einheitlich gelöst. Bereiten Sie einfach die Daten vor, starten Sie Autodl und trinken Sie eine Tasse Kaffee .

? Es hat extrem hervorragende Ergebnisse in verschiedenen Bereichen erzielt, wie z. Motoren, Präzisionsmarketing usw.

? Ausgezeichnete Ergebnisse : Autodl -Wettbewerb gewann ein überwältigendes Championprogramm, einschließlich der Unterstützung für traditionelle maschinelle Lernmodelle und der neuesten Deep Learning -Modelle. Die Modellbibliothek enthält bevorzugte Champion -Modelle von LR/SVM/LGB/CGB/XGB bis ResNet*/Mc3/DNN/ThinResnet*/textcnn/rcnn/Gru/Bert usw.

⚡extreme Geschwindigkeit/Echtzeit : Erhalten Sie die Leistung des Wettbewerbsmodells in zehn Sekunden. Die Ergebnisse werden in Echtzeit (Sekunden) aktualisiert und Sie können Echtzeit-Feedback zum Modell erhalten, ohne zu warten.

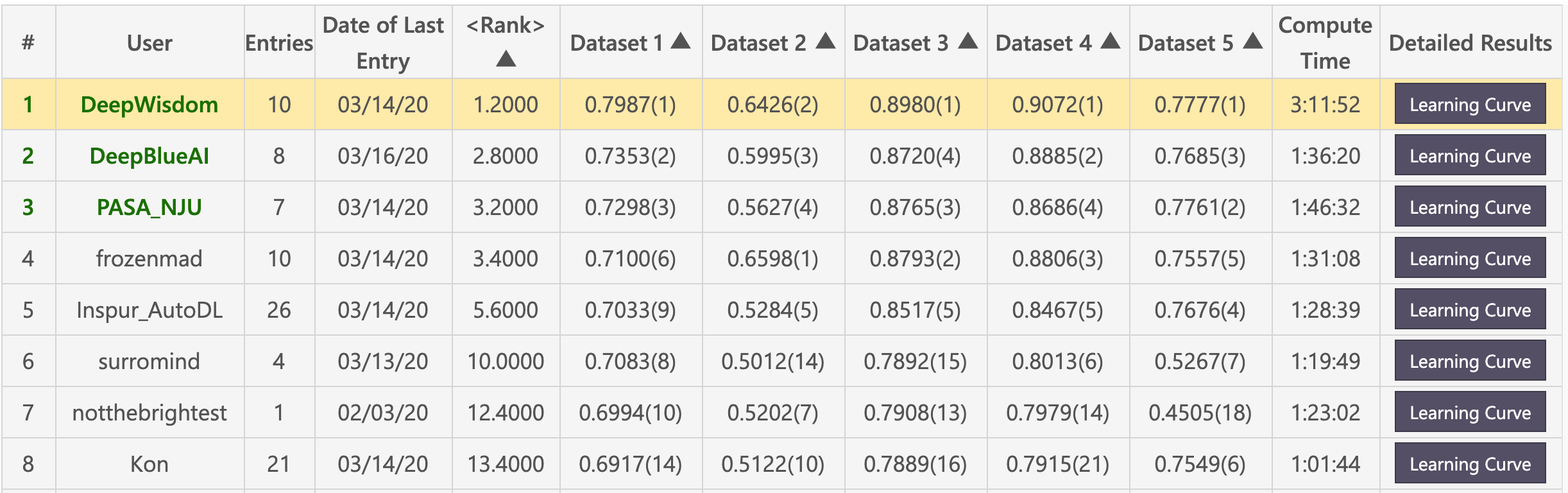

Vorläufige Liste (Deepwisdom belegte mit einem durchschnittlichen Rang von 1,2 insgesamt den ersten Platz und gewann 4 erste in 5 Datensätzen).

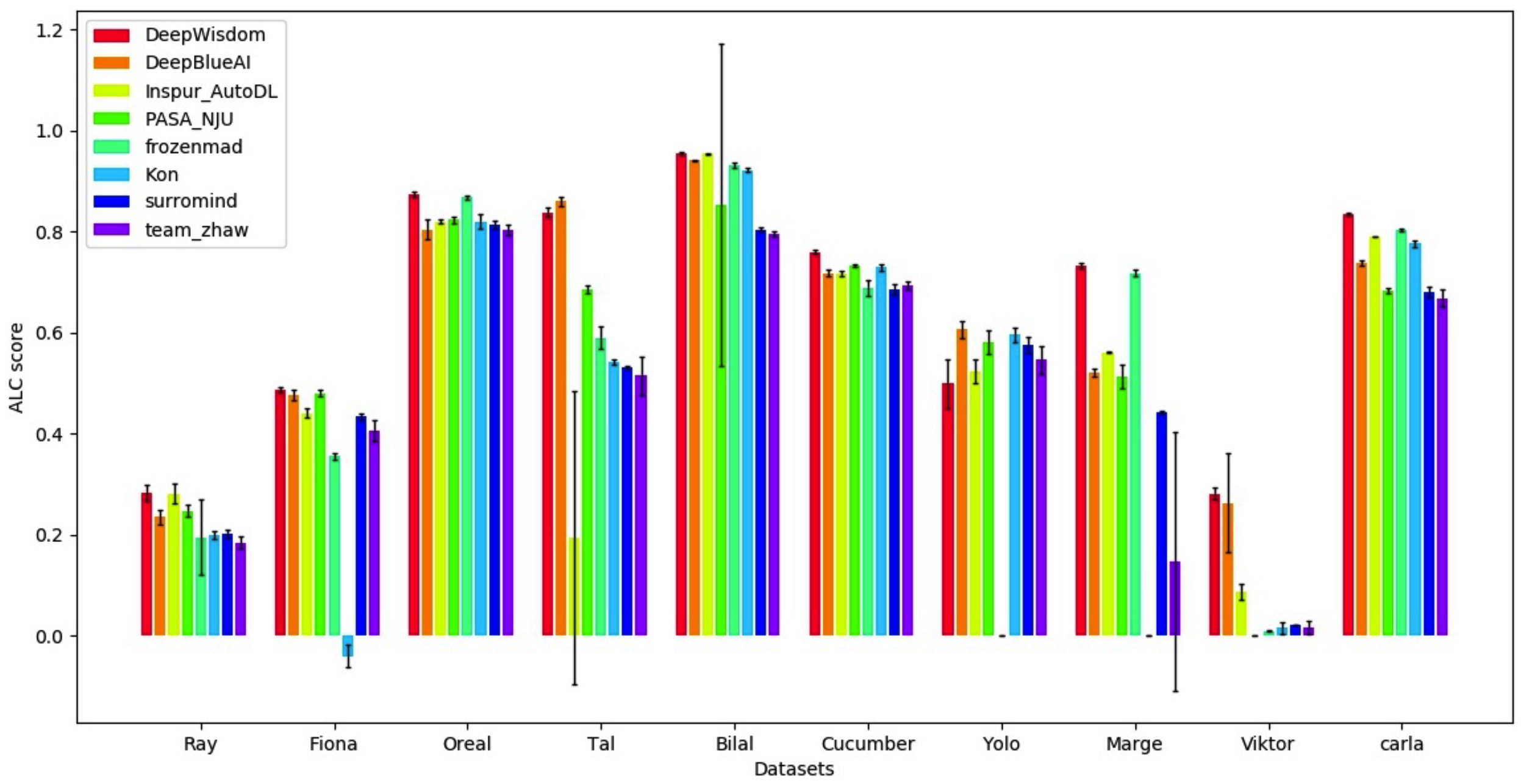

Finalliste (DeepWisdom belegte mit einem durchschnittlichen Rang von 1,8 insgesamt den ersten Platz und belegte 7 erste in 10 Datensätzen.

Grundlegende Umgebung

python > =3.5

CUDA 10

cuDNN 7.5Klonlager

cd <path_to_your_directory>

git clone https://github.com/DeepWisdom/AutoDL.git

Vorausgebildetes Modell zum Herunterladen des Modells real_model.h5 und in AutoDL_sample_code_submission/at_speech/pretrained_models/ Verzeichnis.

Optional: Verwenden Sie eine Docker -Umgebung, die mit dem Wettbewerb synchronisiert ist

cd path/to/autodl/

docker run -it -v "$(pwd):/app/codalab" -p 8888:8888 evariste/autodl:cpu-latest

nvidia-docker run -it -v "$(pwd):/app/codalab" -p 8888:8888 evariste/autodl:gpu-latest

Datensatzvorbereitung: Verwenden Sie den Beispieldatensatz in AutoDL_sample_data oder batch Download den public -Datensatz des Wettbewerbs.

Lokale Tests durchführen

python run_local_test.py

Lokale Tests werden vollständig verwendet. python run_local_test.py -dataset_dir='AutoDL_sample_data/miniciao' -code_dir='AutoDL_sample_code_submission' Sie können die Seite html für die Echtzeit -Lernkurve -Feedback in AutoDL_scoring_output/ Directory anzeigen.

Weitere Informationen finden Sie unter autodl Challenge official start_kit.

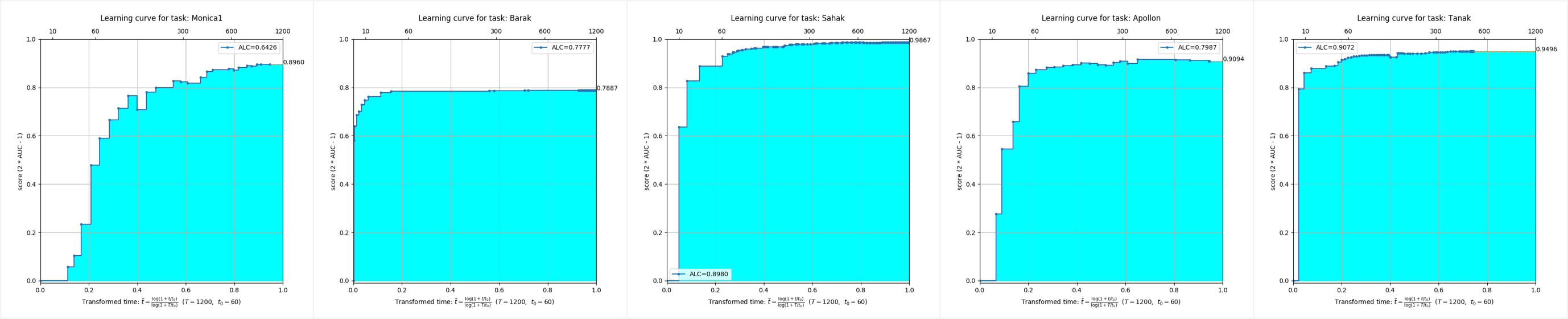

Es ist ersichtlich, dass unter den Datensätzen von fünf verschiedenen Modi die Autodl-Algorithmusströme extrem hervorragende Vollzeiteffekte erzielt haben und in sehr kurzer Zeit eine extrem hohe Genauigkeit erzielen können.

Dieses Repository wird auf Python 3.6+, Pytorch 1.3.1 und TensorFlow 1.15 getestet.

Sie sollten Autodl in der virtuellen Umgebung installieren. Wenn Sie mit der virtuellen Umgebung nicht vertraut sind, lesen Sie bitte die Benutzeranleitung.

Erstellen Sie eine virtuelle Umgebung mit der entsprechenden Python -Version und aktivieren Sie sie.

start_env.bat -Datei erstellenMiniconda3 -Verzeichnis cmd.exe " /K " . M iniconda3 S cripts a ctivate.bat . M iniconda3start_env.bat , um autodl-gpu zu installieren conda install pytorch==1.3.1

conda install torchvision -c pytorch

pip install autodl-gpupip install autodl-gpuFür Anweisungen finden Sie im automatischen AUTODL LOCAL Effect -Test für schnellen Zugriff und finden Sie Beispiele/run_local_test.py, um beispielsweise Code zu erhalten.

Siehe die Klassifizierung des schnellen Startbilds und der Beispielcode wird in Beispielen/run_image_classification_example.py angezeigt

Informationen zu Anweisungen finden Sie in der Quick Start -Video -Klassifizierung.

Für Anweisungen finden Sie in der Audio -Klassifizierung, um schnellen Zugriff zu erhalten. Sie finden

Zur Anleitung finden Sie in der Textklassifizierung des schnellen Textes und siehe Beispielcodes in Beispielen/run_text_classification_example.py.

Weitere Informationen finden Sie in der Schnellstart -Tabellenklassifizierung und siehe Beispiele/run_tabular_classification_example.py zum Beispiel Code.

python download_public_datasets.py| # | Name | Typ | Domain | Größe | Quelle | Daten (w/o Testetiketten) | Testetiketten |

|---|---|---|---|---|---|---|---|

| 1 | Münster | Bild | HWR | 18 MB | MNIST | Münster.Data | Munster.Lolution |

| 2 | Stadt | Bild | Objekte | 128 MB | CIFAR-10 | Stadt.Data | Stadt.Lolution |

| 3 | Chucky | Bild | Objekte | 128 MB | Cifar-100 | chucky.data | Chucky.Lolution |

| 4 | Pedro | Bild | Menschen | 377 MB | PA-100K | pedro.data | Pedro.Lolution |

| 5 | Abziehbild | Bild | Antenne | 73 MB | NWPU VHR-10 | Decal.Data | Decal.Lolution |

| 6 | Hammer | Bild | Medizinisch | 111 MB | HAM10000 | Hammer.Data | Hammer.Lolution |

| 7 | Kreatur | Video | Aktion | 469 MB | KTH | kreatur.data | Kreatur.Lolution |

| 8 | Kreatur3 | Video | Aktion | 588 MB | KTH | kreatur3.data | Kreatur3.Lution |

| 9 | Kraut | Video | Aktion | 1,9 GB | KTH | Kraut.Data | Kraut.Lution |

| 10 | Katze | Video | Aktion | 1,9 GB | KTH | katze.data | Katze.Lolution |

| 11 | Data01 | Rede | Lautsprecher | 1,8 GB | - | Data01.Data | Data01.Lolution |

| 12 | Data02 | Rede | Emotion | 53 MB | - | Data02.Data | Data02.Lösung |

| 13 | Data03 | Rede | Akzent | 1,8 GB | - | Data03.Data | Data03.lösung |

| 14 | Data04 | Rede | Genre | 469 MB | - | Data04.Data | Data04. Lösung |

| 15 | Data05 | Rede | Sprache | 208 MB | - | Data05.data | Data05.lösung |

| 16 | O1 | Text | Kommentare | 828 kb | - | O1.Data | O1.Lution |

| 17 | O2 | Text | Emotion | 25 MB | - | O2.Data | O2.Lolution |

| 18 | O3 | Text | Nachricht | 88 MB | - | O3.data | O3.lösung |

| 19 | O4 | Text | Spam | 87 MB | - | O4.data | O4.lösung |

| 20 | O5 | Text | Nachricht | 14 MB | - | O5.data | O5.lösung |

| Einundzwanzig | Erwachsene | Tabellarisch | Volkszählung | 2 MB | Erwachsene | Adult.Data | Erwachsene. Lösung |

| Zweiundzwanzig | Dilbert | Tabellarisch | - | 162 MB | - | Dilbert.Data | Dilbert.Lolution |

| Dreiundzwanzig | Ziffern | Tabellarisch | HWR | 137 MB | MNIST | Ziffern.Data | Ziffern. Lösung |

| vierundzwanzig | Madeline | Tabellarisch | - | 2,6 MB | - | Madeline.data | Madeline.Lolution |

❤️ Bitte zögern Sie nicht, an dem Beitrag teilzunehmen, ein Problem zu eröffnen oder PRs einzureichen.

Apache -Lizenz 2.0