¡La "técnica de lectura de la mente" en las películas de ciencia ficción parece ser una realidad! Los científicos de la Universidad de Yale, el Dartmouth College y la Universidad de Cambridge desarrollaron conjuntamente un modelo de IA llamado Mindllm que puede decodificar directamente las señales cerebrales escaneadas por imágenes de resonancia magnética funcional (fMRI) en un texto que se puede poner en cuenta humano. Esta tecnología innovadora hace que las personas suspiran que el futuro ha llegado en silencio.

Transformar las actividades cerebrales complejas en palabras siempre ha sido un gran desafío en el campo de la neurociencia, y es tan difícil como la escalada en el Monte Everest. Las técnicas anteriores tenían predicciones pobres o solo podían manejar tareas simples, y tenían casi cero versatilidad entre los sujetos. Sin embargo, el surgimiento de Mindllm cambió por completo esta situación.

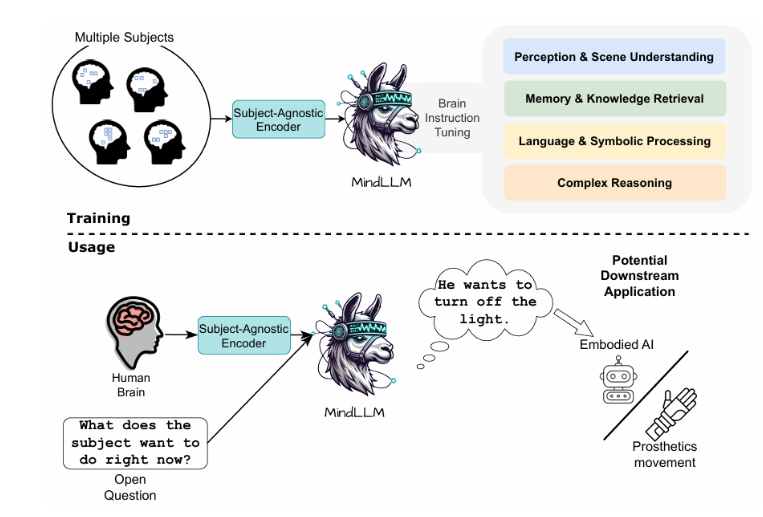

Mindllm es como un "super traductor" que no solo puede comprender las actividades del cerebro, sino también convertirlo en palabras sin ser restringido por el sujeto y el sujeto. Este avance es gracias a la tecnología de ajuste de instrucciones (bit) del cerebro desarrollada por los investigadores, lo que permite a Mindllm capturar con mayor precisión información semántica en señales de fMRI, mejorando en gran medida las capacidades de decodificación.

En las pruebas reales, el rendimiento de Mindllm fue increíble. Entre varias tareas de FMRI a texto, su rendimiento supera con creces todos los modelos anteriores, con las tareas aguas abajo mejoradas en un 12,0%, la capacidad de generalización de temas desconocidos aumentó en un 16,4%y la adaptabilidad de nuevas tareas aumentó en un 25.0%. El rendimiento de este "maestro académico completo" indudablemente abrió nuevas posibilidades para la tecnología de interfaz de computadora cerebral.

Mindllm tiene una amplia perspectiva de aplicación. Para pacientes con trastornos del lenguaje como la afasia y el cuello uterino amiotrófico, se espera que les ayude a recuperar su capacidad de expresarse y volver a conectarse con el mundo. Para las personas sanas, Mindllm también ha abierto la puerta a dispositivos digitales de "control mental", y si está controlando la IA o el control de las prótesis, se volverá más natural y humano.

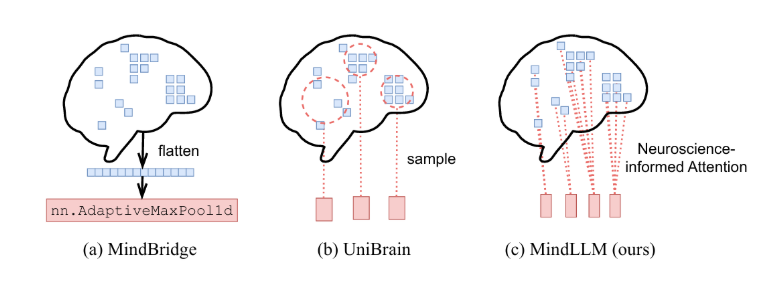

El éxito de Mindllm es inseparable de su diseño "tanto interno como externo". Utiliza un codificador fMRI independiente de sujeto que extrae con precisión las características clave de la actividad cerebral de las señales de fMRI complejos y es adecuado para diferentes sujetos. Al mismo tiempo, está equipado con un modelo de lenguaje grande (LLM), que puede convertir suavemente las características de EEG extraídas en lenguaje humano.

Para mejorar aún más la precisión y la versatilidad de la decodificación, los investigadores también desarrollaron tecnología de ajuste de instrucción cerebral (bit). A través de imágenes como mediación, Mindllm puede aprender varias tareas, incluida la percepción, la memoria, el lenguaje y el razonamiento, mejorando exhaustivamente la comprensión de la información semántica del cerebro.

En pruebas rigurosas, Mindllm tuvo mucho más allá de las expectativas, no solo superando el modelo de referencia en todos los indicadores, sino que también se adaptó efectivamente a varias tareas nuevas, mostrando una sorprendente plasticidad y flexibilidad. Además, los investigadores también analizaron el mecanismo de atención de Mindllm en profundidad y descubrieron que su proceso de toma de decisiones es interpretable, lo que proporciona información valiosa sobre cómo funciona el cerebro.

El nacimiento de Mindllm es, sin duda, un avance hito desde fMRI hasta decodificación de texto. No solo mejora enormemente la precisión y universalidad de la decodificación, sino que también enciende la imaginación infinita para el desarrollo futuro de la tecnología de interfaz de computadora cerebral. Quizás en el futuro cercano, la "interpretación de ideas" ya no será una escena en las películas de ciencia ficción, sino que realmente entrará en nuestras vidas y abrirá una nueva era de interacción humana-computadora.

Enlace en papel: https://arxiv.org/abs/2502.15786