Este repositorio contiene los scripts para ajustar los modelos previos a los AMOS en los puntos de referencia de pegamento y escuadrón 2.0.

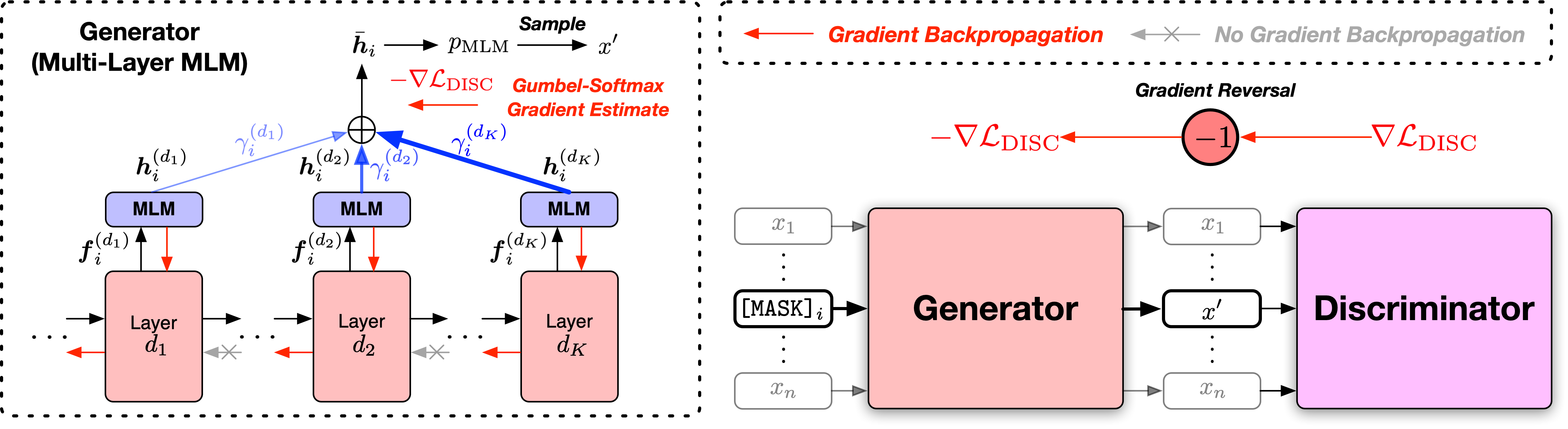

Documento: codificadores de texto previos a la mezcla con una mezcla adversaria de generadores de señales de entrenamiento

Proporcionamos los scripts en dos versiones, basados en dos bases de código de código abierto ampliamente utilizados, la biblioteca Fairseq y la biblioteca Huggingface Transformers. Las dos versiones de código son en su mayoría equivalentes en funcionalidad, y usted es libre de usar cualquiera de ellas. Sin embargo, observamos que la versión FairSeq es lo que utilizamos en nuestros experimentos, y mejor reproducirá los resultados en el documento; La versión Huggingface se implementa más tarde para proporcionar compatibilidad con la biblioteca Huggingface Transformers, y puede producir resultados ligeramente diferentes.

Siga los archivos ReadMe en los dos directorios para ejecutar el código.

El punto de referencia de evaluación general de comprensión del lenguaje (pegamento) es una colección de tareas de comprensión de lenguaje de oraciones o oraciones para evaluar y analizar los sistemas de comprensión del lenguaje natural.

Los resultados del conjunto de desarrollo de pegamento del modelo AMOS Base ++ son los siguientes (mediana de 5 semillas aleatorias diferentes):

| Modelo | Mnli-m/mm | QQP | Qnli | SST-2 | Reajuste salarial | RTE | MRPC | STS-B | Aviso |

|---|---|---|---|---|---|---|---|---|---|

| Amos base ++ | 90.5/90.4 | 92.4 | 94.4 | 95.5 | 71.8 | 86.6 | 91.7 | 92.0 | 89.4 |

Los resultados del conjunto de pruebas de pegamento del modelo AMOS Base ++ son los siguientes (sin conjunto, trucos específicos de tareas, etc.):

| Modelo | Mnli-m/mm | QQP | Qnli | SST-2 | Reajuste salarial | RTE | MRPC | STS-B | Aviso |

|---|---|---|---|---|---|---|---|---|---|

| Amos base ++ | 90.4/89.9 | 90.2 | 94.6 | 96.8 | 69.2 | 83.6 | 88.9 | 91.3 | 88.1 |

Stanford Pregunta Contestador de datos del conjunto de datos (Escuadrón) es un conjunto de datos de comprensión de lectura, que consiste en preguntas planteadas por los trabajadores colectivos en un conjunto de artículos de Wikipedia, donde la respuesta a cada pregunta es un segmento de texto, o en el tramo, del pasaje de lectura correspondiente, o la pregunta podría ser sin respuesta.

Los resultados del set de desarrollo 2.0 de los modelos AMOS Base ++ y grandes ++ son los siguientes (mediana de 5 semillas aleatorias diferentes):

| Modelo | Em | F1 |

|---|---|---|

| Amos base ++ | 85.0 | 87.9 |

Si encuentra útiles el código y los modelos para su investigación, cite el siguiente documento:

@inproceedings{meng2022amos,

title={Pretraining Text Encoders with Adversarial Mixture of Training Signal Generators},

author={Meng, Yu and Xiong, Chenyan and Bajaj, Payal and Tiwary, Saurabh and Bennett, Paul and Han, Jiawei and Song, Xia},

booktitle={International Conference on Learning Representations},

year={2022}

}

Este proyecto da la bienvenida a las contribuciones y sugerencias. La mayoría de las contribuciones requieren que acepte un Acuerdo de Licencia de Contributor (CLA) que declare que tiene derecho y realmente hacernos los derechos para utilizar su contribución. Para más detalles, visite https://cla.opensource.microsoft.com.

Cuando envíe una solicitud de extracción, un BOT CLA determinará automáticamente si necesita proporcionar un CLA y decorar el PR adecuadamente (por ejemplo, verificación de estado, comentario). Simplemente siga las instrucciones proporcionadas por el bot. Solo necesitará hacer esto una vez en todos los reposos usando nuestro CLA.

Este proyecto ha adoptado el Código de Conducta Open Open Microsoft. Para obtener más información, consulte el Código de Conducta Preguntas frecuentes o comuníquese con [email protected] con cualquier pregunta o comentario adicional.