Einfach, aber mächtig.

Englisch doc | 中文文档 | 中文 Readme

Stellenangebote. Übersetzung, Rap -Texte, alles gesucht. Fühlen Sie sich frei, ein Problem zu erstellen.

Pinferencia versucht, der einfachste Server für maschinelles Lernen aller Zeiten zu sein!

Drei zusätzliche Zeilen und Ihr Modell geht online .

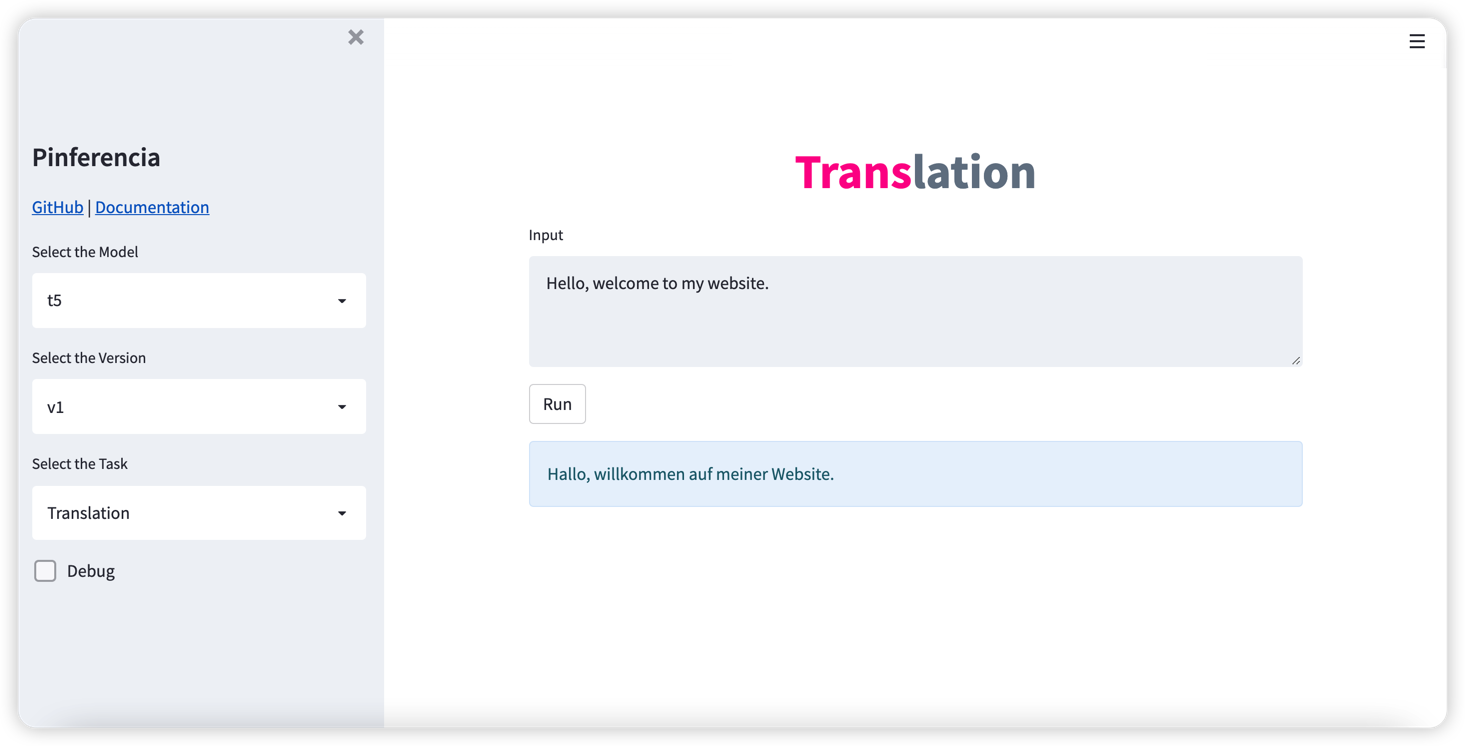

Es war noch nie so einfach, ein Modell mit GUI und REST -API zu dienen.

Wenn Sie wollen

Du bist am richtigen Ort.

Zu den Pinferencia -Funktionen gehören:

pip install " pinferencia[streamlit] "pip install " pinferencia " Jedem Modell dienen

from pinferencia import Server

class MyModel :

def predict ( self , data ):

return sum ( data )

model = MyModel ()

service = Server ()

service . register ( model_name = "mymodel" , model = model , entrypoint = "predict" )Einfach rennen:

pinfer app:service

Hurra, Ihr Service ist am Leben. Gehen Sie zu http://127.0.0.1:8501/ und haben Sie Spaß.

Irgendwelche tiefen Lernmodelle? Genauso einfach. Einfacher Zug oder laden Sie Ihr Modell und registrieren Sie es am Service. Sofort lebendig gehen.

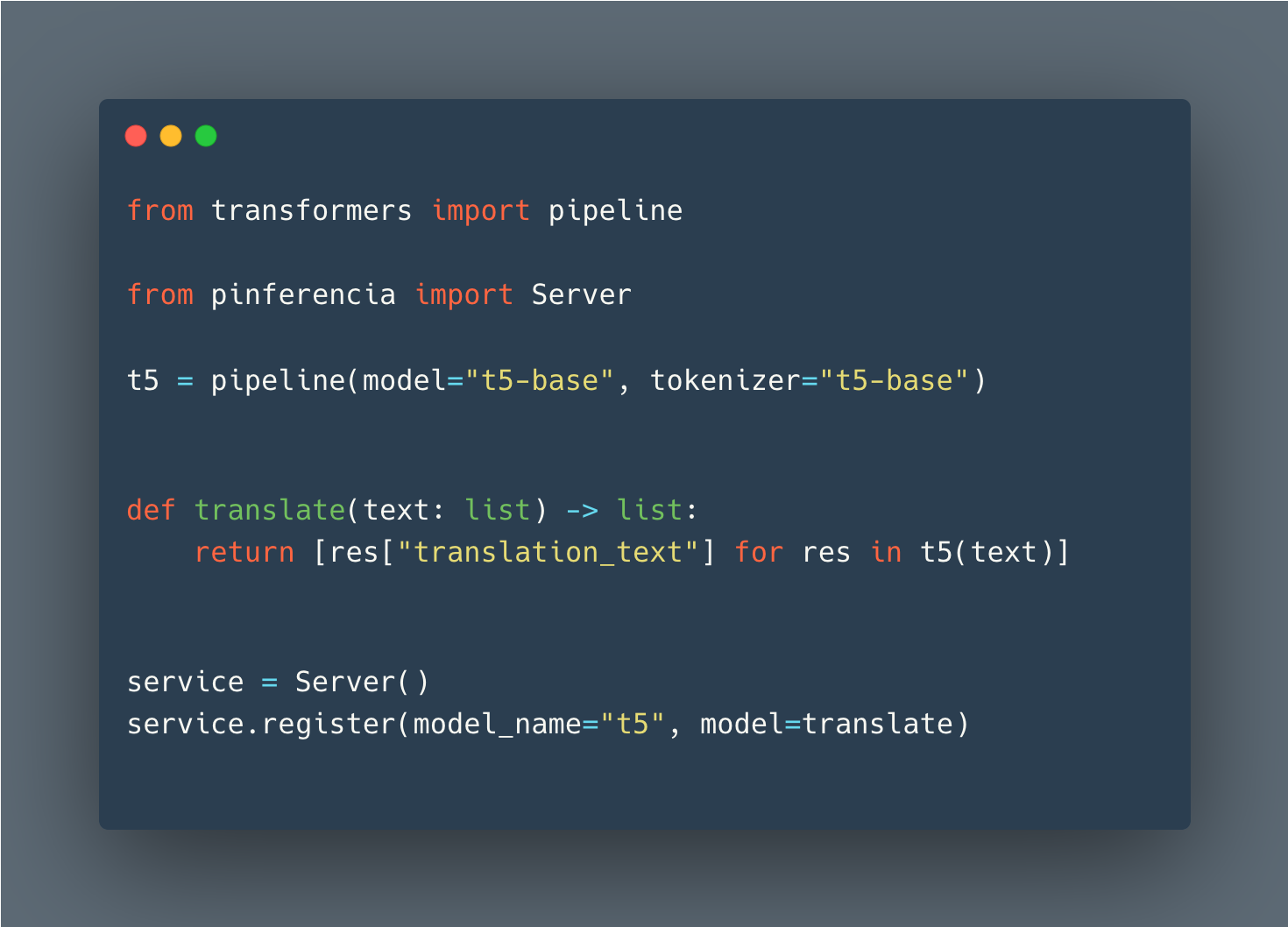

Umarmtes Gesicht

Details: Suggingface Pipeline - Vision

from transformers import pipeline

from pinferencia import Server

vision_classifier = pipeline ( task = "image-classification" )

def predict ( data ):

return vision_classifier ( images = data )

service = Server ()

service . register ( model_name = "vision" , model = predict )Pytorch

import torch

from pinferencia import Server

# train your models

model = "..."

# or load your models (1)

# from state_dict

model = TheModelClass ( * args , ** kwargs )

model . load_state_dict ( torch . load ( PATH ))

# entire model

model = torch . load ( PATH )

# torchscript

model = torch . jit . load ( 'model_scripted.pt' )

model . eval ()

service = Server ()

service . register ( model_name = "mymodel" , model = model )Tensorflow

import tensorflow as tf

from pinferencia import Server

# train your models

model = "..."

# or load your models (1)

# saved_model

model = tf . keras . models . load_model ( 'saved_model/model' )

# HDF5

model = tf . keras . models . load_model ( 'model.h5' )

# from weights

model = create_model ()

model . load_weights ( './checkpoints/my_checkpoint' )

loss , acc = model . evaluate ( test_images , test_labels , verbose = 2 )

service = Server ()

service . register ( model_name = "mymodel" , model = model , entrypoint = "predict" ) Jedes Modell eines Rahmens funktioniert einfach auf die gleiche Weise. Führen Sie jetzt uvicorn app:service --reload und genießen Sie!

Wenn Sie einen Beitrag leisten möchten, finden Sie Details hier