谷歌的研究团队近日发布了一项突破性的模型——TransNAR,该模型巧妙地将Transformer架构与神经算法推理(NAR)技术相结合,显著提升了在复杂算法任务中的表现。这一创新不仅解决了传统Transformer在算法推理中的局限性,还为处理结构化数据提供了全新的解决方案。

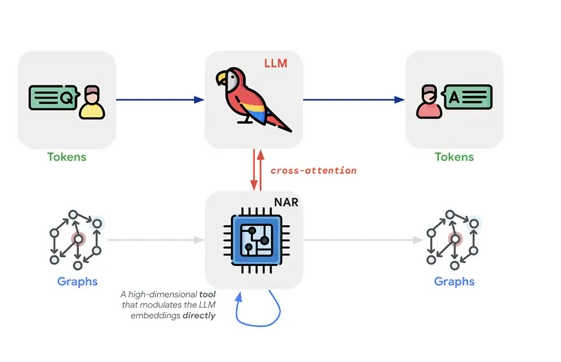

传统Transformer在处理算法问题时,往往面临无法有效捕捉结构化数据的挑战,而NAR技术则在这方面表现出色,尤其是在泛化能力上。TransNAR通过引入跨注意力机制,成功将Transformer的文本处理能力与NAR的图表示能力深度融合。这种结合使得模型能够同时处理文本描述和图结构数据,从而在算法推理任务中展现出前所未有的优势。

TransNAR的训练策略同样别具匠心。在预训练阶段,NAR模块独立进行训练,通过执行多种算法任务来学习内在的逻辑和计算步骤。这一过程为模型奠定了坚实的算法基础。而在微调阶段,TransNAR接受文本描述和图表示的双重输入,利用预训练的NAR模块提供的节点嵌入信息,通过跨注意力机制动态调整自身的标记嵌入。这种多层级训练方法使得模型能够更好地适应复杂的算法任务。

在实际测试中,TransNAR的表现远超传统的Transformer模型,尤其是在分布外的泛化能力上,展现出了超过20%的性能提升。这一成果不仅验证了模型的强大能力,也为未来在更广泛的算法任务中应用提供了有力支持。

划重点:

⭐ 谷歌推出TransNAR模型,将Transformer与NAR技术相结合,显著提升算法推理能力。

⭐ TransNAR采用跨注意力机制,深度融合文本处理与图表示能力,在复杂算法任务中表现优异。

⭐ 多层级训练策略使TransNAR在算法任务上明显优于传统Transformer,尤其在泛化能力方面展现出显著优势。