L'équipe de recherche de Google a récemment publié un modèle révolutionnaire - Transnar, qui combine intelligemment l'architecture du transformateur avec la technologie de raisonnement d'algorithme neuronal (NAR), améliorant considérablement les performances dans des tâches d'algorithme complexes. Cette innovation résout non seulement les limites des transformateurs traditionnels dans le raisonnement algorithmique, mais fournit également une toute nouvelle solution pour le traitement des données structurées.

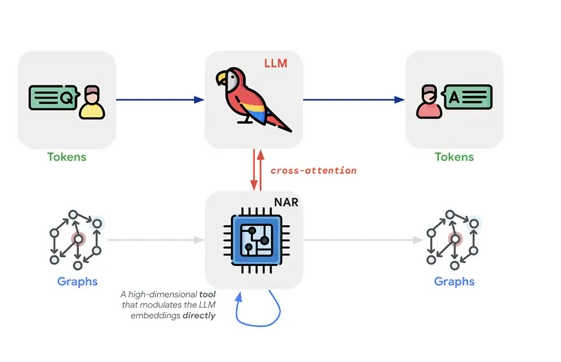

Les transformateurs traditionnels sont souvent confrontés au défi de ne pas pouvoir capturer efficacement des données structurées lorsqu'ils traitent des problèmes d'algorithme, tandis que la technologie NAR fonctionne bien à cet égard, en particulier dans les capacités de généralisation. Transnar intègre avec succès les capacités de traitement de texte de Transformer avec les capacités de représentation de graphe de NAR en introduisant un mécanisme de transtention croisée. Cette combinaison permet au modèle de traiter simultanément les données de la description du texte et de la structure du graphique, montrant ainsi des avantages sans précédent dans les tâches d'inférence algorithmique.

La stratégie de formation de Transnar est également unique. Pendant la phase de pré-formation, le module NAR est entraîné indépendamment et apprend les étapes de logique et de calcul inhérentes en effectuant plusieurs tâches algorithmiques. Ce processus jette une base algorithmique solide pour le modèle. Au stade de réglage fin, Transnar reçoit deux entrées de la description du texte et de la représentation des graphiques, et utilise les informations d'intégration du nœud fournies par le module NAR pré-formé pour ajuster dynamiquement sa propre marque de marque via des mécanismes d'attention croisée. Cette méthode de formation à plusieurs niveaux permet au modèle de mieux s'adapter aux tâches algorithmiques complexes.

Dans les tests réels, la performance de Transnar dépasse de loin celle du modèle de transformateur traditionnel, en particulier dans la capacité de généralisation en dehors de la distribution, montrant une amélioration des performances de plus de 20%. Cette réalisation vérifie non seulement les capacités puissantes du modèle, mais fournit également un solide support pour les applications futures dans une gamme plus large de tâches d'algorithme.

Points clés:

⭐ Google a lancé le modèle Transnar, combinant le transformateur avec la technologie NAR, améliorant considérablement les capacités de raisonnement d'algorithme.

⭐ Transnar adopte un mécanisme de l'attention croisée, intègre profondément le traitement du texte et les capacités de représentation des graphiques, et fonctionne parfaitement dans des tâches d'algorithme complexes.

⭐ La stratégie de formation à plusieurs niveaux rend le transnar nettement meilleur que les transformateurs traditionnels dans les tâches algorithmiques, en particulier dans les capacités de généralisation.