Hugging Face 對其Open LLM Leaderboard 排行榜進行了重大更新,此舉旨在應對大語言模型(LLM)效能提昇放緩的現狀,並為開源人工智慧社群提供更全面、更嚴格的評估標準。此次更新並非簡單的調整,而是對評估指標和測試方法的全面升級,旨在更準確地反映LLM在實際應用中的能力,而非僅依賴單一的性能數字。更新後的排行榜將對開源人工智慧的發展方向產生深遠的影響,推動模型朝著更實用、更可靠的方向發展。

Hugging Face 更新了其Open LLM Leaderboard,這項舉措將對開源人工智慧開發的格局產生重大影響。這項改進在人工智慧發展的關鍵時刻出現,因為研究人員和公司正面臨大語言模型(LLMs)效能提升似乎出現停滯的局面。

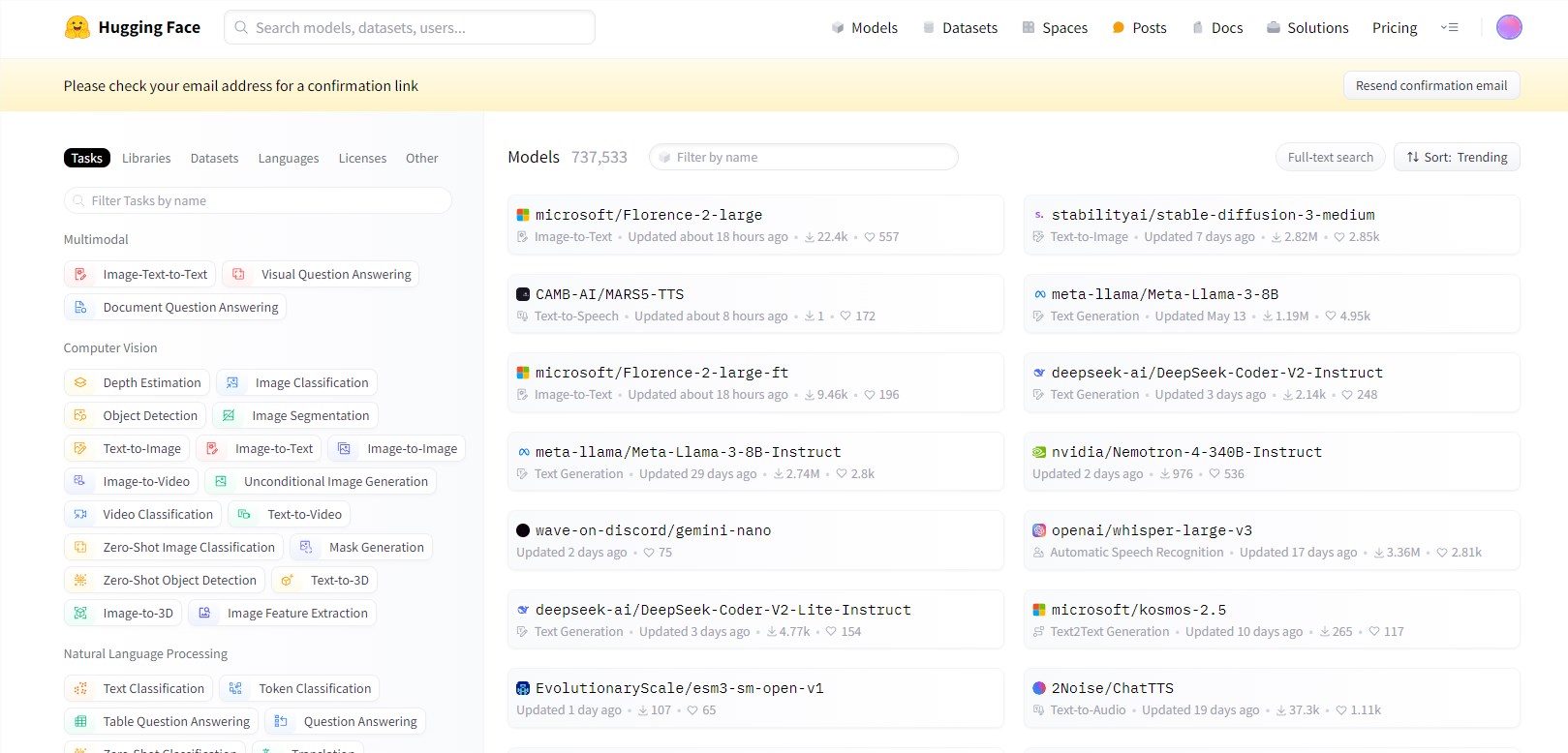

Open LLM Leaderboard 是一個用於衡量人工智慧語言模型進展的基準工具,現在它經過重新設計,提供了更嚴格和更細緻的評估。這項更新的推出正值人工智慧社群觀察到儘管不斷發布新模型,但突破性改進的速度放緩的時刻。

這一排行榜的更新引入了更複雜的評估指標,並提供詳細分析,以幫助用戶了解哪些測試對特定應用程式最為相關。這項舉措反映了人工智慧社群日益增長的認識,即僅憑性能數字本身是不足以評估模型在現實世界中的實用性的。

更新後的排行榜引入了更複雜的評估指標,並提供了詳細分析,以幫助用戶理解哪些測試對於特定應用程式最為相關。這反映了AI社群日益增長的意識:單純的表現數字不足以評估模型在現實世界中的實用性。排行榜的關鍵變化包括:

- 引入更具挑戰性的資料集,測試進階推理和現實世界知識應用。

- 實施多輪對話評估,更全面地評估模型的會話能力。

- 擴大非英語語言評估,以更好地代表全球AI能力。

- 加入指令遵循和少樣本學習的測試,這對於實際應用越來越重要。

這些更新旨在創建一個更全面、更具挑戰性的基準集合,更好地區分錶現最佳的模型,並識別改進領域。

劃重點:

⭐ Hugging Face 更新Open LLM Leaderboard,提供更嚴格、更細緻的評估,解決大語言模型效能提昇放緩的問題。

⭐ 更新包括引入更具挑戰性的資料集、實施多輪對話評估以及擴展非英語語言評估等內容,旨在創造更全面、更具挑戰性的基準。

⭐ LMSYS Chatbot Arena 的推出與Open LLM Leaderboard 形成互補,強調即時、動態的評估方式,為人工智慧評估帶來新的想法。

總而言之,Hugging Face 的Open LLM Leaderboard 更新標誌著人工智慧評估方法的一次重要升級,它將推動開源LLM領域更健康、更快速地發展,並最終促進更實用、更貼近實際應用的人工智慧技術的誕生。