Hugging Face 对其 Open LLM Leaderboard 排行榜进行了重大更新,此举旨在应对大语言模型(LLM)性能提升放缓的现状,并为开源人工智能社区提供更全面、更严格的评估标准。此次更新并非简单的调整,而是对评估指标和测试方法的全面升级,旨在更准确地反映LLM在实际应用中的能力,而非仅仅依赖于单一的性能数字。更新后的排行榜将对开源人工智能的发展方向产生深远的影响,推动模型朝着更实用、更可靠的方向发展。

Hugging Face 更新了其 Open LLM Leaderboard,这一举措将对开源人工智能开发的格局产生重大影响。此次改进在人工智能发展的关键时刻出现,因为研究人员和公司正面临大语言模型(LLMs)性能提升似乎出现停滞的局面。

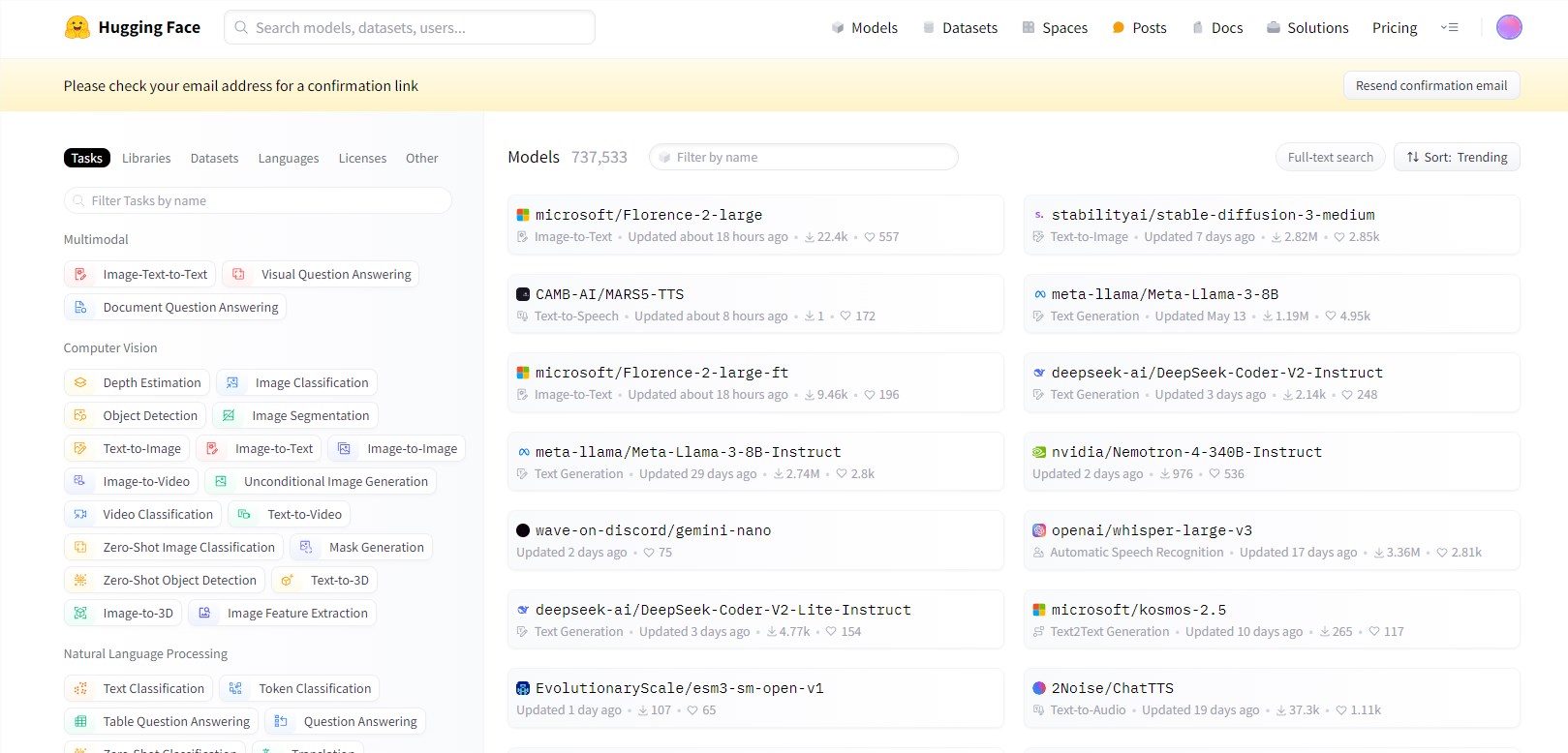

Open LLM Leaderboard 是一个用于衡量人工智能语言模型进展的基准工具,现在它经过重新设计,提供了更严格和更细致的评估。这一更新的推出正值人工智能社区观察到尽管不断发布新模型,但突破性改进的速度放缓的时刻。

这一排行榜的更新引入了更复杂的评估指标,并提供详细分析,以帮助用户了解哪些测试对特定应用最为相关。这一举措反映了人工智能社区日益增长的认识,即仅凭性能数字本身是不足以评估模型在现实世界中的实用性的。

更新后的排行榜引入了更复杂的评估指标,并提供了详细分析,帮助用户理解哪些测试对于特定应用最为相关。这反映了AI社区日益增长的意识:单纯的性能数字不足以评估模型在现实世界中的实用性。排行榜的关键变化包括:

- 引入更具挑战性的数据集,测试高级推理和现实世界知识应用。

- 实施多轮对话评估,更全面地评估模型的会话能力。

- 扩大非英语语言评估,以更好地代表全球AI能力。

- 加入指令遵循和少样本学习的测试,这对于实际应用越来越重要。

这些更新旨在创建一个更全面、更具挑战性的基准集合,更好地区分表现最佳的模型,并识别改进领域。

划重点:

⭐ Hugging Face 更新 Open LLM Leaderboard,提供更严格和更细致的评估,解决大语言模型性能提升放缓的问题。

⭐ 更新包括引入更具挑战性的数据集、实施多轮对话评估以及扩展非英语语言评估等内容,旨在创造更全面、更具挑战性的基准。

⭐ LMSYS Chatbot Arena 的推出与 Open LLM Leaderboard 形成互补,强调实时、动态的评估方式,为人工智能评估带来新的思路。

总而言之,Hugging Face 的 Open LLM Leaderboard 更新标志着人工智能评估方法的一次重要升级,它将推动开源LLM领域更健康、更快速地发展,并最终促进更实用、更贴近实际应用的人工智能技术的诞生。