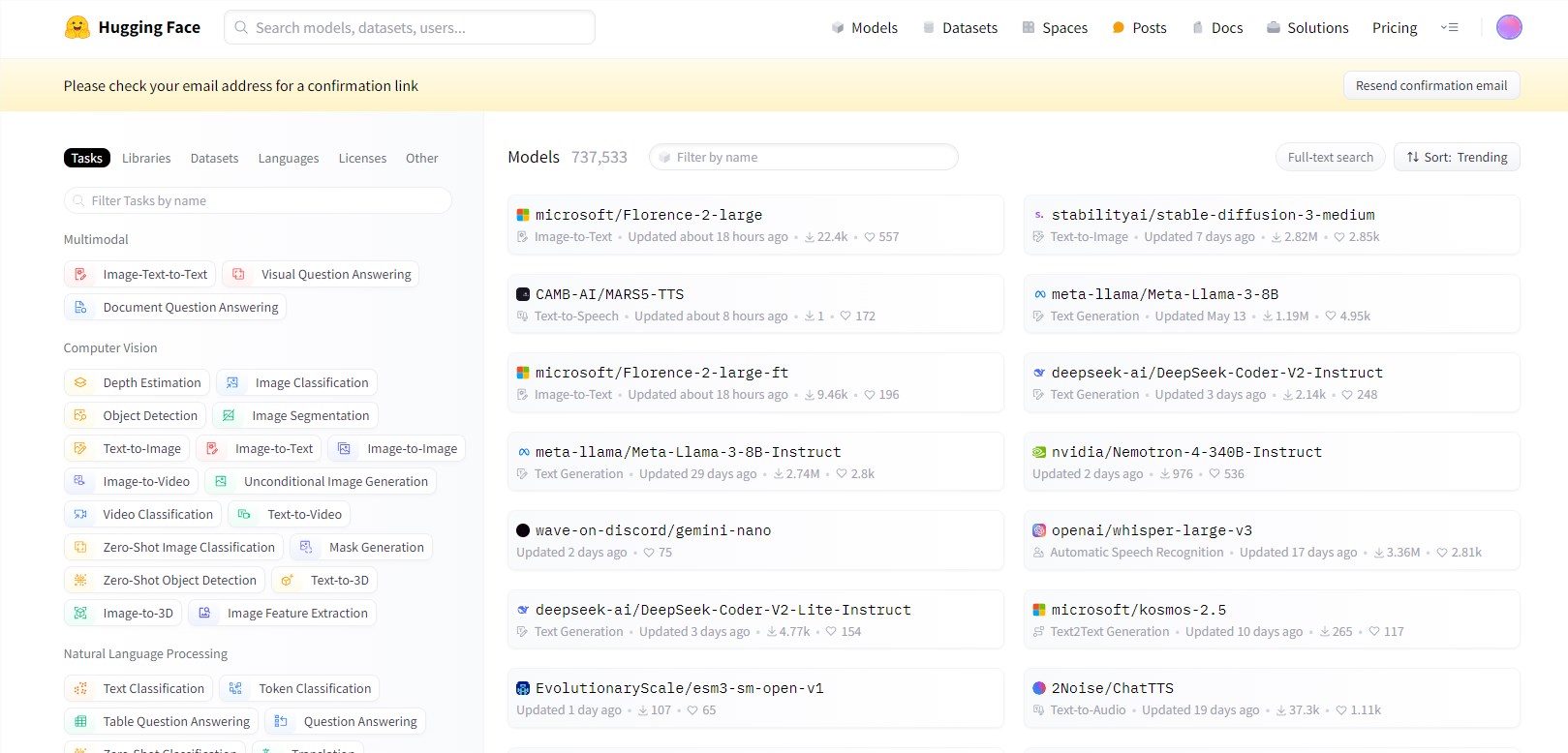

Hugging Face ha realizado una actualización importante en su clasificación Open LLM Leaderboard. Este movimiento tiene como objetivo responder a la desaceleración en las mejoras de rendimiento de los modelos de lenguaje grande (LLM) y proporcionar a la comunidad de inteligencia artificial de código abierto estándares de evaluación más completos y rigurosos. Esta actualización no es un simple ajuste, sino una actualización integral de los indicadores de evaluación y los métodos de prueba, con el objetivo de reflejar con mayor precisión las capacidades de LLM en aplicaciones reales, en lugar de depender únicamente de un único número de rendimiento. Las clasificaciones actualizadas tendrán un profundo impacto en la dirección del desarrollo de la inteligencia artificial de código abierto y promoverán el desarrollo de modelos en una dirección más práctica y confiable.

Hugging Face ha actualizado su Open LLM Leaderboard, una medida que tendrá un impacto significativo en el panorama del desarrollo de la inteligencia artificial de código abierto. Las mejoras llegan en un momento crítico en el desarrollo de la inteligencia artificial, cuando los investigadores y las empresas se enfrentan a una mejora del rendimiento aparentemente estancada en grandes modelos de lenguaje (LLM).

La tabla de clasificación Open LLM, una herramienta de referencia utilizada para medir el progreso en modelos de lenguaje de inteligencia artificial, ha sido rediseñada para proporcionar una evaluación más rigurosa y granular. La actualización llega en un momento en que la comunidad de inteligencia artificial está observando una desaceleración en el ritmo de mejoras revolucionarias a pesar del constante lanzamiento de nuevos modelos.

Esta actualización del ranking introduce métricas de evaluación más sofisticadas y proporciona un análisis detallado para ayudar a los usuarios a comprender qué pruebas son más relevantes para aplicaciones específicas. La medida refleja un creciente reconocimiento en la comunidad de IA de que las cifras de rendimiento por sí solas son insuficientes para evaluar la utilidad de un modelo en el mundo real.

Las clasificaciones actualizadas introducen métricas de evaluación más sofisticadas y brindan análisis detallados para ayudar a los usuarios a comprender qué pruebas son más relevantes para aplicaciones específicas. Esto refleja una creciente conciencia en la comunidad de IA de que las cifras de rendimiento por sí solas son insuficientes para evaluar la utilidad de un modelo en el mundo real. Los cambios clave en la tabla de clasificación incluyen:

- Introducir conjuntos de datos más desafiantes para probar el razonamiento avanzado y las aplicaciones de conocimiento del mundo real.

- Implementar una evaluación de diálogo de múltiples rondas para evaluar de manera más integral las capacidades conversacionales del modelo.

- Ampliar las evaluaciones de idiomas distintos del inglés para representar mejor las capacidades globales de IA.

- Agregar pruebas para seguir instrucciones y aprender en pocas oportunidades, que son cada vez más importantes para aplicaciones prácticas.

Estas actualizaciones están diseñadas para crear un conjunto de puntos de referencia más completo y desafiante, distinguir mejor los modelos de mejor rendimiento e identificar áreas de mejora.

Reflejos:

⭐ Hugging Face actualiza la tabla de clasificación Open LLM para proporcionar una evaluación más rigurosa y detallada para resolver el problema de la lenta mejora del rendimiento de modelos de lenguaje grandes.

⭐ Las actualizaciones incluyen la introducción de conjuntos de datos más desafiantes, la implementación de evaluaciones conversacionales de rondas múltiples y la expansión de evaluaciones de idiomas distintos del inglés para crear puntos de referencia más completos y desafiantes.

⭐ El lanzamiento de LMSYS Chatbot Arena complementa la tabla de clasificación Open LLM, enfatizando métodos de evaluación dinámicos y en tiempo real, aportando nuevas ideas a la evaluación de inteligencia artificial.

Con todo, la actualización de la tabla de clasificación Open LLM de Hugging Face marca una mejora importante en el método de evaluación de la inteligencia artificial. Promoverá el desarrollo más sano y rápido del campo LLM de código abierto y, en última instancia, promoverá el nacimiento de una tecnología de inteligencia artificial que sea más práctica y práctica. más cerca de las aplicaciones prácticas.