Hugging Face a procédé à une mise à jour majeure de son classement Open LLM Leaderboard. Cette décision vise à répondre au ralentissement des améliorations des performances des grands modèles de langage (LLM) et à fournir à la communauté de l'intelligence artificielle open source des normes d'évaluation plus complètes et plus rigoureuses. Cette mise à jour n'est pas un simple ajustement, mais une mise à niveau complète des indicateurs d'évaluation et des méthodes de test, visant à refléter plus précisément les capacités du LLM dans les applications réelles, plutôt que de s'appuyer uniquement sur un seul chiffre de performance. Les classements mis à jour auront un impact profond sur l'orientation du développement de l'intelligence artificielle open source et favoriseront le développement de modèles dans une direction plus pratique et plus fiable.

Hugging Face a mis à jour son classement Open LLM, une décision qui aura un impact significatif sur le paysage du développement de l'intelligence artificielle open source. Ces améliorations surviennent à un moment critique du développement de l’intelligence artificielle, alors que les chercheurs et les entreprises sont confrontés à une amélioration des performances apparemment bloquée dans les grands modèles de langage (LLM).

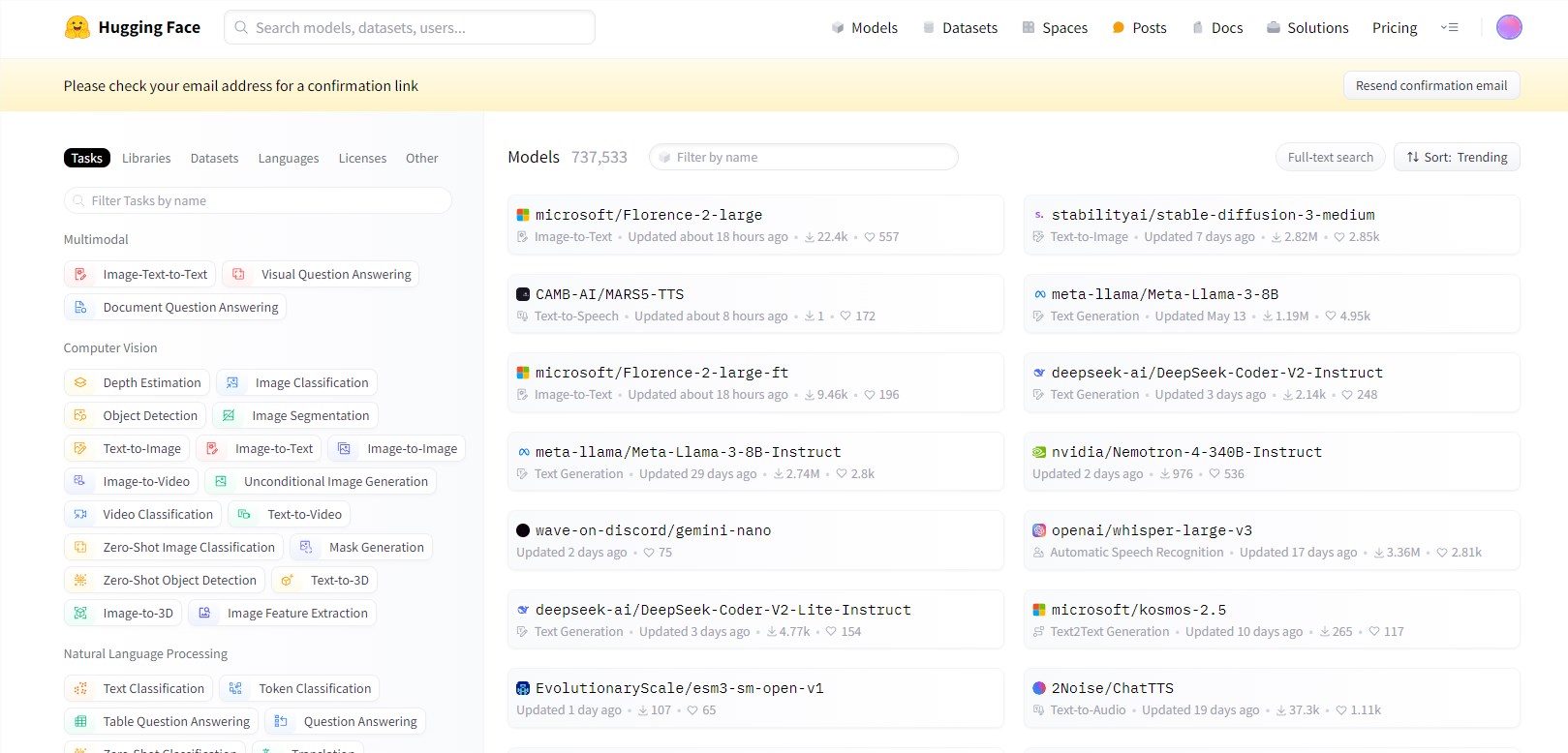

L'Open LLM Leaderboard, un outil de référence utilisé pour mesurer les progrès dans les modèles linguistiques d'intelligence artificielle, a été repensé pour fournir une évaluation plus rigoureuse et granulaire. La mise à jour intervient à un moment où la communauté de l'intelligence artificielle observe un ralentissement du rythme des améliorations révolutionnaires malgré la sortie constante de nouveaux modèles.

Cette mise à jour du classement introduit des mesures d'évaluation plus sophistiquées et fournit une analyse détaillée pour aider les utilisateurs à comprendre quels tests sont les plus pertinents pour des applications spécifiques. Cette décision reflète une reconnaissance croissante au sein de la communauté de l'IA du fait que les chiffres de performances à eux seuls ne suffisent pas pour évaluer l'utilité d'un modèle dans le monde réel.

Les classements mis à jour introduisent des mesures d'évaluation plus complexes et fournissent une analyse détaillée pour aider les utilisateurs à comprendre quels tests sont les plus pertinents pour des applications spécifiques. Cela reflète une prise de conscience croissante au sein de la communauté de l'IA que les chiffres de performances à eux seuls ne suffisent pas pour évaluer l'utilité d'un modèle dans le monde réel. Les principaux changements apportés au classement incluent :

- Introduire des ensembles de données plus complexes pour tester le raisonnement avancé et les applications de connaissances du monde réel.

- Mettre en œuvre une évaluation de dialogue à plusieurs tours pour évaluer de manière plus complète les capacités conversationnelles du modèle.

- Élargir les évaluations de langues autres que l'anglais pour mieux représenter les capacités mondiales de l'IA.

- Ajouter des tests pour le suivi des instructions et l'apprentissage en quelques étapes, qui sont de plus en plus importants pour les applications pratiques.

Ces mises à jour visent à créer un ensemble de références plus complet et plus stimulant, à mieux distinguer les modèles les plus performants et à identifier les domaines à améliorer.

Souligner:

⭐ Hugging Face met à jour le classement Open LLM pour fournir une évaluation plus rigoureuse et détaillée afin de résoudre le problème de la lente amélioration des performances des grands modèles de langage.

⭐ Les mises à jour incluent l'introduction d'ensembles de données plus complexes, la mise en œuvre d'évaluations conversationnelles à plusieurs tours et l'expansion des évaluations de langues autres que l'anglais pour créer des références plus complètes et plus stimulantes.

⭐ Le lancement de LMSYS Chatbot Arena complète l'Open LLM Leaderboard, en mettant l'accent sur les méthodes d'évaluation dynamiques et en temps réel, apportant de nouvelles idées à l'évaluation de l'intelligence artificielle.

Dans l'ensemble, la mise à jour du classement Open LLM de Hugging Face marque une mise à niveau importante dans la méthode d'évaluation de l'intelligence artificielle. Elle favorisera un développement plus sain et plus rapide du domaine LLM open source et, à terme, favorisera la naissance d'une technologie d'intelligence artificielle plus pratique et plus rapide. plus proche des applications pratiques.