ICLR2023紙的代碼和數據集“知識圖上的多模式類比推理”

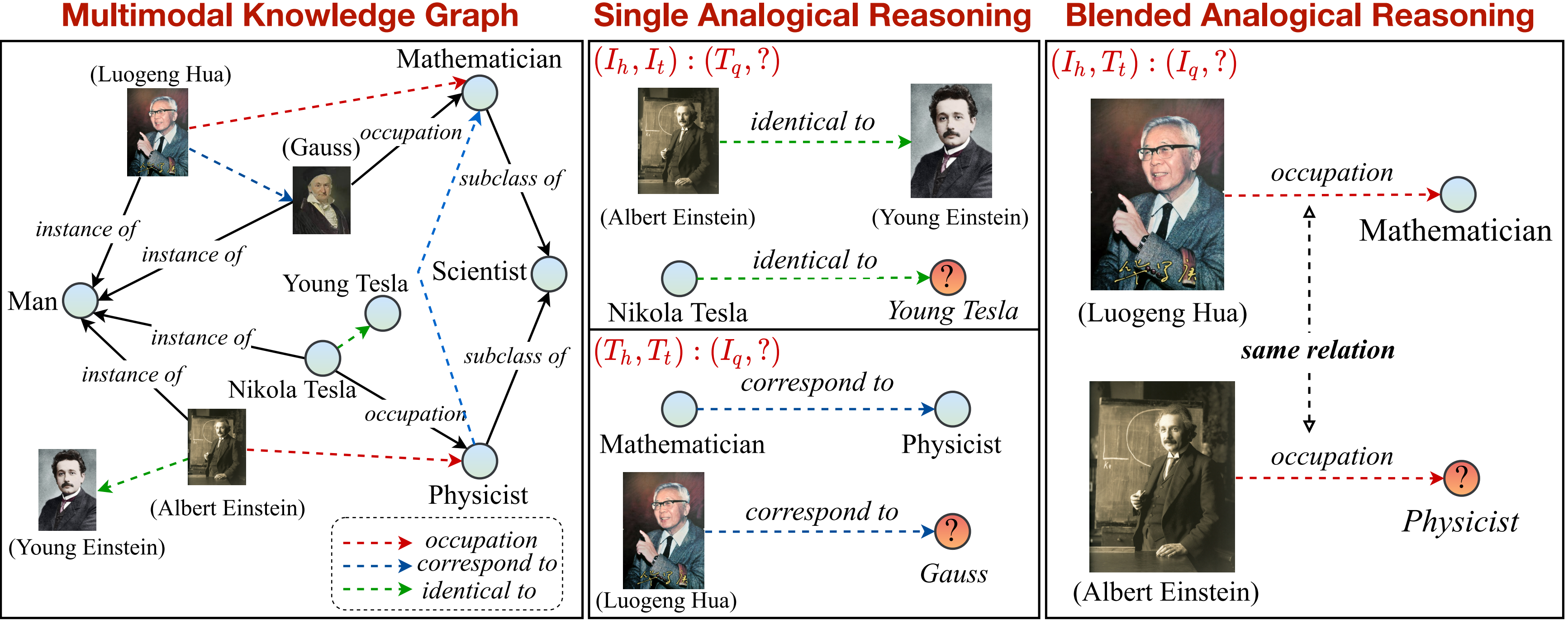

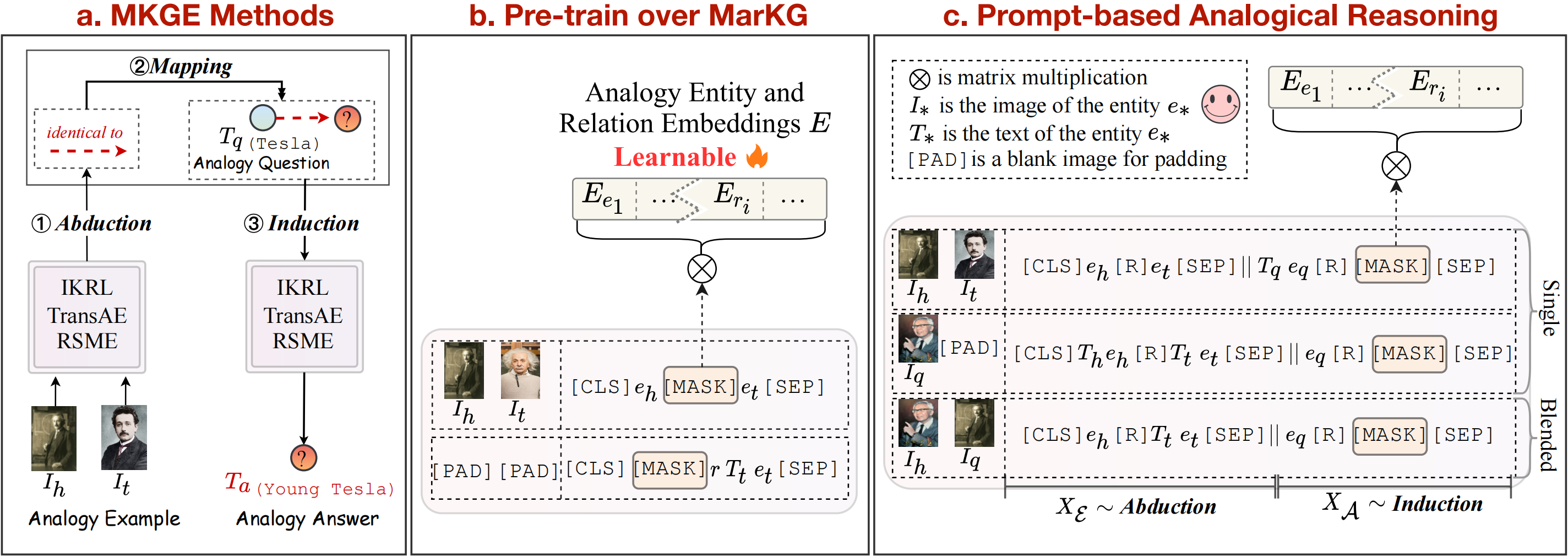

在這項工作中,我們提出了一項關於知識圖的多模式類似推理的新任務。多模式類似推理任務的概述可以看如下:

我們提供一個知識圖,以支持並將任務進一步分為單個和混合模式。請注意,用虛線標記的關係(

pip install -r requirements.txt

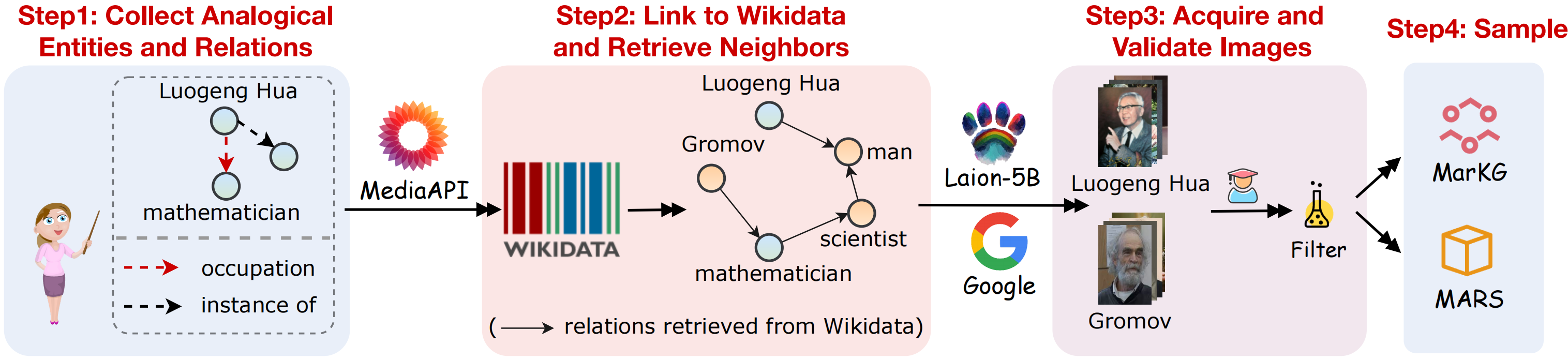

為了支持多模式類似推理任務,我們收集了多模式知識圖數據集標記和多模式類似推理數據集火星。數據收集的視覺輪廓如下圖所示:

我們收集數據集以下以下步驟:

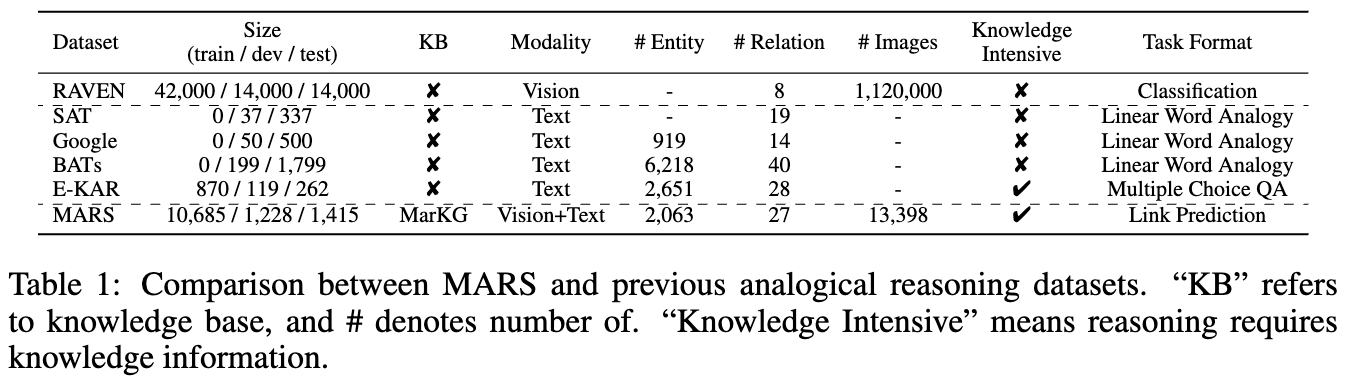

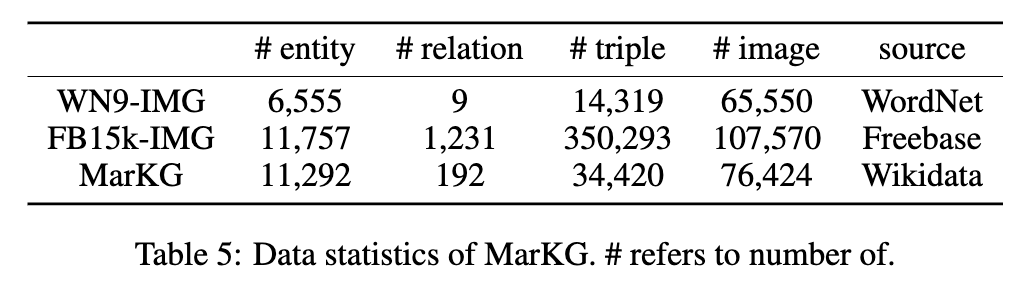

兩個數據集的統計數據如下圖所示:

我們將文本數據放在MarT/dataset/下方,可以通過Google Drive或Baidu Pan(Terabox)(代碼:7HOC)下載圖像數據,並放置在MarT/dataset/MARS/images上。請參閱MART以獲取詳細信息。

文件的預期結構是:

MKG_Analogy

|-- M-KGE # multimodal knowledge representation methods

| |-- IKRL_TransAE

| |-- RSME

|-- MarT

| |-- data # data process functions

| |-- dataset

| | |-- MarKG # knowledge graph data

| | |-- MARS # analogical reasoning data

| |-- lit_models # pytorch_lightning models

| |-- models # source code of models

| |-- scripts # running scripts

| |-- tools # tool function

| |-- main.py # main function

|-- resources # image resources

|-- requirements.txt

|-- README.md

我們選擇一些基線方法來建立火星上的初始基準結果,包括多模式知識表示方法(IKRL,Transae,RSME),預訓練的視覺模型(Visualbert,Vilbert,Vilbert,Vilt,Flava)和多模式知識圖形完成方法(MKGGEFFORMER)。

此外,我們遵循結構映射理論,以將暫停映射誘導視為多模式知識表示方法的顯式管道步驟。至於基於變壓器的方法,我們進一步提出了一個新型框架,該框架將這三個步驟隱含結合起來,以完成多模式的類似推理任務端到端,可以避免在類似推理期間避免錯誤傳播。基線方法的概述可以在上圖中看到。

我們通過Transae框架重現IKRL模型,以評估IKRL,以下代碼運行:

cd M-KGE/IKRL_TransAE

python IKRL.py您可以分別在IKRL.py中修改finetune和analogy參數,從而選擇預訓練/微調和Transe/類比。

要在IKRL上評估,請按照代碼運行:

cd M-KGE/IKRL_TransAE

python TransAE.py您可以分別在TransAE.py中修改finetune和analogy參數,從而選擇預訓練/微調和TRANSE/類比。

我們僅提供RSME的一部分數據。要在RSME上進行評估,您需要通過以下腳本生成完整數據:

cd M-KGE/RSME

python image_encoder.py # -> analogy_vit_best_img_vec.pickle

python utils.py # -> img_vec_id_analogy_vit.pickle首先,預先培訓模型超過Markg:

bash run.sh然後修改--checkpoint參數,然後在火星上微調模型:

bash run_finetune.sh有關上述模型的更多培訓詳細信息可能是指他們的官方存儲庫。

我們利用MART框架用於基於變壓器的模型。 Mart包含兩個步驟:預訓練和微調。

為了快速訓練模型,我們使用此腳本預先對圖像數據進行編碼(請注意,編碼數據的大小約為7GB):

cd MarT

python tools/encode_images_data.py以Mkgformer為例,首先通過以下腳本預先培訓模型:

bash scripts/run_pretrain_mkgformer.sh預訓練後,通過以下腳本微調模型:

bash scripts/run_finetune_mkgformer.sh ?在此Google驅動器上的微調和預訓練短語中,我們提供了基於變壓器的模型的最佳檢查點。下載它們並在scripts/run_finetune_xxx.sh中添加--only_test進行測試實驗。

如果您使用或擴展我們的工作,請如下引用紙張:

@inproceedings {

zhang2023multimodal,

title = { Multimodal Analogical Reasoning over Knowledge Graphs } ,

author = { Ningyu Zhang and Lei Li and Xiang Chen and Xiaozhuan Liang and Shumin Deng and Huajun Chen } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=NRHajbzg8y0P }

}