Code und Datensätze für das ICLR2023 -Papier "Multimodal analoges Denken über Wissensgraphen"

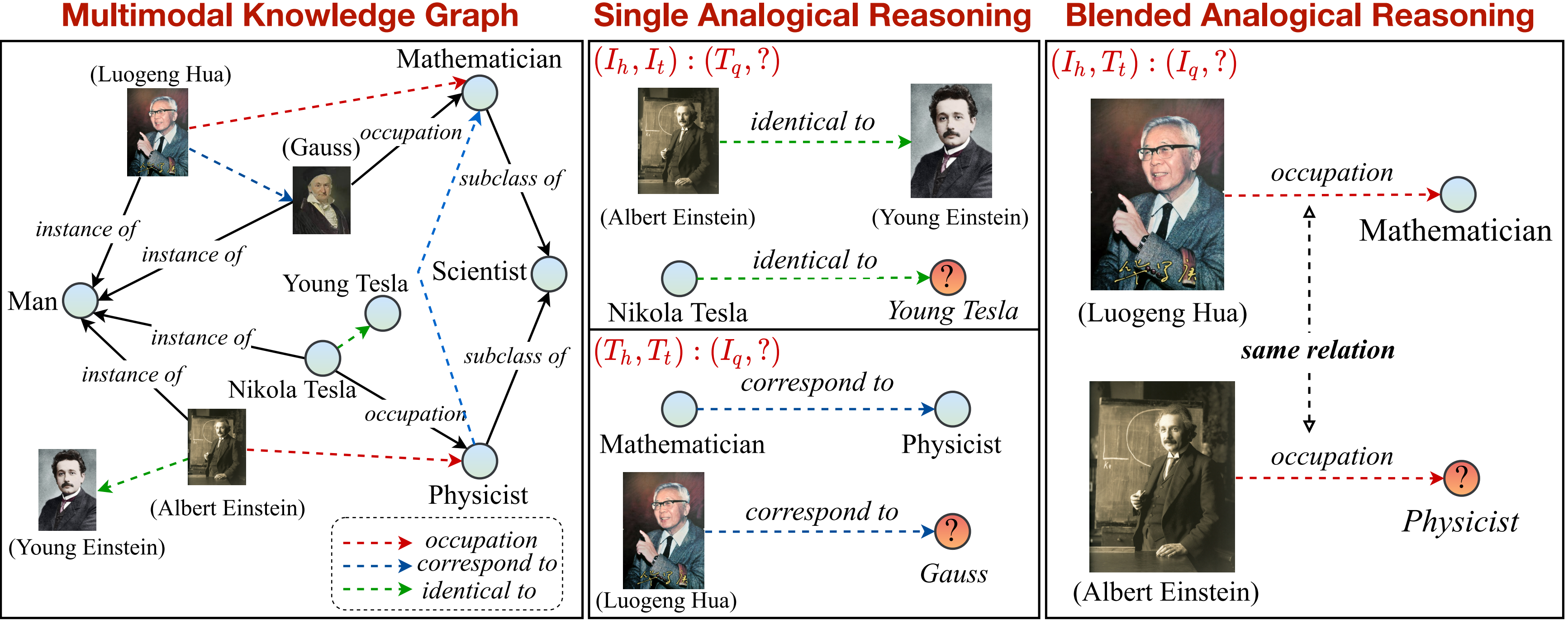

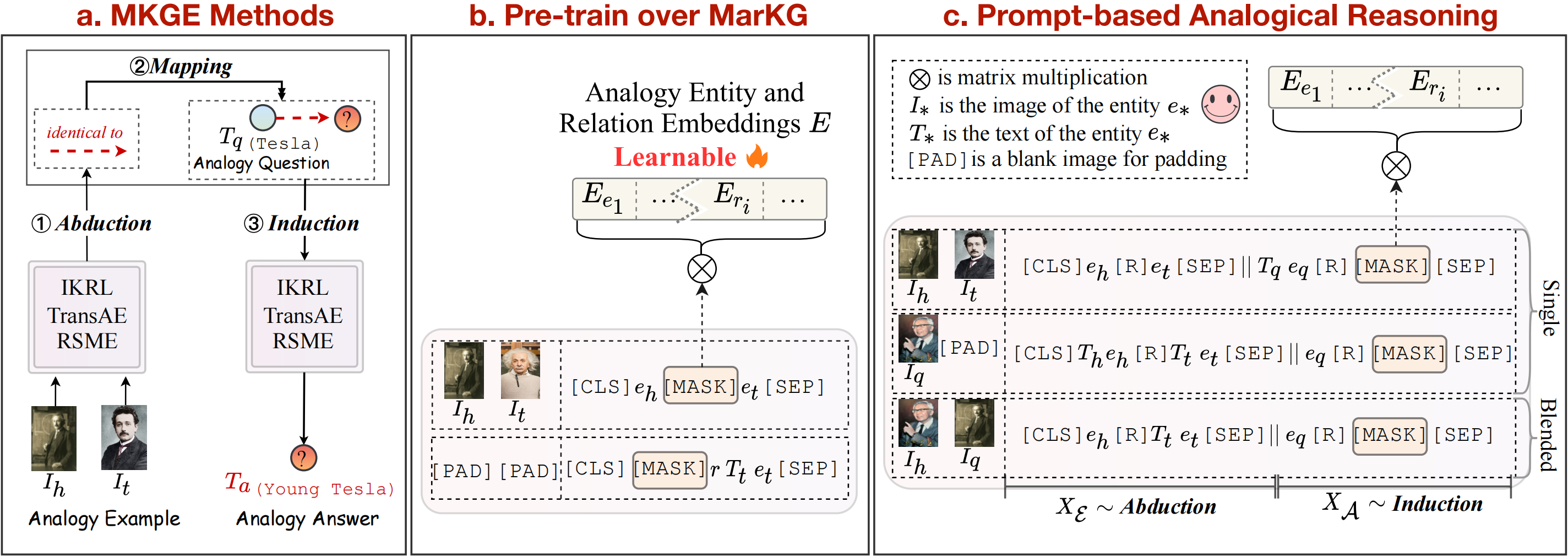

In dieser Arbeit schlagen wir eine neue Aufgabe des multimodalen analogen Denkens über Wissensgraphen vor. Ein Überblick über die multimodale analoge Argumentationsaufgabe kann wie folgt gesehen werden:

Wir bieten ein Wissensgraphen, um die Aufgabe in einzelne und gemischte Muster zu unterteilen und weiter zu unterteilen. Beachten Sie, dass die durch gestrichelte Pfeile gekennzeichnete Beziehung (

pip install -r requirements.txt

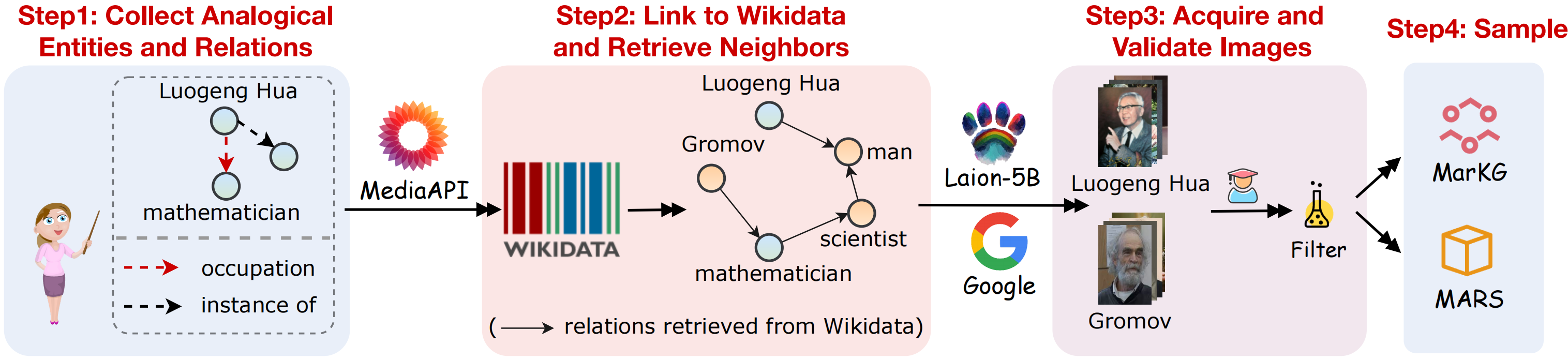

Um die multimodale analoge Argumentationsaufgabe zu unterstützen, sammeln wir ein multimodales Wissensgraphen -Datensatz -Markg und einen multimodalen analogen Argumentationsdatensatz -Mars. Ein visueller Umriss der Datenerfassung, wie in folgenden Abbildung gezeigt:

Wir sammeln die folgenden Datensätze folgenden Schritten:

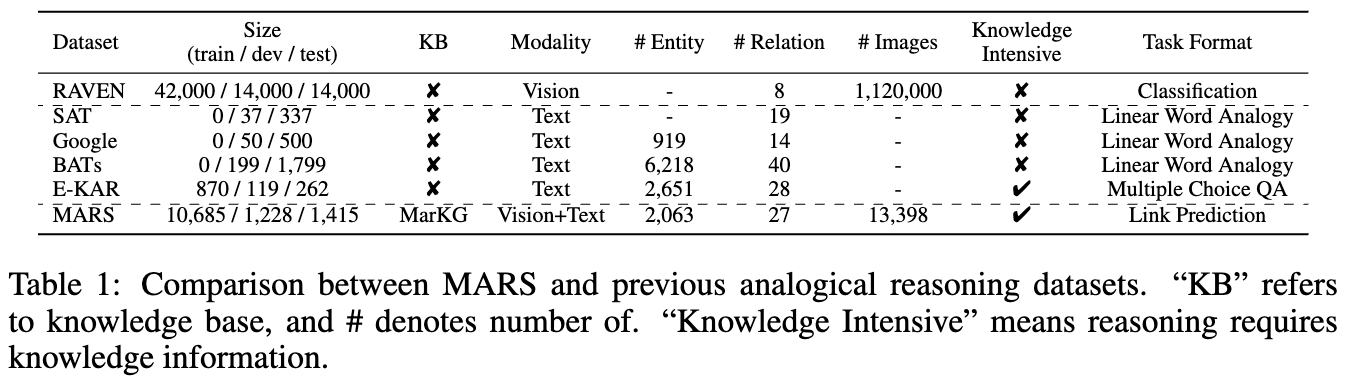

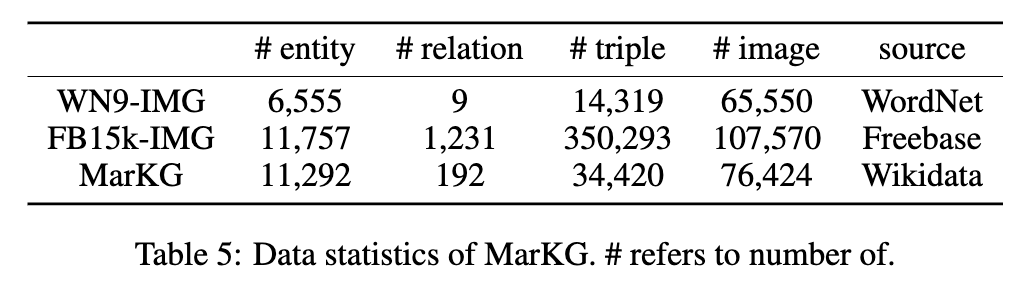

Die Statistiken der beiden Datensätze sind in den folgenden Abbildungen dargestellt:

Wir setzen die Textdaten unter MarT/dataset/ , und die Bilddaten können über das Google Drive oder die Baidu Pan (Terabox) (Code: 7HOC) heruntergeladen und auf MarT/dataset/MARS/images platziert werden. Weitere Informationen finden Sie in Mart.

Die erwartete Struktur von Dateien ist:

MKG_Analogy

|-- M-KGE # multimodal knowledge representation methods

| |-- IKRL_TransAE

| |-- RSME

|-- MarT

| |-- data # data process functions

| |-- dataset

| | |-- MarKG # knowledge graph data

| | |-- MARS # analogical reasoning data

| |-- lit_models # pytorch_lightning models

| |-- models # source code of models

| |-- scripts # running scripts

| |-- tools # tool function

| |-- main.py # main function

|-- resources # image resources

|-- requirements.txt

|-- README.md

Wir wählen einige Basismethoden aus, um die anfänglichen Benchmark-Ergebnisse auf dem Mars zu ermitteln, einschließlich multimodaler Wissensdarstellungsmethoden (IKRL, Transae, RSME), vorgebildeten Sehvermögensmodellen (Visualbert, Vilbert, Vilt, Flava) und einer multimodalen Wissensgrafik-Vervollständigungsmethode (MKGFORMER).

Darüber hinaus folgen wir der Struktur-Mapping-Theorie, um die Abhilfe-Induktion als explizite Pipline-Schritte für multimodale Wissensdarstellungsmethoden zu betrachten. In Bezug auf Transformator-basierte Methoden schlagen wir Mart weiter vor, ein neuartiges Rahmen, das diese drei Schritte implizit kombiniert, um die multimodale analoge Argumentation von End-to-End-Aufgabe zu erreichen, die die Fehlerausbreitung während des analogen Arguments vermeiden kann. Der Überblick über die Grundlinienmethoden ist in der obigen Abbildung zu sehen.

Wir reproduzieren die IKRL -Modelle über Transae -Framework, um auf IKRL zu bewerten, und läuft den folgenden Code:

cd M-KGE/IKRL_TransAE

python IKRL.py Sie können Pre-Train/Fine-Tune- und Transe/Analogie wählen, indem Sie finetune und analogy Parameter in IKRL.py modifizieren.

Um auf IKRL zu bewerten, laufende folgende Code:

cd M-KGE/IKRL_TransAE

python TransAE.py Sie können Pre-Train/Fine-Tune- und Transe/Analogie wählen, indem Sie finetune bzw. analogy Parameter in TransAE.py modifizieren.

Wir stellen nur einen Teil der Daten für RSME bereit. Um auf RSME zu bewerten, müssen Sie die vollständigen Daten generieren, indem Sie folgende Skripte folgen:

cd M-KGE/RSME

python image_encoder.py # -> analogy_vit_best_img_vec.pickle

python utils.py # -> img_vec_id_analogy_vit.pickleErstens, um die Modelle über Markg vorzubinden:

bash run.sh Ändern Sie dann den Parameter --checkpoint und optimieren Sie die Modelle auf dem Mars:

bash run_finetune.shWeitere Trainingsdetails zu den oben genannten Modellen können sich auf ihre offiziellen Repositorys beziehen.

Wir nutzen das Mart-Framework für transformatorbasierte Modelle. Mart enthält zwei Schritte: Vorverzügigkeit und Feinabstimmung.

Um die Modelle schnell zu trainieren, codieren wir die Bilddaten im Voraus mit diesem Skript (beachten Sie, dass die Größe der codierten Daten etwa 7 GB beträgt):

cd MarT

python tools/encode_images_data.pyWenn Sie MKGFORMER als Beispiel einnehmen, verarbeiten Sie das Modell zuerst das Modell über das folgende Skript:

bash scripts/run_pretrain_mkgformer.shFühren Sie das Modell nach dem Vorbild ein, über das folgende Skript:

bash scripts/run_finetune_mkgformer.sh ? Wir bieten die besten Checkpoints von Transformator-basierten Modellen während der Feinabstimmung und der Vorausbildung in diesem Google Drive. Laden Sie sie herunter und fügen Sie --only_test in scripts/run_finetune_xxx.sh hinzu, um Experimente zu testen.

Wenn Sie unsere Arbeit verwenden oder erweitern, zitieren Sie bitte das Papier wie folgt:

@inproceedings {

zhang2023multimodal,

title = { Multimodal Analogical Reasoning over Knowledge Graphs } ,

author = { Ningyu Zhang and Lei Li and Xiang Chen and Xiaozhuan Liang and Shumin Deng and Huajun Chen } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=NRHajbzg8y0P }

}